Hinton神经网络公开课11 Hopfield nets and Boltzmann machines

这节课介绍Hopfield Nets,这是80年代神经网络复兴的主要原因之一。这种简单优美的模型将记忆储存为激活值中的模式。然后介绍带有随机隐藏单元的Stochastic Hopfield nets(即玻尔兹曼机),及其搜索算法,为下节课的...

这节课介绍Hopfield Nets,这是80年代神经网络复兴的主要原因之一。这种简单优美的模型将记忆储存为激活值中的模式。然后介绍带有随机隐藏单元的Stochastic Hopfield nets(即玻尔兹曼机),及其搜索算法,为下节课的...

这节课讲了为什么要综合多个模型,好处与原理、具体做法等。讲解了贝叶斯学习中的神经网络模型混合、马尔科夫蒙特卡洛方法,以及从新角度阐释更高效的Dropout。 综合网络:偏置方差均衡 训练数据少,容易过拟合。综合多个模型可以防止过拟合,特别是...

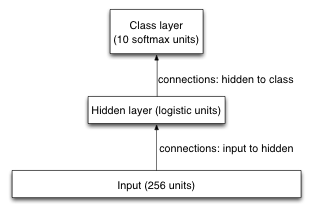

这次练习在USPS手写邮政编码数据集上训练识别模型,重点是训练神经网络时的各种调参技巧。 数据集 数据全集有11000张图片,其中1000作为训练集,1000作为验证集,9000作为测试集(训练集与测试集的比例不同寻常,很容易过拟合,富有挑...

这节课介绍防止模型过拟合的各种方法,给出了正则化项、惩罚因子的贝叶斯解读;并展示了基于贝叶斯解读的一种实践有效的惩罚因子调参方法。 复习:过拟合 训练数据中不光有正确的规律,而且还有偶然的规律(采样误差,只取决于训练实例的选择)。拟合模型的...

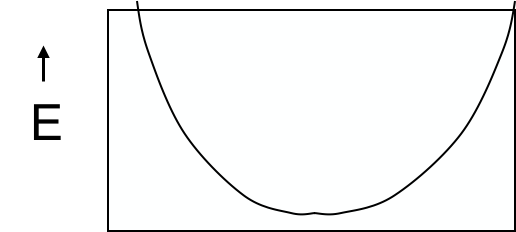

首先简要介绍Hessian-Free优化理论。这是块硬骨头,并不要求一定掌握。 在给定方向上的移动能够将误差降低多少 在训练神经网络的时候,我们想要在error surface上尽量多地下降。梯度有了之后,具体能够迈多大一步呢?以二次曲线为...

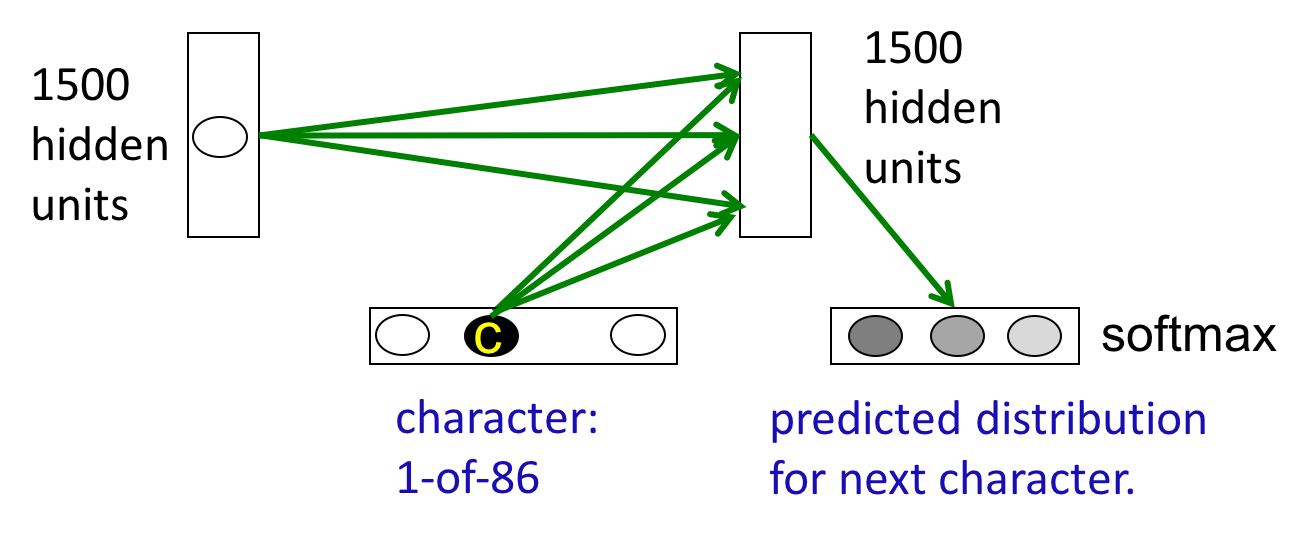

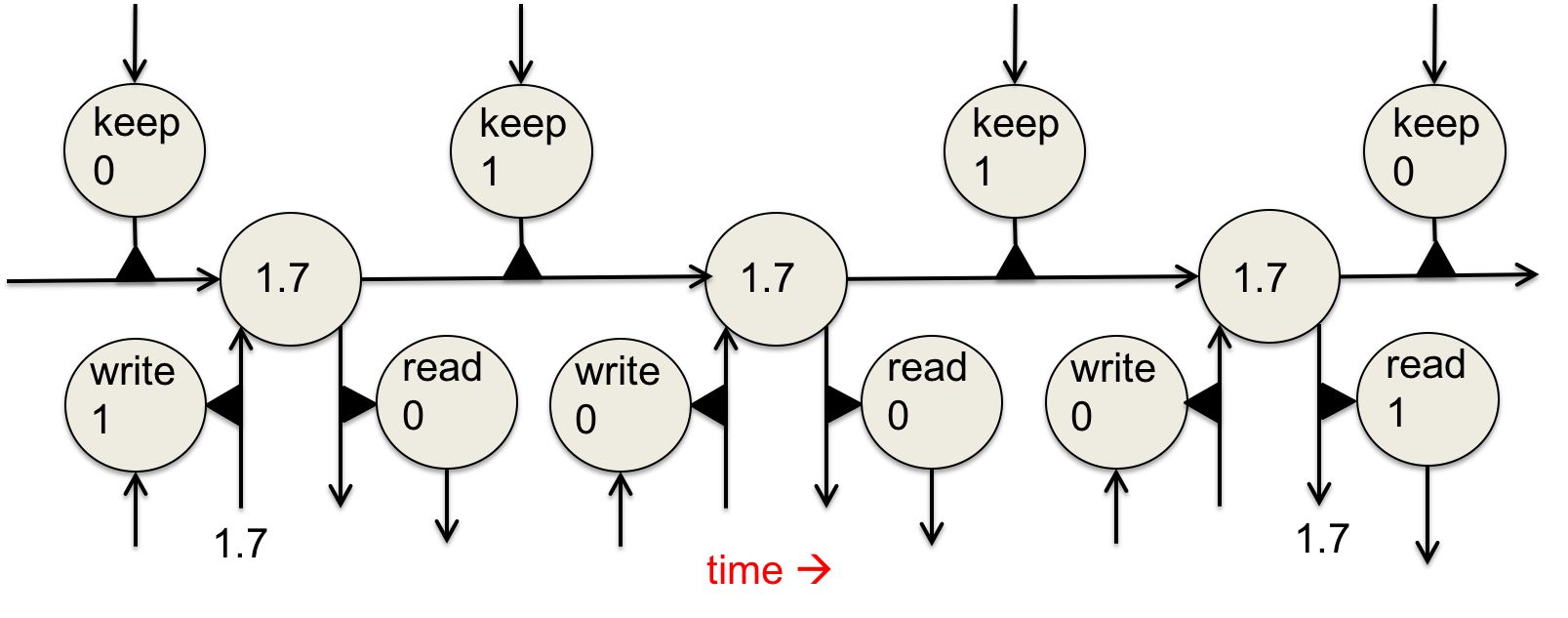

首先复习一下常见序列模型,包括BiGram、linear dynamic system和HMM。通过对简单模型的比较学习,加深对RNN的理解。 为序列建模 目的是将一个输入序列转化为一个输出序列,如机器翻译、语音识别。 当不区分输入和输出序...

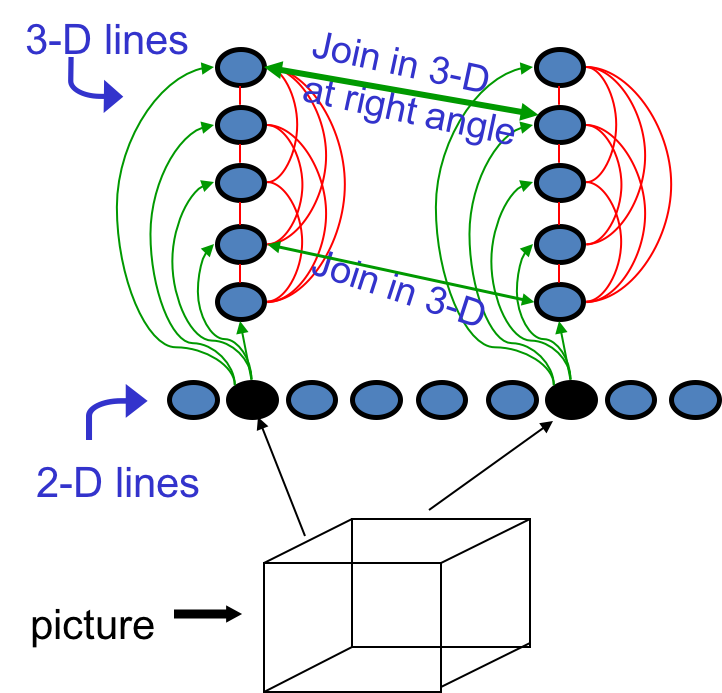

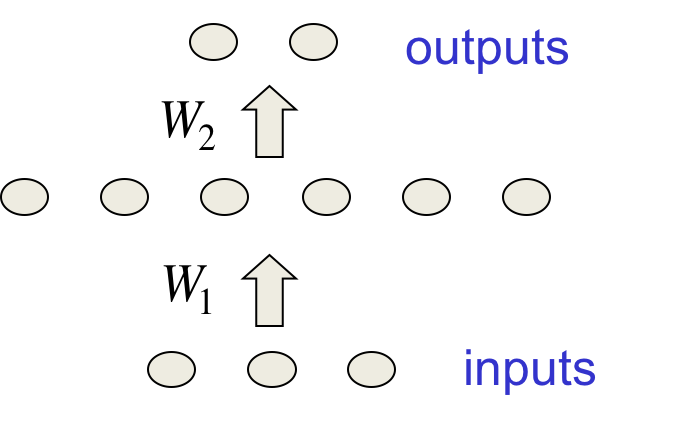

这节课围绕着如何加快训练速度这个现实问题,从理论上分析了学习过程中的问题,介绍了许多实践中有效的锦囊妙计。 复习 先复习一下优化理论中的几个概念。 weight space中的error surface 以误差为y轴,每个权值为x轴可以得到...

斯坦福UFLDL中CNN剩下两章的笔记,辅以两次编程练习,至此完成了CNN的学习。 梯度下降概述 诸如L-BFGS之类的批优化方法每次更新都使用整个训练集,能够收敛到局部最优。因为要设置的超参数很少,所以很好用,matlab里也有许多类似m...

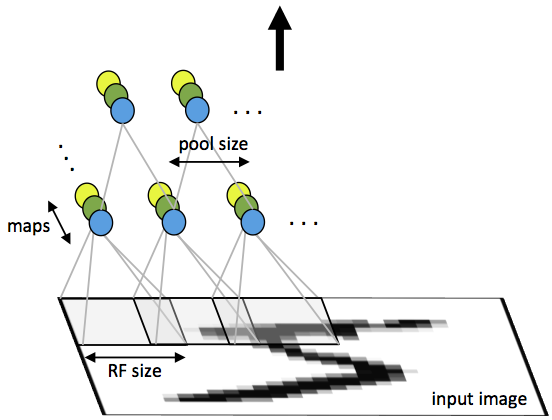

这是关于斯坦福大学的UFLDL(Unsupervised Feature Learning and Deep Learning)中CNN一章的笔记,用来补足Hinton神经网络公开课略过的部分。 概览 前几次练习解决了处理低分辨率图片的问题...

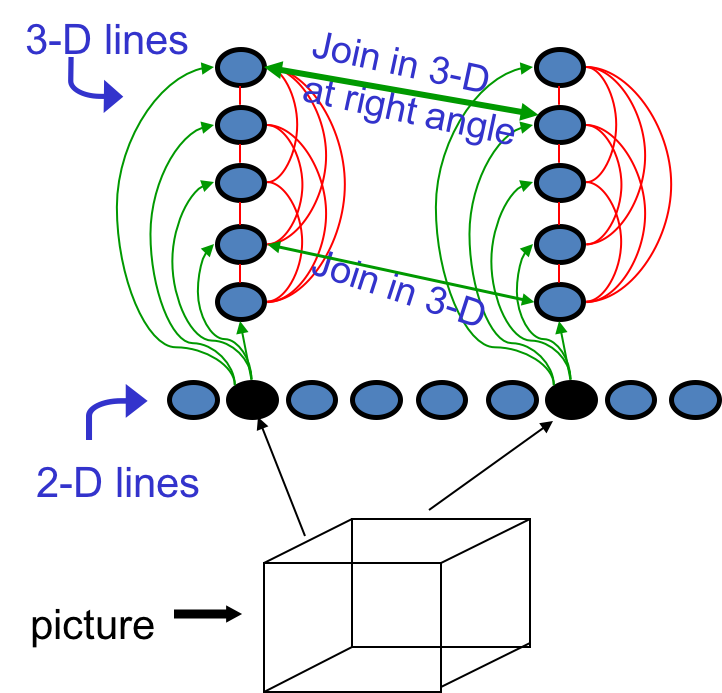

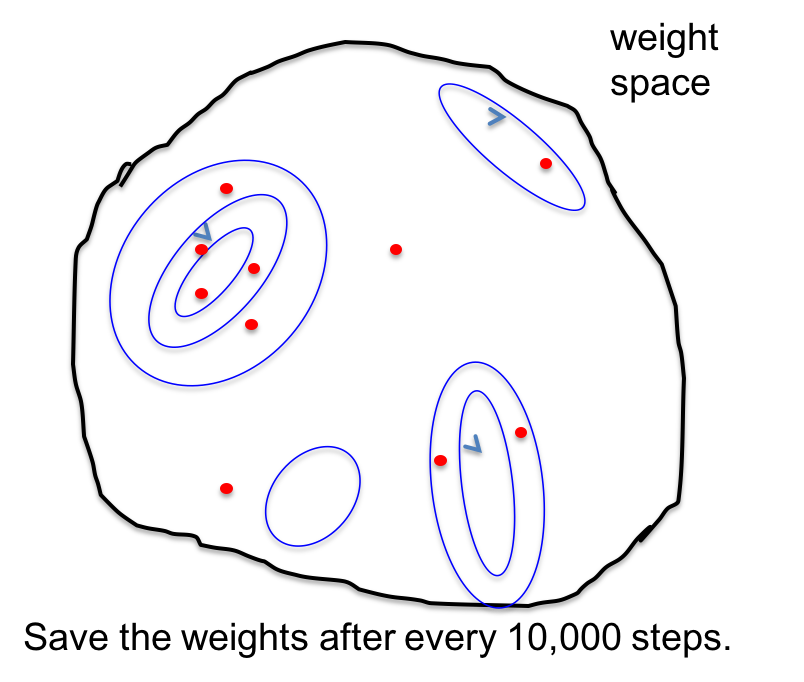

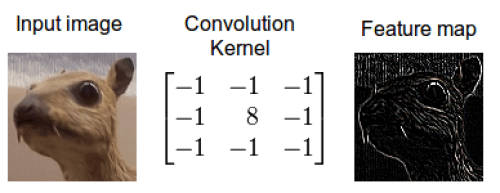

译自Tim Dettmers的Understanding Convolution in Deep Learning。有太多的公开课、教程在反复传颂卷积神经网络的好,却都没有讲什么是“卷积”,似乎默认所有读者都有相关基础。这篇外文既友好又深入...