CS224n笔记7 TensorFlow入门

这节课由TA们介绍了TF里的几个基本概念(graph、variable、placeholder、session、fetch、feed),基本流程。然后现场敲代码演示如何在TF上跑线性回归和训练词向量。与优达学城的《深度学习公开课》不同之处在...

这节课由TA们介绍了TF里的几个基本概念(graph、variable、placeholder、session、fetch、feed),基本流程。然后现场敲代码演示如何在TF上跑线性回归和训练词向量。与优达学城的《深度学习公开课》不同之处在...

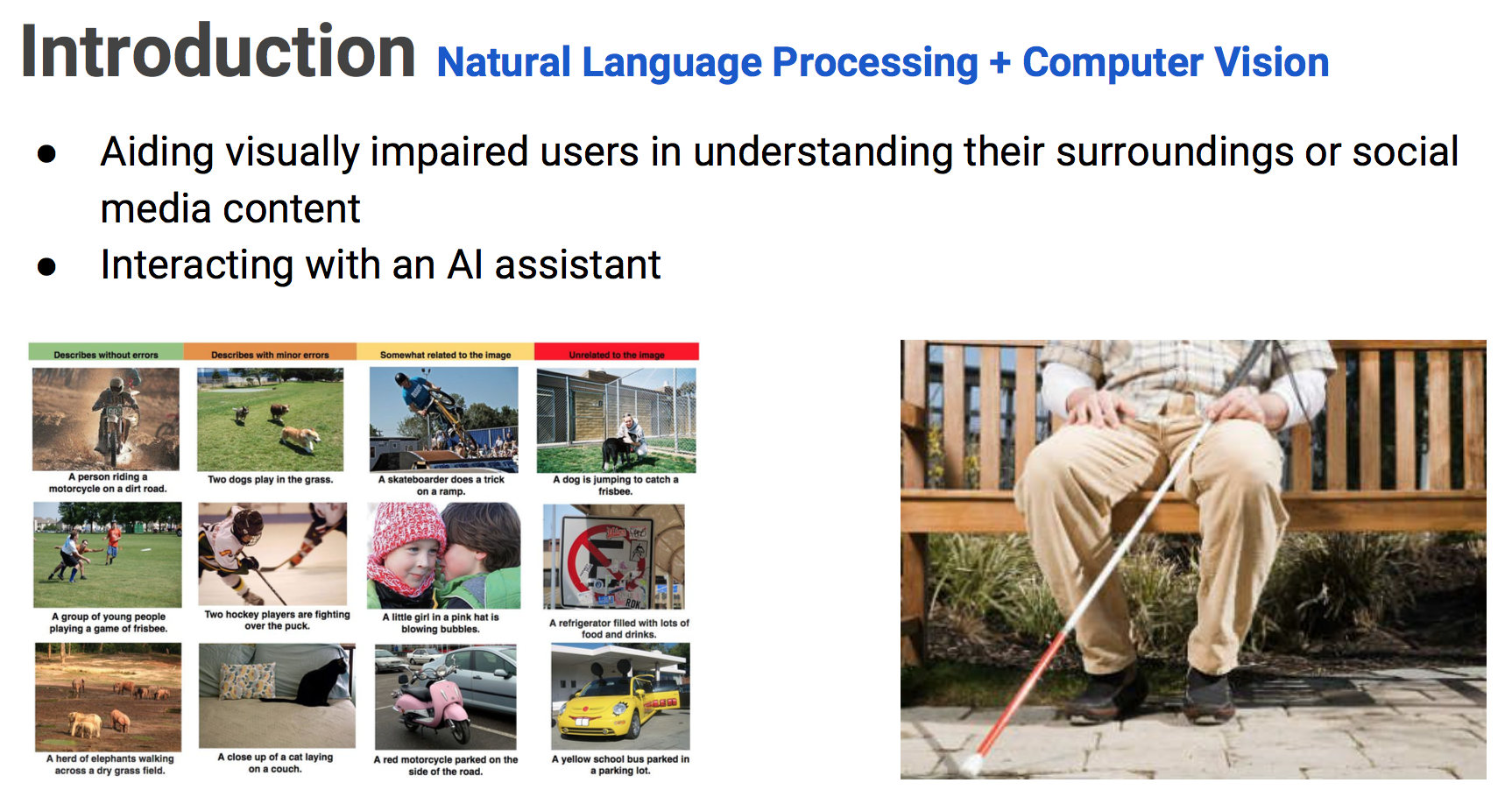

术语Visual Dialog,大致这么翻译(通俗理解为斗图)。你可以给聊天机器人发送图片,它能理解图片的意思,你们可以就图片内容展开对话;除了文本之外,让图片也成为交流的一部分;这可以帮助盲人理解周围或社交媒体上的信息。 这是自然语言处理...

这是LaTex答案,Python代码开源在GitHub上。先进行大量的SG、CBOW、负采样、交叉熵损失函数推导和证明,理论基础扎实后平滑过渡到实现;在斯坦福情感树库上做情感分析、调参、分析混淆矩阵与错误。 以前看不懂公式,总觉得代码是最重...

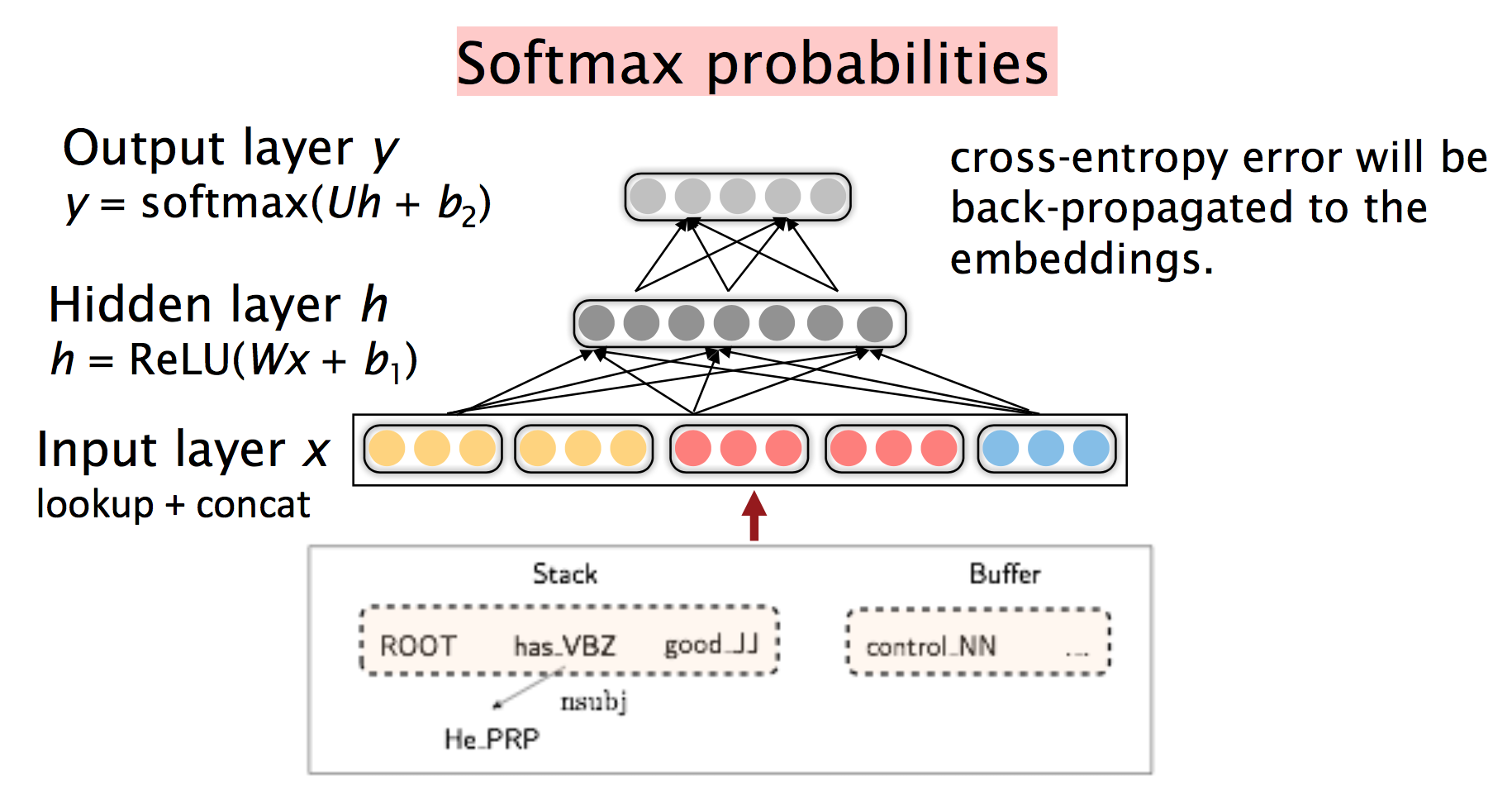

句法分析还算熟悉,就跟着复习了神经网络句法分析的动机与手法,了解一下比较前沿的动向。 语言学的两种观点 如何描述语法,有两种主流观点,其中一种是短语结构文法,英文术语是:Constituency = phrase structure gra...

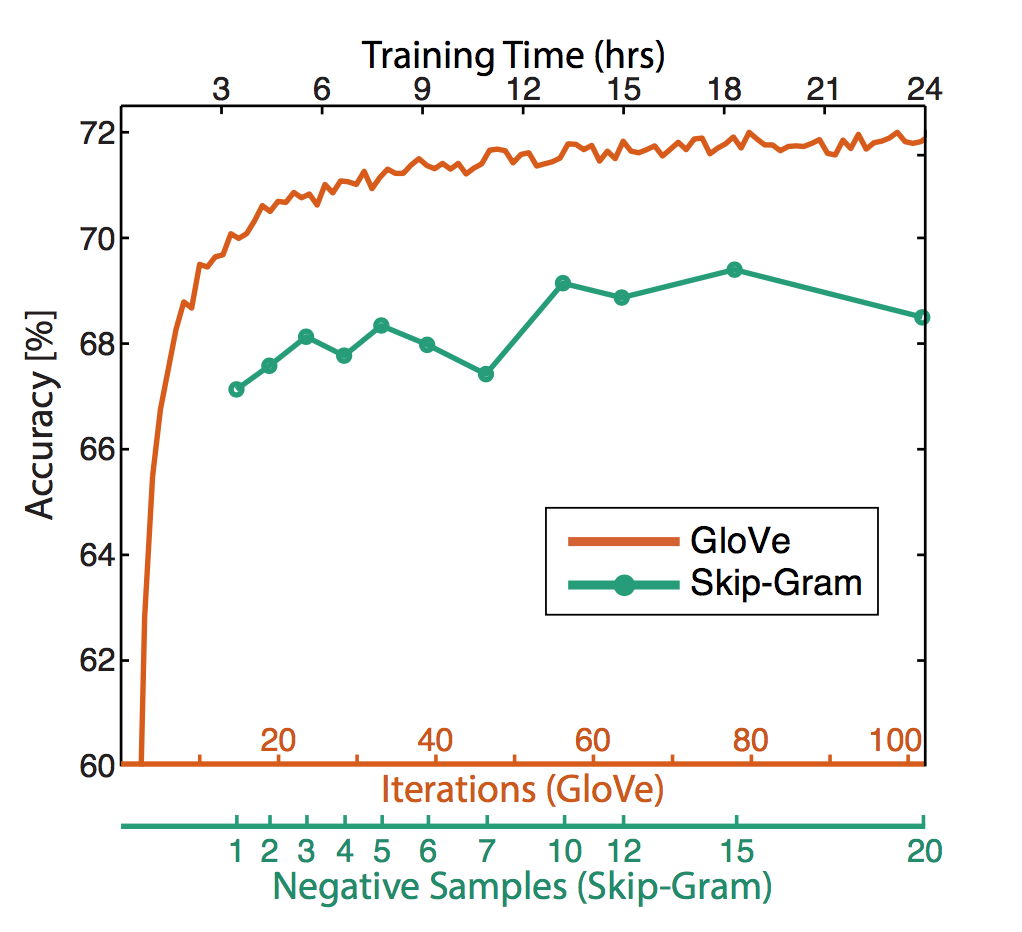

主讲人是一位发音特别纯正的印度小哥,只有微量口音。这篇论文挑战了对神经网络的迷信,展示了传统模型的生命力以及调参的重要性。 词语表示方法 以前的课程中讲过两大类得到dense词语表示的方法,一般认为NN模型更好: 这里的PPMI也是一种利用...

在Mac等*nix下编译Windows动态链接库或可执行文件,常见方法是虚拟机。然而虚拟机操作不流畅,来回拷贝源码不方便。虽然虚拟机自动将宿主目录挂载为磁盘分区,但cmd实际无法cd进去: 更好的方法是直接利用Wine容器中的编译链,一边开...

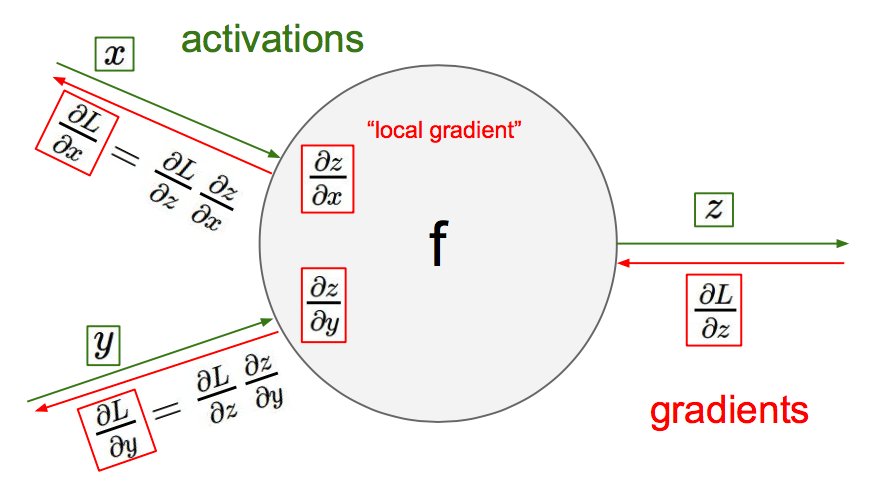

最后一次数学课,其实都是些很基础的推导而已。从四个不同的层面讲解反向传播,其中电路和有向图类比还是很直观新颖的解释。 任意层的通用公式 第$l$层的残差: $$\delta^{(l)} = (W^{(l)T} \delta^{(l+1)})...

Facebook的fastText 文本分类是NLP中常见的任务,比如情感分析: 词袋模型 虽然词袋模型只是所有词向量的某种平均,但其维度可以做到很低: 为了抵抗词序丢失带来的语义丢失问题,可以用ngram特征来代替。 简单的线...

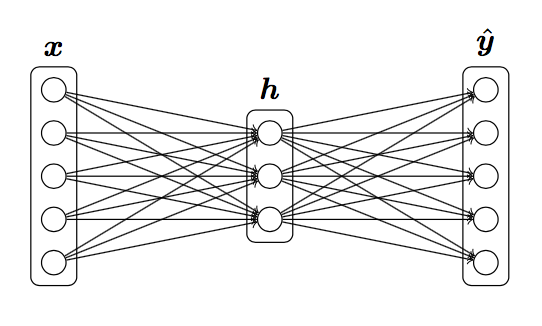

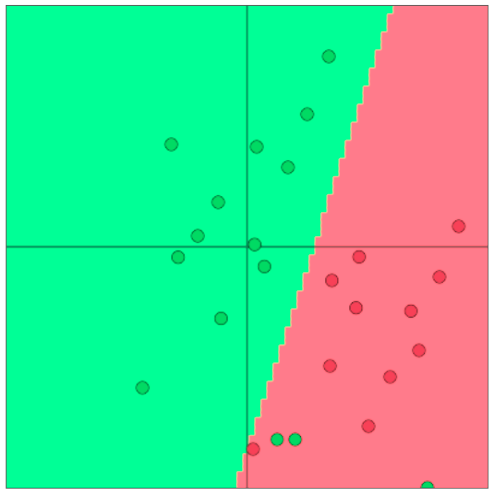

这节课介绍了根据上下文预测单词分类的问题,与常见神经网络课程套路不同,以间隔最大化为目标函数,推导了对权值矩阵和词向量的梯度;初步展示了与传统机器学习方法不一样的风格。 分类问题 给定训练集$$\{x^{(i)},y^{(i)}\}_1^N...

这节课从传统的基于计数的全局方法出发,过渡到结合两者优势的GloVe,并介绍了词向量的调参与评测方法。 复习:word2vec的主要思路 遍历整个语料库中的每个词 预测每个词的上下文: 然后在每个窗口中计算梯度做SGD SGD与词向量 但每...