简单有效的位置编码

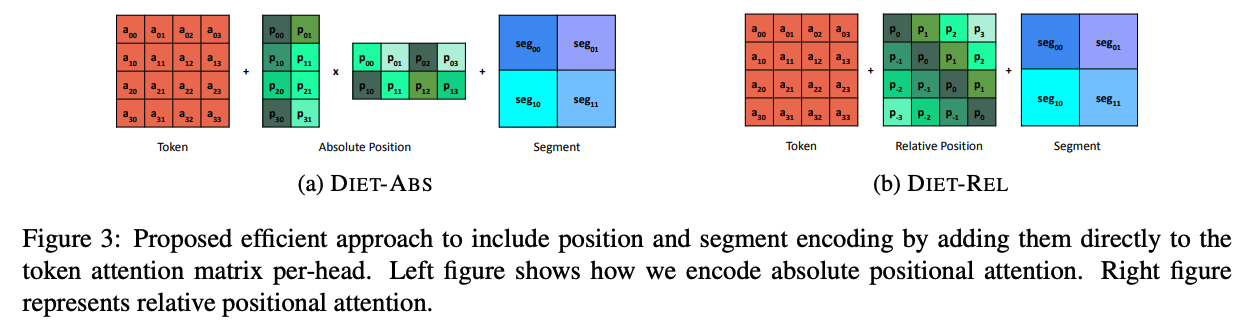

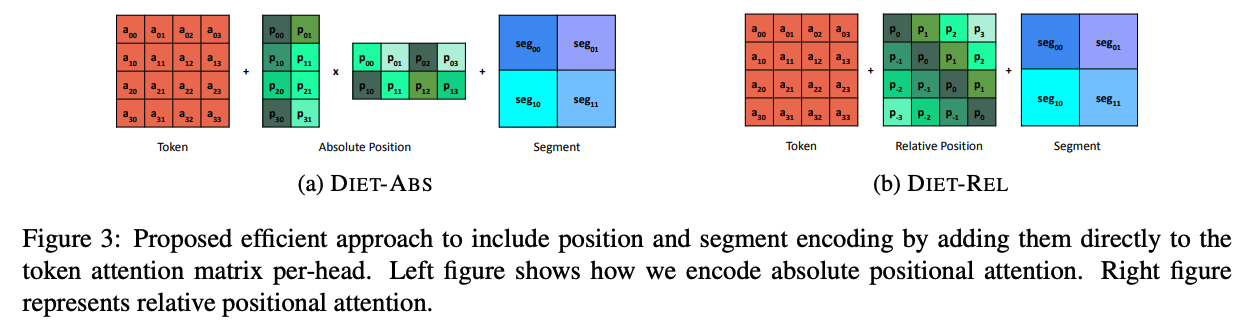

去年流行了一阵相对位置编码,各种巧夺天工的设计层出不穷,各有各的数学解释。然而谷歌这篇文章指出,相对位置并不优于绝对位置。之所以看上去更优是因为位置信息被加到了每一层注意力矩阵上,增大了矩阵的秩。其实我当时看这些论文的时候就很疑惑,这些论文...

去年流行了一阵相对位置编码,各种巧夺天工的设计层出不穷,各有各的数学解释。然而谷歌这篇文章指出,相对位置并不优于绝对位置。之所以看上去更优是因为位置信息被加到了每一层注意力矩阵上,增大了矩阵的秩。其实我当时看这些论文的时候就很疑惑,这些论文...

理一理基础优化理论,解释一下深度学习中的一阶梯度下降遇到的病态曲率(pathological curvature)问题。当海森矩阵condition number很大时,一阶梯度下降收敛很慢,无论是对鞍点还是局部极值点而言都不是个好事。 鞍...

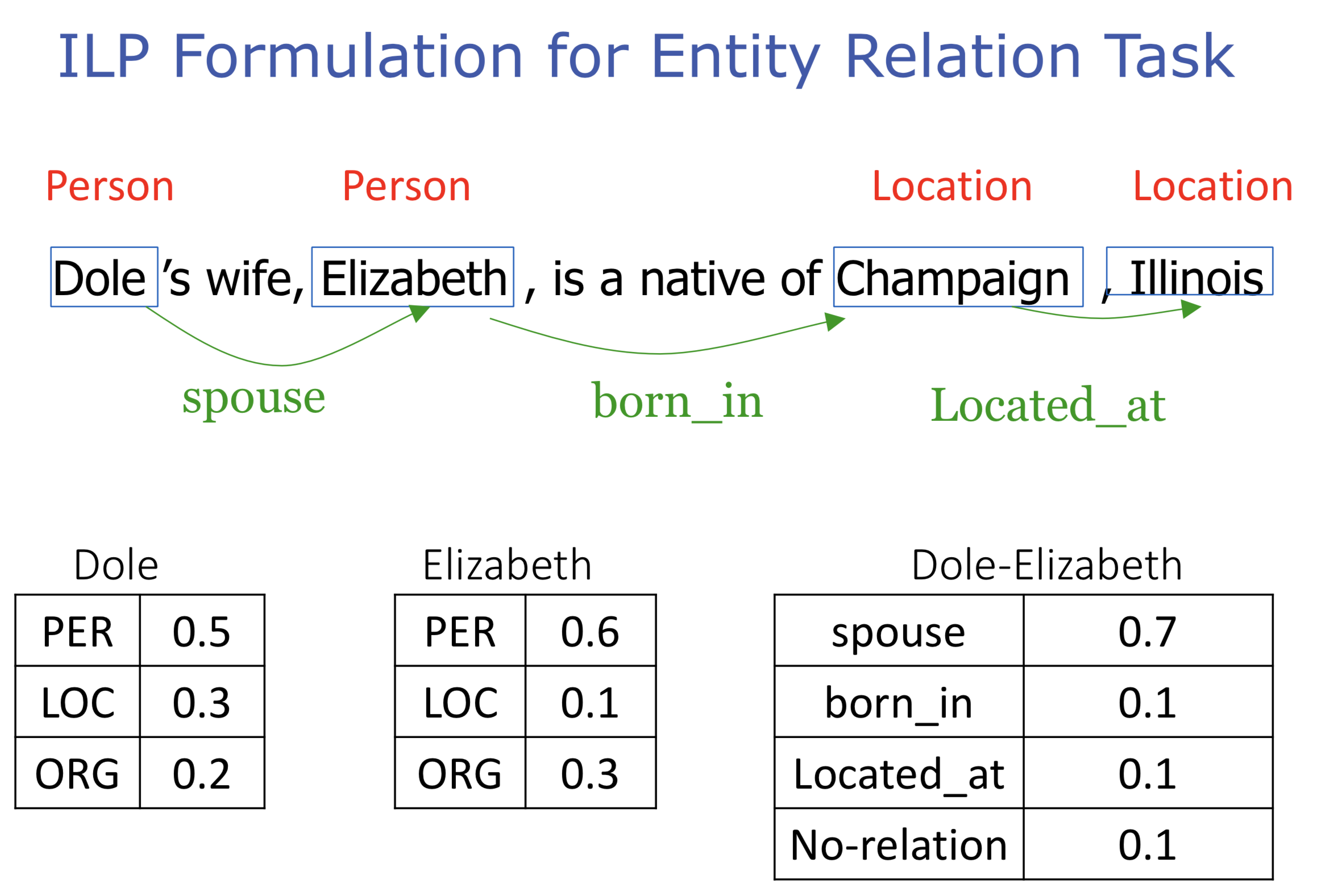

Chang et al. 2015提出加速结构化学习的近似算法AI-DCD,通过缓存整数线性规划中相似的问题及解,减少对ILP solver的调用次数,从而加速训练,同时不损失精度。 平摊推断 记$\mathbf{y}=\{y_1,y_2,...

普通安装方法是pip官方的包,但这种大街货往往没有针对本地环境做优化。比如调用时会警告说你的机器支持一些可加速运算的指令,但编译时没有启用,让你心痒难耐。 2017-06-26 10:34:11.820609: W&nb...

Neural Networks for Machine Learning最后一课。 学习图像和标题的联合模型 这节课介绍最近一种利用图片标题和图片像素的特征向量训练联合模型的技术。这两种输入之间应当有联系,并将辅助图片检索。末尾展示一段输入...

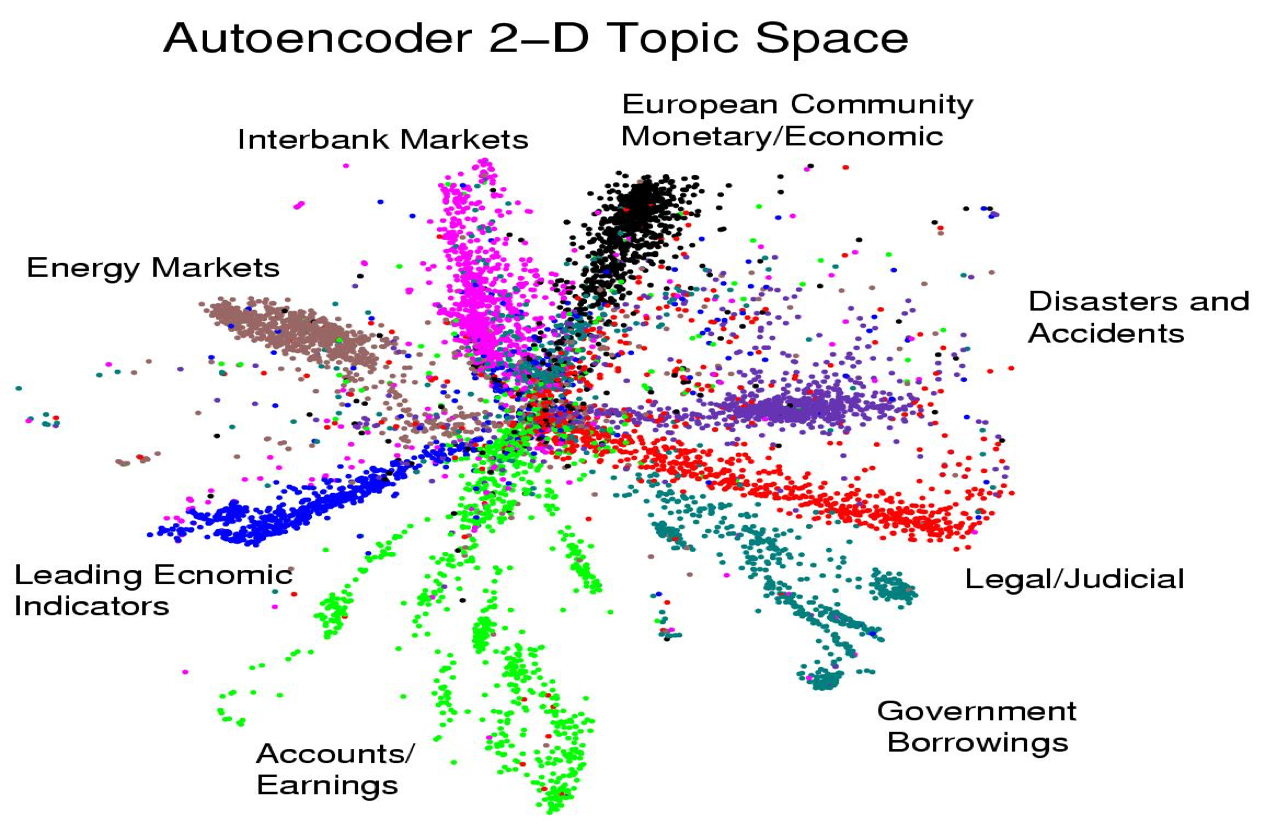

虽然是倒数第二课,但只要前面的认真听了,这节课就会觉得相当简单。 从主成分分析到自动编码器 先复习一下PCA,这是一种找出高维数据附近的linear manifold,用这上面的映射来表示数据本身的方法。linear manifold定义如...

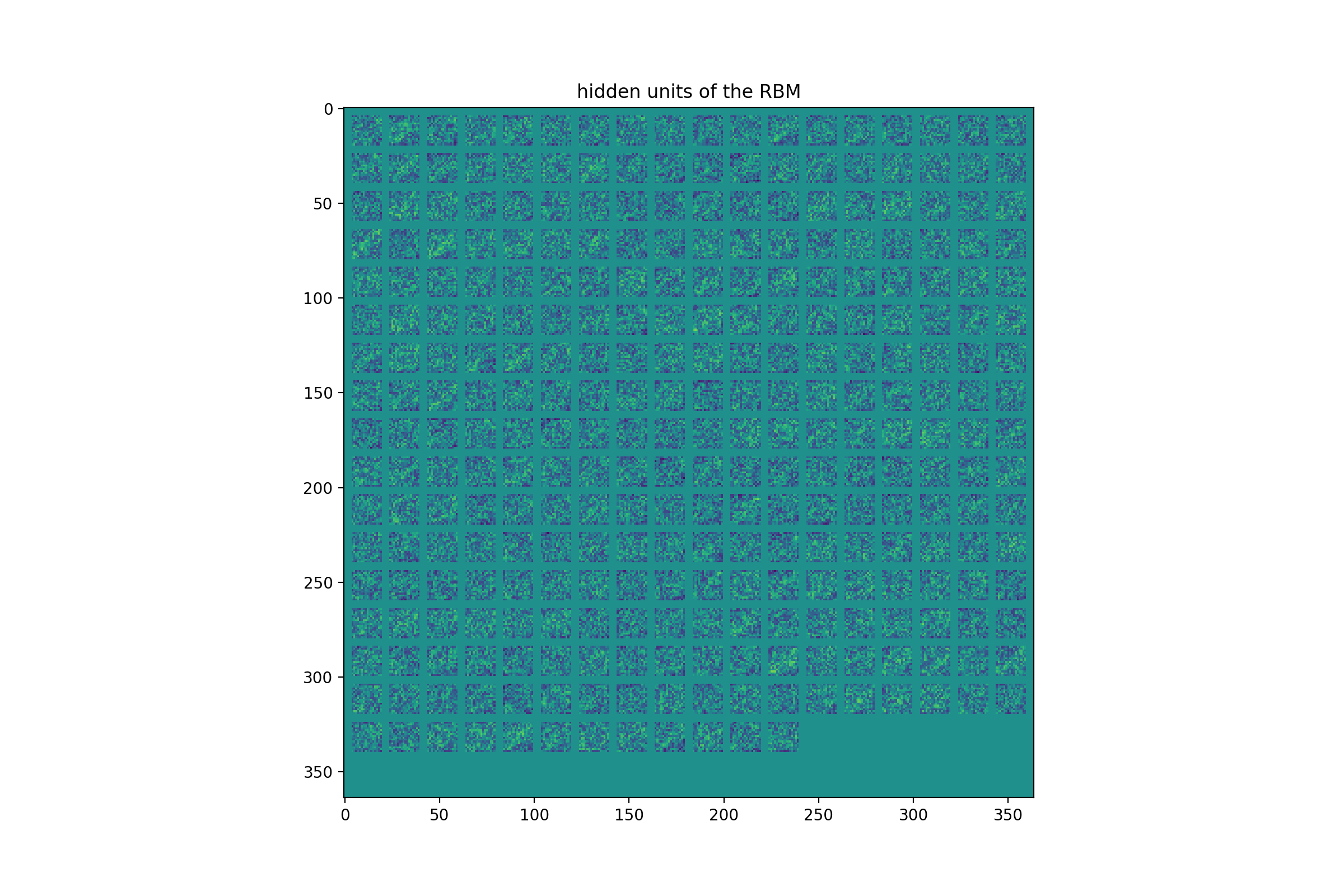

最后一次练习先实现RBM的CD1训练,然后将其作为前馈网络预训练的最底层用于识别USPS手写数字。所有代码开源在:https://github.com/hankcs/coursera-neural-net 。 编程之前 有些约定需...

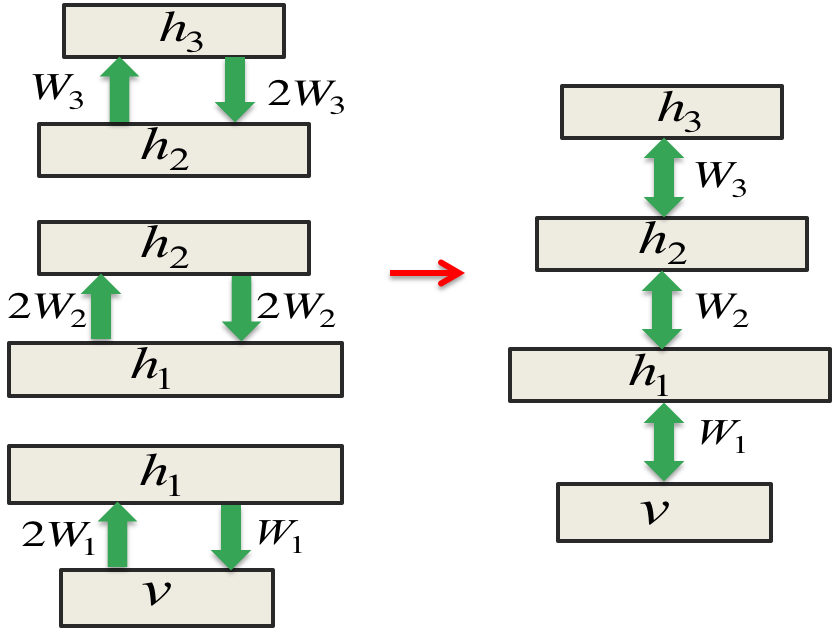

这节课介绍另一种训练sigmoid belief net的方法,这种方法的发明可谓无心插柳。Hinton放弃了sigmoid belief net之后又回到了玻尔兹曼机的研究,发现RBM的训练很高效。RBM可以学习一层非线性的特征,如果层叠...

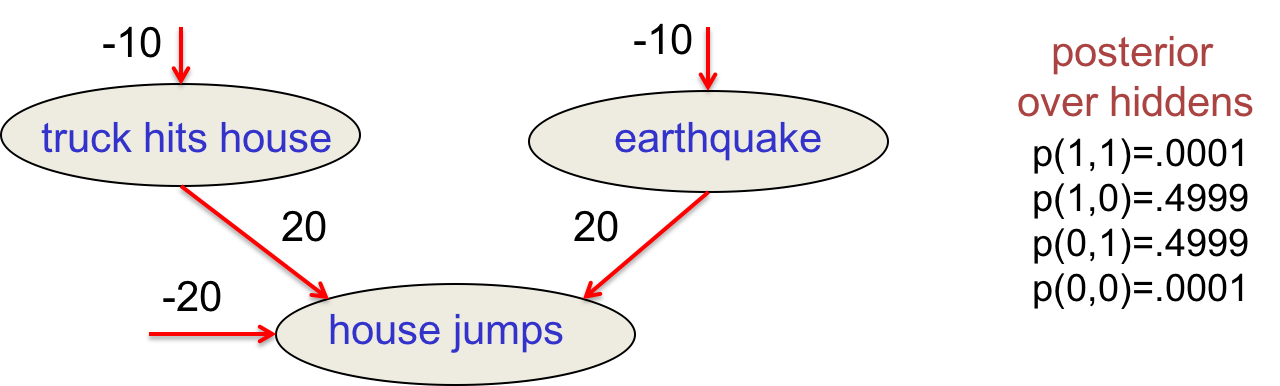

这次课比较轻松,先回顾反向传播的历史,探讨其在90年代遭到冷落的原因。然后过渡到概率图模型,讲了Deep Belief Net及其与RBM的异同、训练算法等。 反向传播简史 这个著名的算法在70和80年代被重复发明多次: Bryson &a...

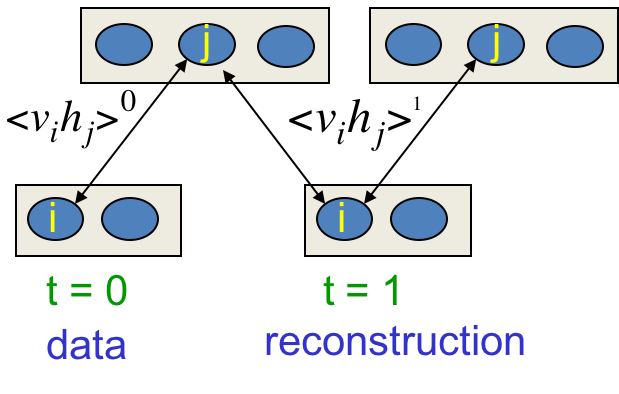

终于到了玻尔兹曼机的训练了,这种简单的模型拥有优雅的理论基础,训练起来却又慢又差,曾一度被认为不实用。这节课讲解几种高效的学习算法,以及RBM应用到协同过滤的例子。 学习目标 这是种无监督学习,只有输入向量的参与。我们想要最大化训练集中的二...