Hinton神经网络公开课16 Recent applications of deep neural nets

Neural Networks for Machine Learning最后一课。 学习图像和标题的联合模型 这节课介绍最近一种利用图片标题和图片像素的特征向量训练联合模型的技术。这两种输入之间应当有联系,并将辅助图片检索。末尾展示一段输入...

Neural Networks for Machine Learning最后一课。 学习图像和标题的联合模型 这节课介绍最近一种利用图片标题和图片像素的特征向量训练联合模型的技术。这两种输入之间应当有联系,并将辅助图片检索。末尾展示一段输入...

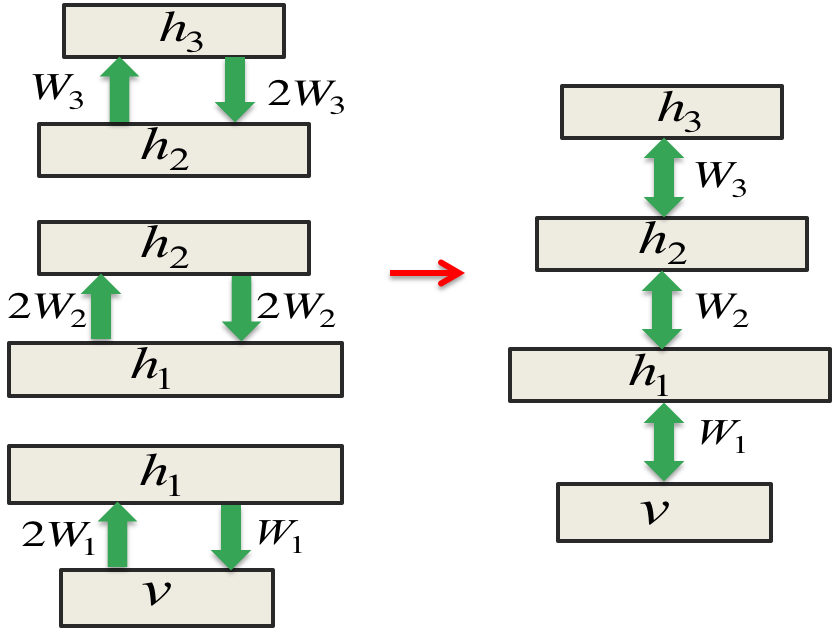

虽然是倒数第二课,但只要前面的认真听了,这节课就会觉得相当简单。 从主成分分析到自动编码器 先复习一下PCA,这是一种找出高维数据附近的linear manifold,用这上面的映射来表示数据本身的方法。linear manifold定义如...

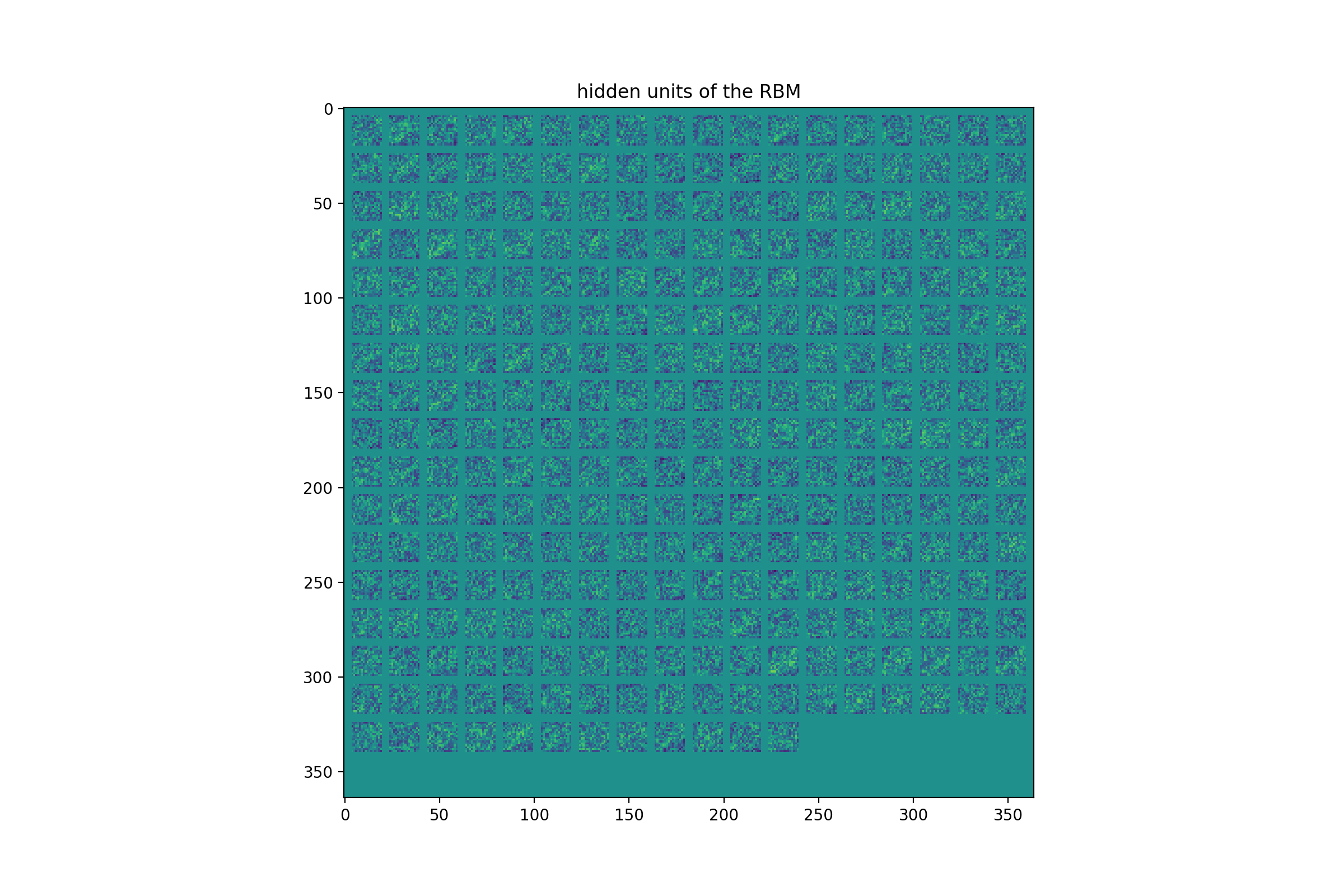

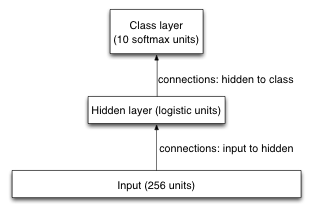

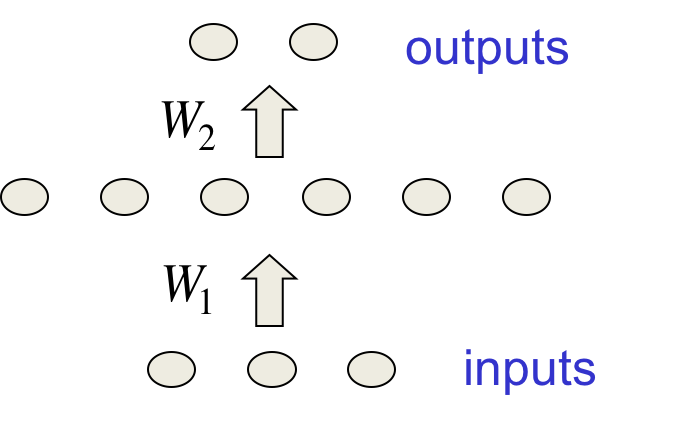

最后一次练习先实现RBM的CD1训练,然后将其作为前馈网络预训练的最底层用于识别USPS手写数字。所有代码开源在:https://github.com/hankcs/coursera-neural-net 。 编程之前 有些约定需...

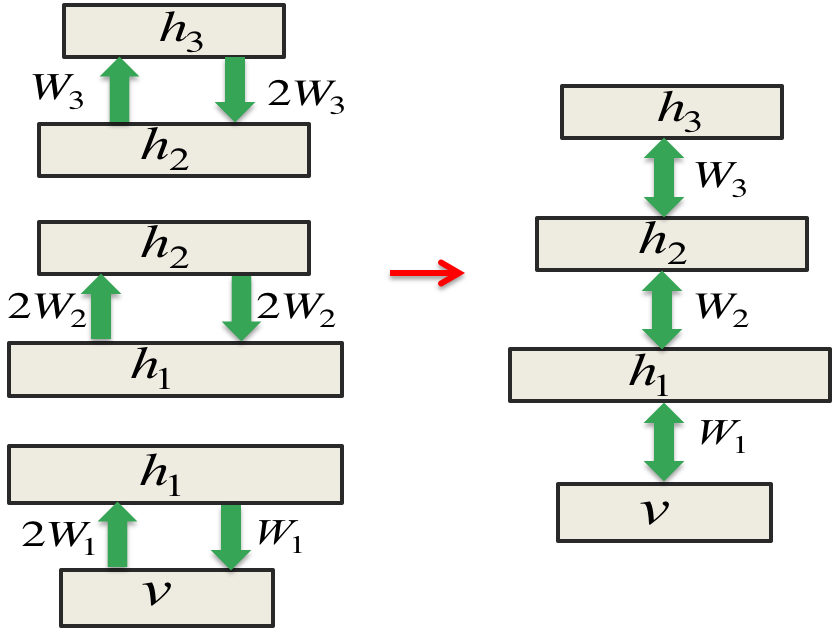

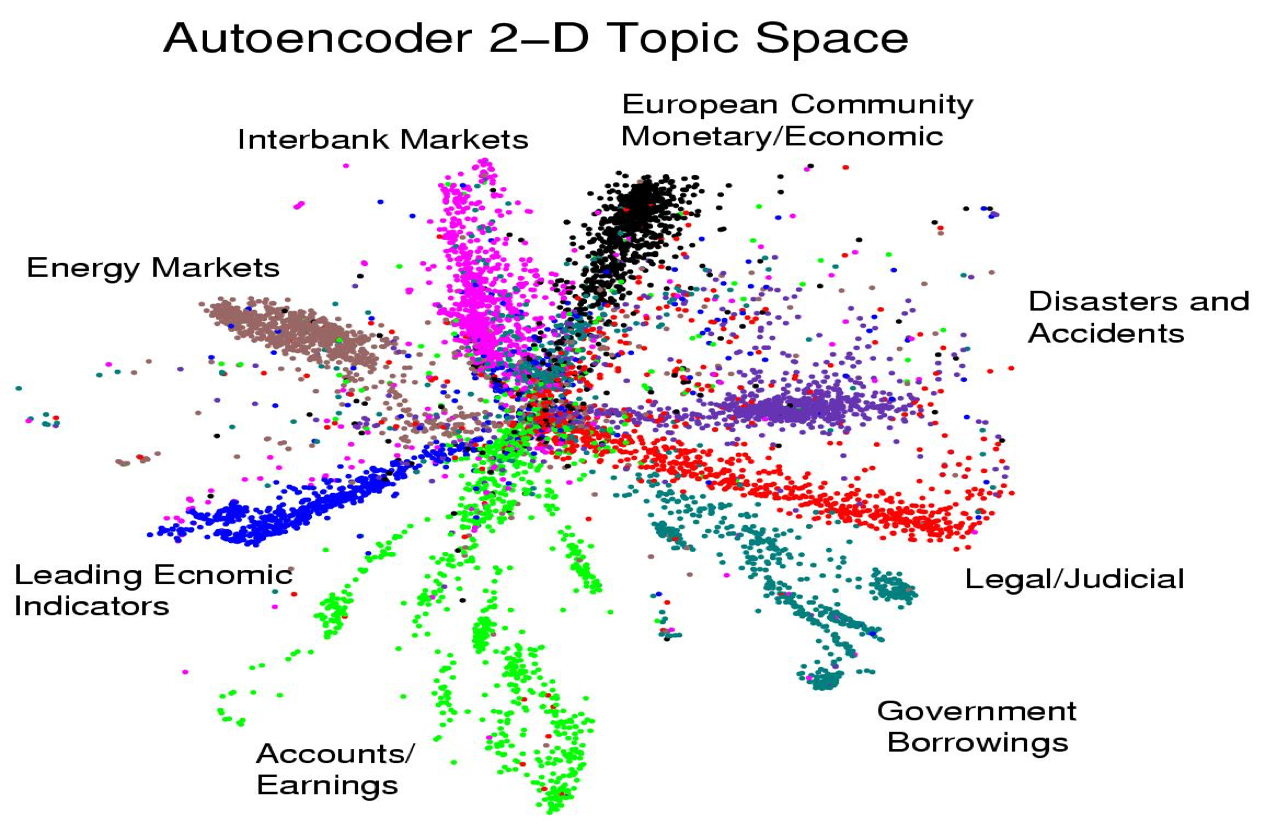

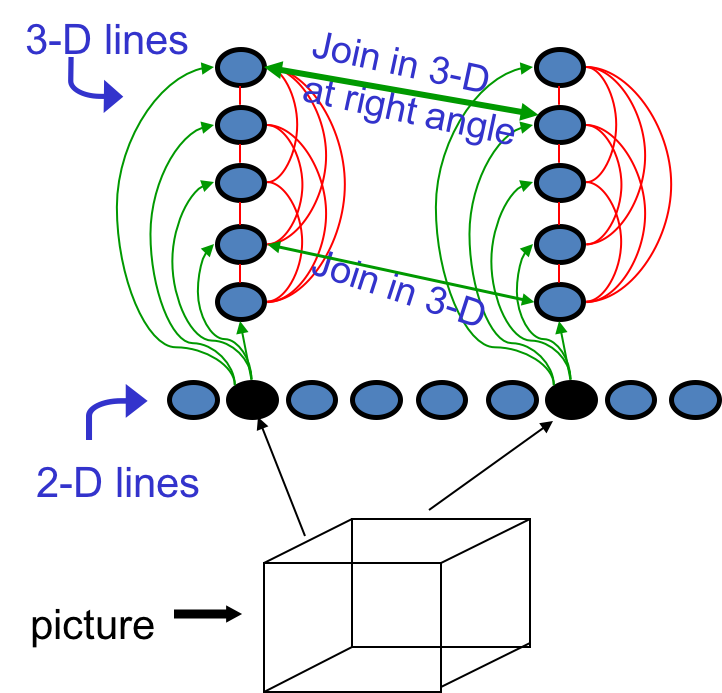

这节课介绍另一种训练sigmoid belief net的方法,这种方法的发明可谓无心插柳。Hinton放弃了sigmoid belief net之后又回到了玻尔兹曼机的研究,发现RBM的训练很高效。RBM可以学习一层非线性的特征,如果层叠...

这次课比较轻松,先回顾反向传播的历史,探讨其在90年代遭到冷落的原因。然后过渡到概率图模型,讲了Deep Belief Net及其与RBM的异同、训练算法等。 反向传播简史 这个著名的算法在70和80年代被重复发明多次: Bryson &a...

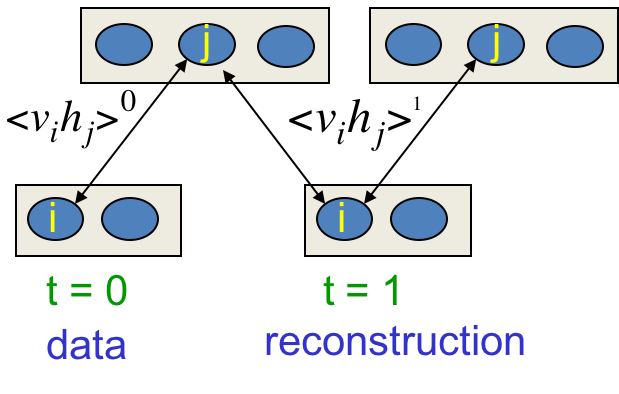

终于到了玻尔兹曼机的训练了,这种简单的模型拥有优雅的理论基础,训练起来却又慢又差,曾一度被认为不实用。这节课讲解几种高效的学习算法,以及RBM应用到协同过滤的例子。 学习目标 这是种无监督学习,只有输入向量的参与。我们想要最大化训练集中的二...

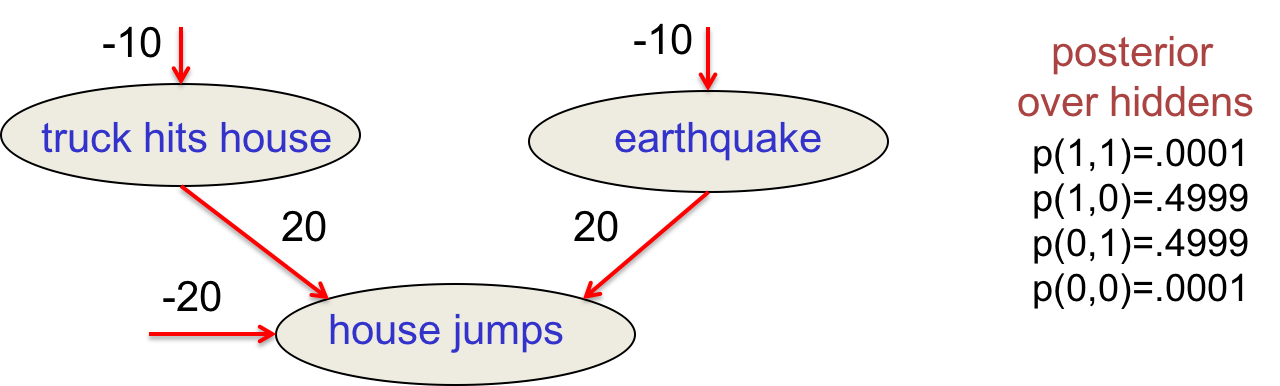

这节课介绍Hopfield Nets,这是80年代神经网络复兴的主要原因之一。这种简单优美的模型将记忆储存为激活值中的模式。然后介绍带有随机隐藏单元的Stochastic Hopfield nets(即玻尔兹曼机),及其搜索算法,为下节课的...

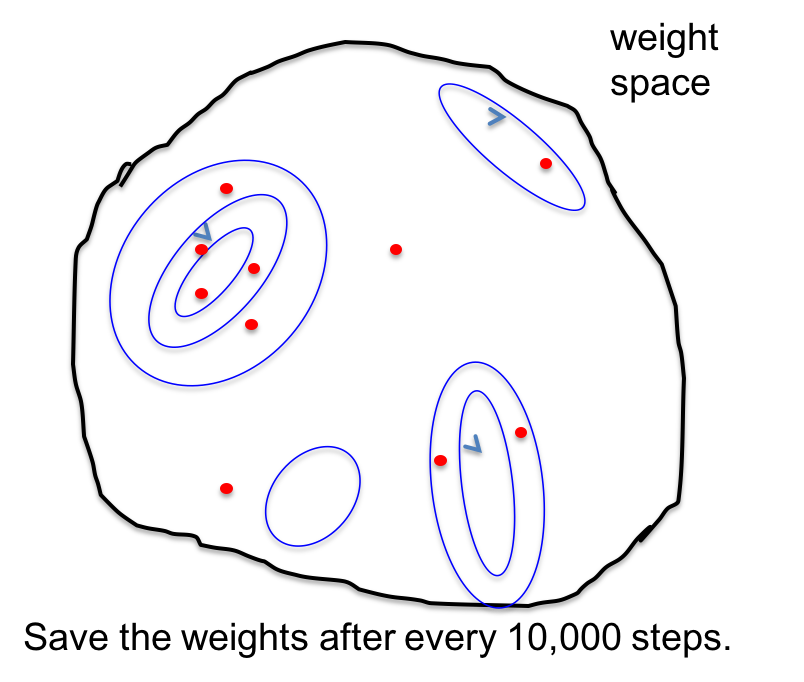

这节课讲了为什么要综合多个模型,好处与原理、具体做法等。讲解了贝叶斯学习中的神经网络模型混合、马尔科夫蒙特卡洛方法,以及从新角度阐释更高效的Dropout。 综合网络:偏置方差均衡 训练数据少,容易过拟合。综合多个模型可以防止过拟合,特别是...

这次练习在USPS手写邮政编码数据集上训练识别模型,重点是训练神经网络时的各种调参技巧。 数据集 数据全集有11000张图片,其中1000作为训练集,1000作为验证集,9000作为测试集(训练集与测试集的比例不同寻常,很容易过拟合,富有挑...

这节课介绍防止模型过拟合的各种方法,给出了正则化项、惩罚因子的贝叶斯解读;并展示了基于贝叶斯解读的一种实践有效的惩罚因子调参方法。 复习:过拟合 训练数据中不光有正确的规律,而且还有偶然的规律(采样误差,只取决于训练实例的选择)。拟合模型的...