CS224n Assignment 3

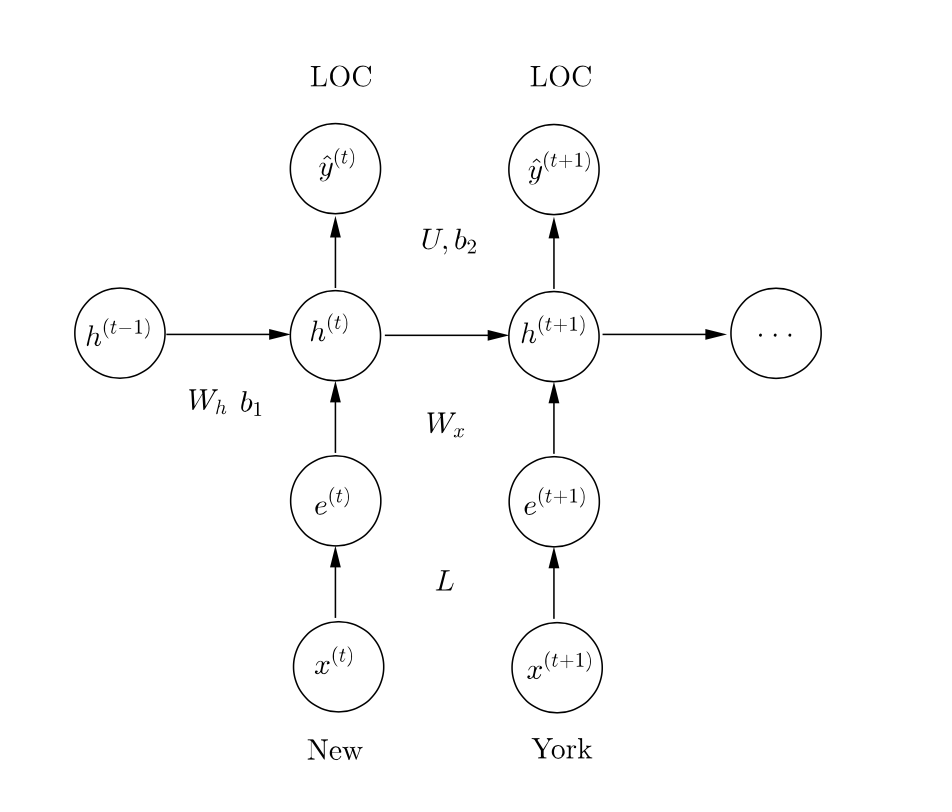

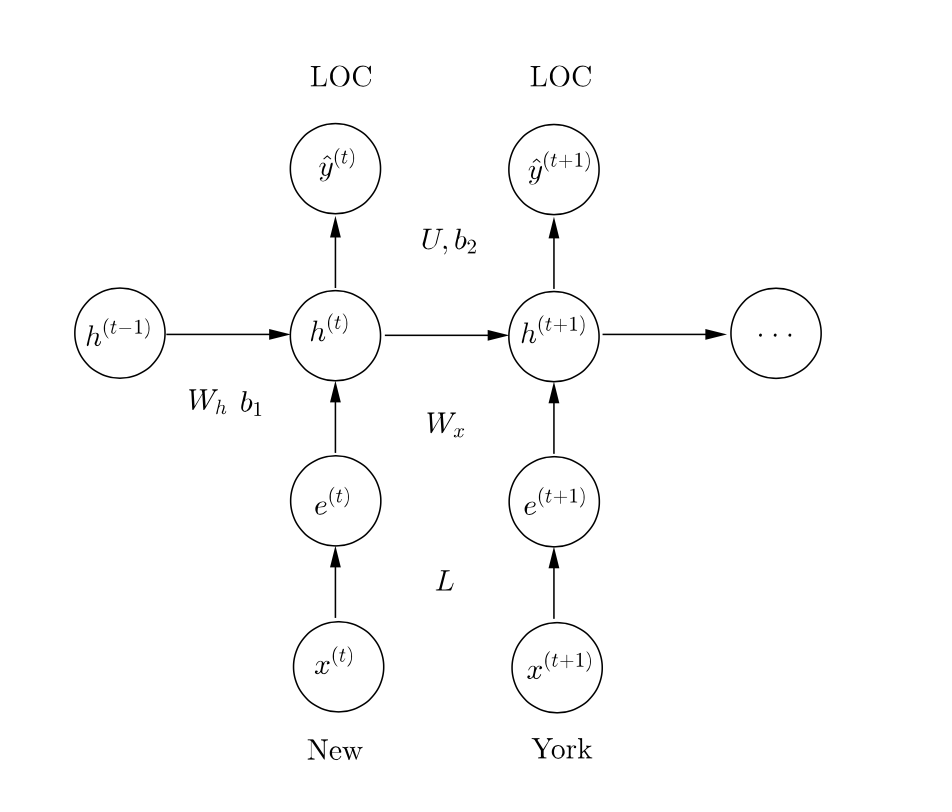

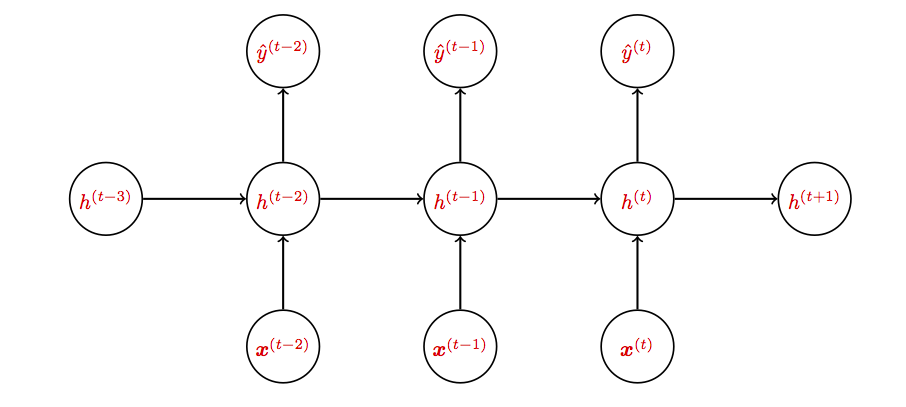

命名实体识别任务,先实现基于窗口的基线模型,然后进阶到RNN和GRU。中间利用对自动机的模拟和推导展示RNN的缺点,演示梯度剪裁的作用。这是Latex解答,代码已提交,最后还有一个彩蛋。 命名实体识别初步 定位命名实体并将其分类到: 人名P...

命名实体识别任务,先实现基于窗口的基线模型,然后进阶到RNN和GRU。中间利用对自动机的模拟和推导展示RNN的缺点,演示梯度剪裁的作用。这是Latex解答,代码已提交,最后还有一个彩蛋。 命名实体识别初步 定位命名实体并将其分类到: 人名P...

先在TensorFlow上实现多项逻辑斯谛回归练练手,然后增加难度实现基于神经网络的转移依存句法分析,试验Xavier初始化、Dropout和Adam优化器。最后推导RNN和语言模型的困惑度、梯度、反向传播和复杂度。 Python代码开源在...

普通安装方法是pip官方的包,但这种大街货往往没有针对本地环境做优化。比如调用时会警告说你的机器支持一些可加速运算的指令,但编译时没有启用,让你心痒难耐。 2017-06-26 10:34:11.820609: W&nb...

这节课由TA们介绍了TF里的几个基本概念(graph、variable、placeholder、session、fetch、feed),基本流程。然后现场敲代码演示如何在TF上跑线性回归和训练词向量。与优达学城的《深度学习公开课》不同之处在...

课上讲的太简略了,原理参考《word2vec原理推导与代码分析》。谷歌给的代码也很简陋,只有负采样,没有哈夫曼树。另外单机word2vec已经那么高效了,我质疑上TF的意义。 任务 5: Word2Vec&CBOW 这次的任务是在t...

课上浅显地介绍了卷积网络,以及配套的常用技巧。速成嘛,没深入探讨原理。编程任务直接给出了实现,要求也只是在其基础上做些小改进,过过干瘾。 任务 4: 卷积模型 设计并训练一个卷积神经网络。 前两次任务中,我们实现了较深的全连接多层神经网络,...

这次的看点是怎么在TensorFlow里实现正则化、dropout和学习率递减的技巧;顺便演示了下自动调参。 任务 3: 正则化 使用正则化去优化深度学习模型 题目1 给上次练习实现的逻辑斯谛回归和神经网络加上L2正则,检查性能提升。 逻辑...

三言两语讲完了反向传播,一个公式也没有,果然是面向“懒惰工程师”的快餐教程。比较喜欢“不提神经元,我们不是巫婆”的观点。这次不需要自己写算法,直接上TensorFlow了。 任务 2: 随机梯度下降 使用梯度下降和随机梯度下降训练一个全连接...

这是谷歌在优达学城上开的公开课,感觉就是TensorFlow的宣传片。肉眼观测难度较低,作为入门第一课快速过掉也许还行。课程概述中说: 我们将教授你如何训练和优化基本神经网络、卷积神经网络和长短期记忆网络。你将通过项目和任务接触完整的机器学...