HanLP古汉语处理模型发布

在陆续支持了简繁中英日俄法德在内的130种语言后,HanLP今日正式发布开源古汉语模型,以支持古汉语文言文自动分词、词形、词性标注和依存句法分析。得益于多任务学习技术,只需一个模型就可以支持这些任务,以及粗分/细分、UPOS/XPOS/PK...

在陆续支持了简繁中英日俄法德在内的130种语言后,HanLP今日正式发布开源古汉语模型,以支持古汉语文言文自动分词、词形、词性标注和依存句法分析。得益于多任务学习技术,只需一个模型就可以支持这些任务,以及粗分/细分、UPOS/XPOS/PK...

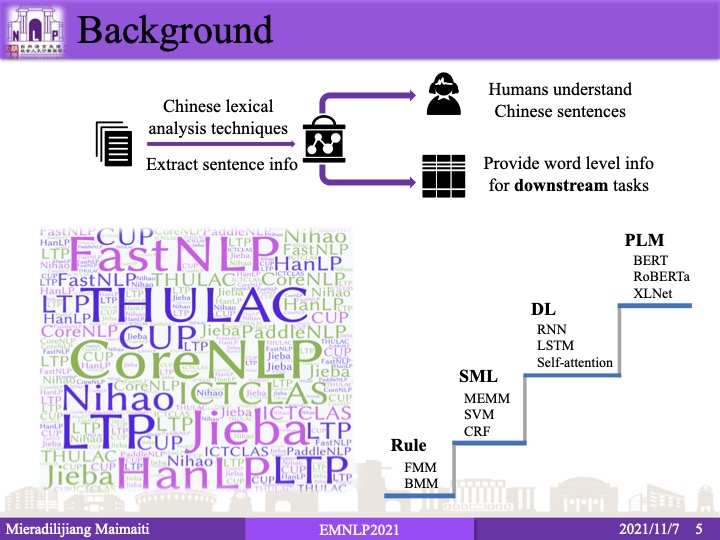

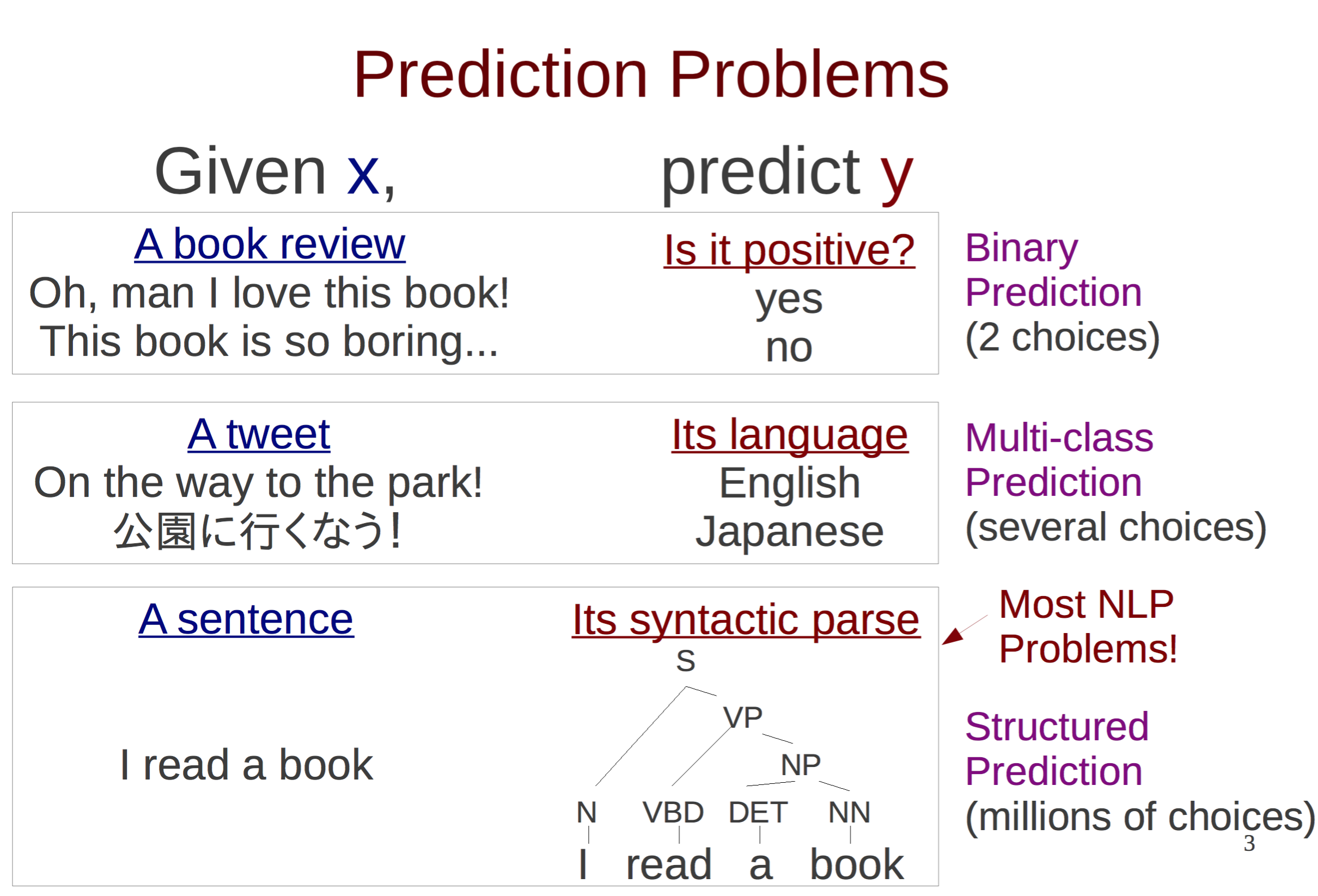

很久没有关注中文分词,今年恰好开会听了这篇清华领衔的长论文,分数相当不错。而且还引用了我的第一篇论文,于是简要介绍一下。虽然仰慕已久,但我与论文作者们并无私交。本文仅代表我的个人观点,如果有任何理解或表述错误,都是我的责任,与原作者无关。图...

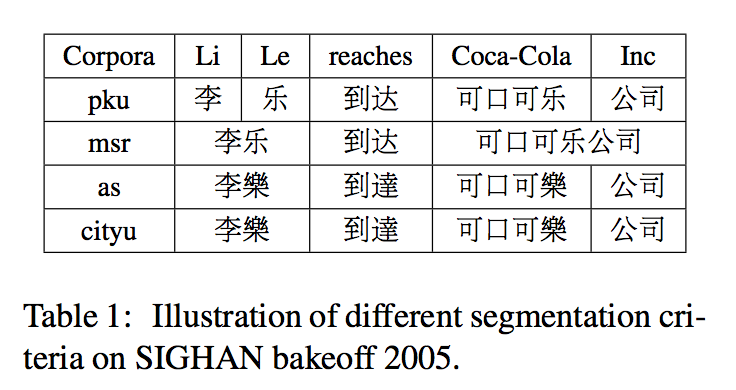

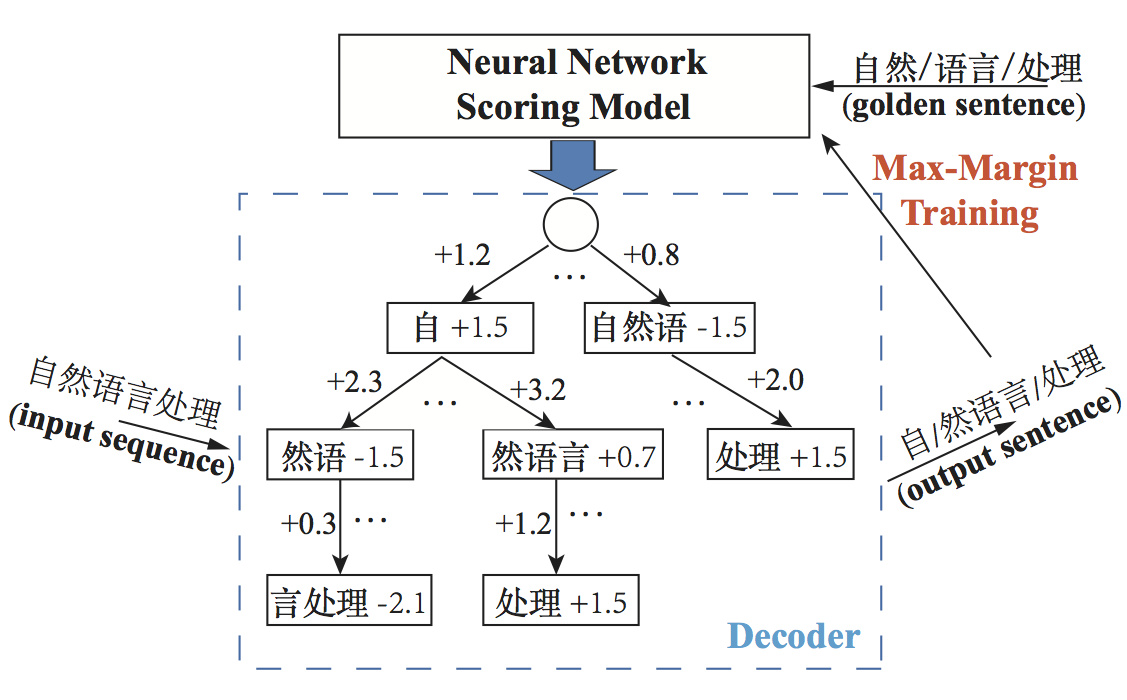

本文介绍一种简洁优雅的多标准中文分词方案,可联合多个不同标准的语料库训练单个模型,同时输出多标准的分词结果。通过不同语料库之间的迁移学习提升模型的性能,在10个语料库上的联合试验结果优于绝大部分单独训练的模型。模型参数和超参数全部共享,复杂...

随着深度学习的普及,有越来越多的研究应用新模型到中文分词上,让人直呼“手快有,手慢无”。不过这些神经网络方法的真实水平如何?具体数值多少?以Sighan05中的PKU数据集为例,真像一些论文所言,一个LSTM-CRF就有96.5%吗?或者像...

最近高产似母猪,写了个基于AP的中文分词器,在Bakeoff-05的MSR语料上F值有96.11%。最重要的是,只训练了5个迭代;包含语料加载等IO操作在内,整个训练一共才花费23秒。应用裁剪算法去掉模型中80%的特征后,F值才下降不到0....

以前发布过HanLP的Lucene插件,后来很多人跟我说其实Solr更流行(反正我是觉得既然Solr是Lucene的子项目,那么稍微改改配置就能支持Solr),于是就抽空做了个Solr插件出来,开源在Github上,欢迎改进。 HanLP中...

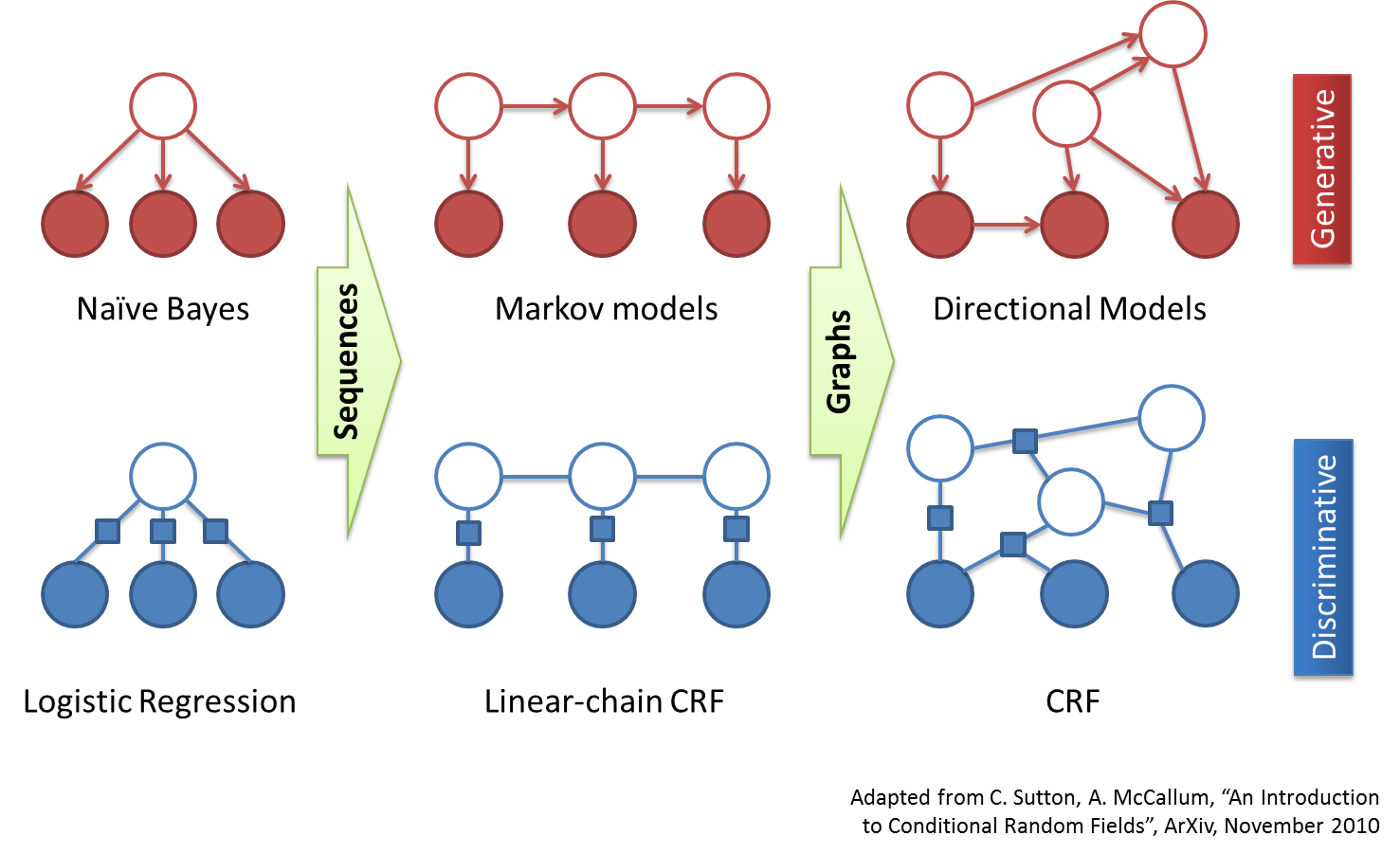

谈起基于Character-Based Generative Model的中文分词方法,普遍的印象是在Bakeoff上的成绩好,对OOV的识别率高。HanLP中实现的CRF分词器其实就是这种原理的分词器,然而CRF分词缺点也是很明显的: 一...

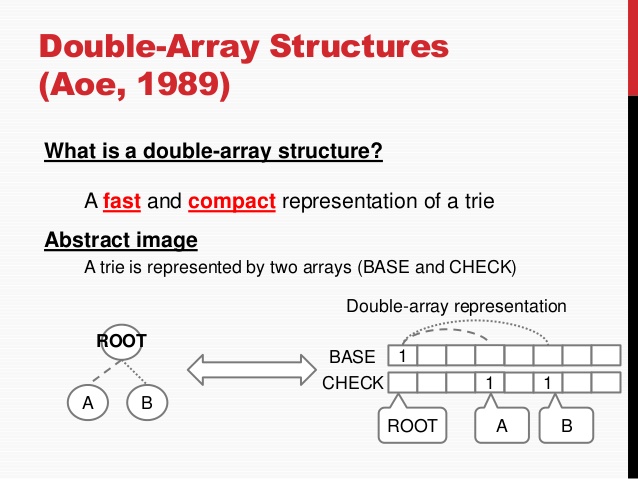

前段时间开源了基于双数组Trie树的Aho Corasick自动机,当时认为在中文分词中,ACDAT应该能秒杀DAT。今天优化了DAT的多模式匹配后,竟然得出了意外的结果。 当初的DAT实现中,为了支持多模式匹配,我写了一个Searcher...

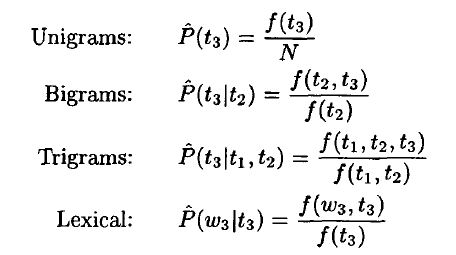

与基于隐马尔可夫模型的最短路径分词、N-最短路径分词相比,基于条件随机场(CRF)的分词对未登录词有更好的支持。本文(HanLP)使用纯Java实现CRF模型的读取与维特比后向解码,内部特征函数采用 双数组Trie树(Double...

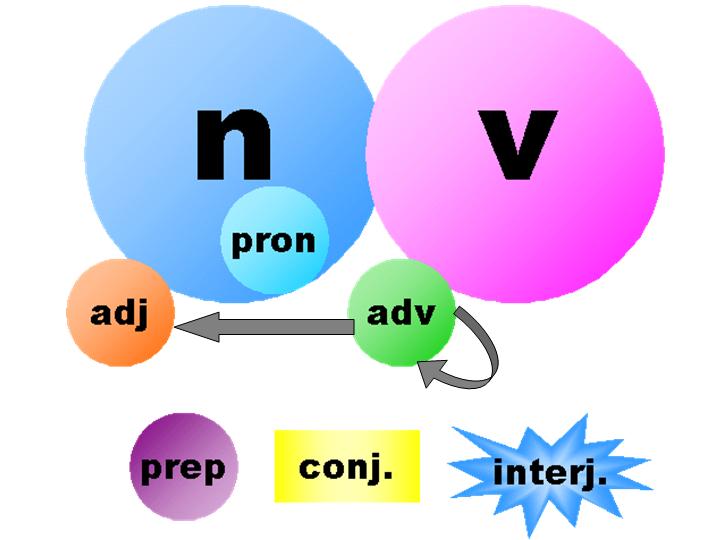

词性标注(Part-of-Speech tagging 或POS tagging),又称词类标注或者简称标注,是指为分词结果中的每个单词标注一个正确的词性的程序,也即确定每个词是名词、动词、形容词或其他词性的过程。在汉语中,词性标注比较简单...