中文抽象意义表示简介

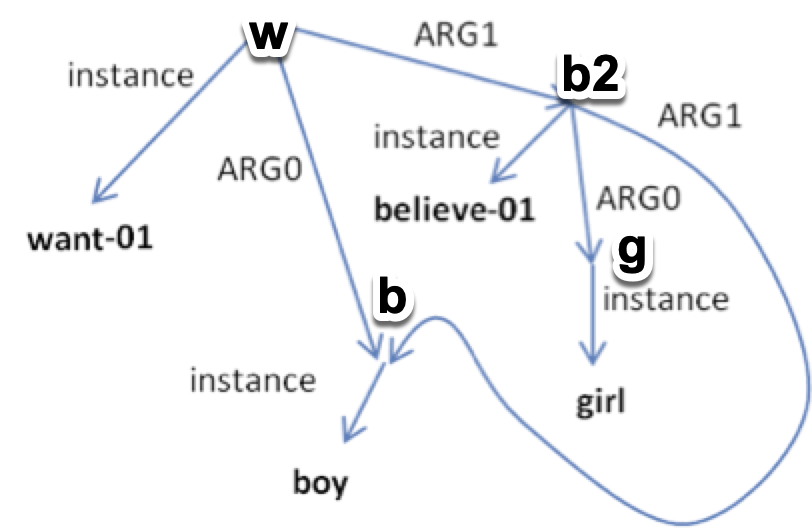

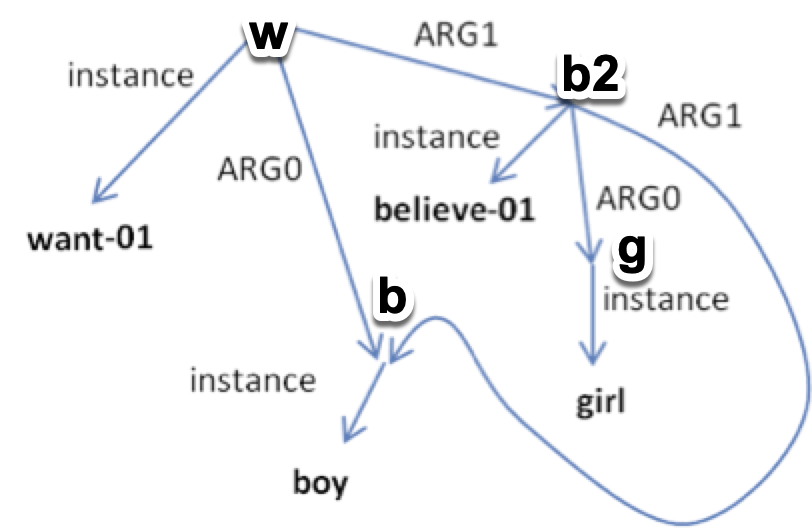

上周收到LDC的订阅邮件,由布兰迪斯大学和南京师范大学联合标注的中文抽象意义表示语料库2.0(CAMR 2.0)发布了。于是第一时间下单购买,做一期开箱评测。 抽象意义表示(Abstract Meaning Representation,A...

上周收到LDC的订阅邮件,由布兰迪斯大学和南京师范大学联合标注的中文抽象意义表示语料库2.0(CAMR 2.0)发布了。于是第一时间下单购买,做一期开箱评测。 抽象意义表示(Abstract Meaning Representation,A...

AAAI19的论文(Sap et al. (2019))开源了一个包含87万条推理常识的知识图谱ATOMIC。相较于常见的基于本体论分类条目的知识图谱,该知识库专注于“如果…那么…”关系的知识。作者提出了9种类型的因果联系来区分原因-效果、...

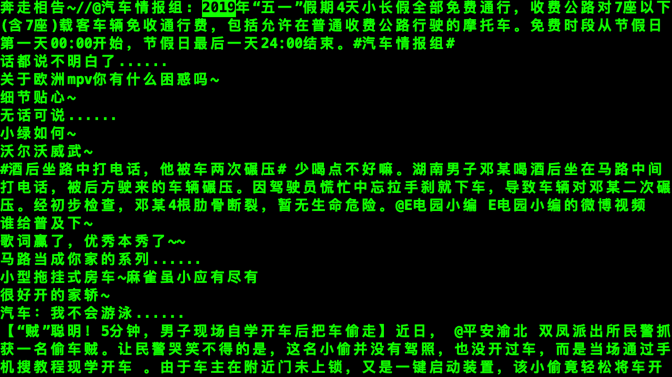

2019最新的微博语料,可用于预训练语言模型Weibo-BERT词向量等。由于比较时新,对网络流行语的建模可能很有帮助。每个压缩包都有两千多万条,一共5个。大家下载之后也算是有一个亿身家的人了,激动吧。感兴趣的同学要不要训练个Weibo-B...

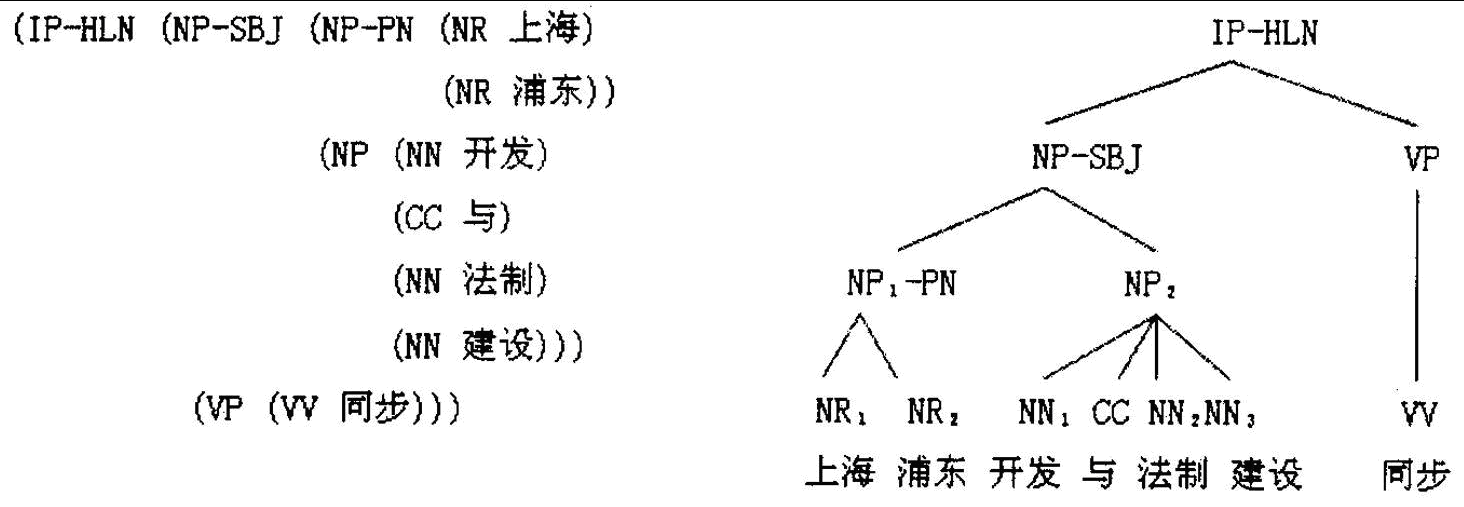

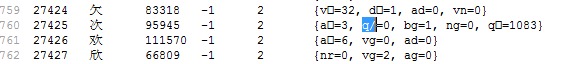

本文旨在介绍CoNLL格式的中文依存语料库(汉语依存树库)、CoNLL格式相关工具,以及提供两个公开的中文依存语料库下载。 最近做完了分词、词性标注、命名实体识别、关键词提取、自动摘要、拼音、简繁转换、文本推荐,感觉HanLP初具雏形。现在...

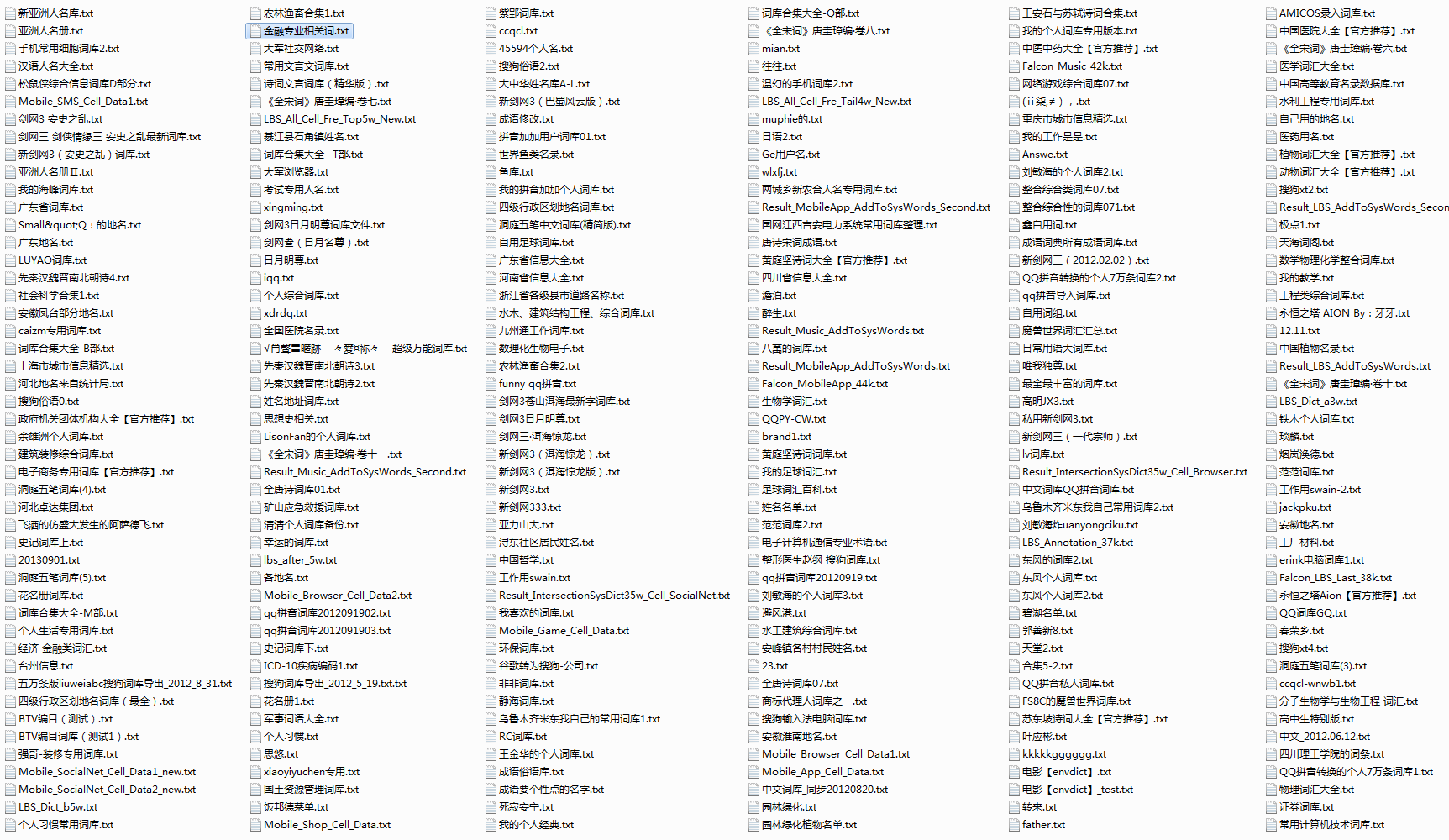

算法+语料≈NLP 这是一个六千万词汇量的分类词库,做HanLP这么久,我逐渐体会到,算法无法解决所有问题,词库也非常重要。通常一个算法可以解决80%的问题,剩下的20%无论怎么调节优化,都是拆东墙补西墙。比如上次我提到的“区人保”被HMM...

HanLP开源分词系统 支持中文分词(N-最短路分词、CRF分词、索引分词、用户自定义词典、词性标注),命名实体识别(中国人名、音译人名、日本人名、地名、实体机构名识别),关键词提取,自动摘要,短语提取,拼音转换,简繁转换,文本推荐,依存句...

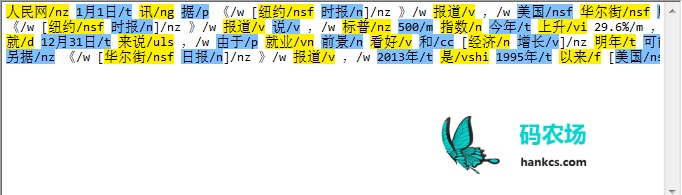

Python正则表达式处理中文文本文件一要注意编码,二要注意贪婪匹配模式。 以广为流传的人民日报分词语料为例: 人民网/nz 1月1日/t 讯/ng 据/p 《/w [纽约/nsf 时报/n]/nz 》/w 报道/v ,/w 美国/nsf ...