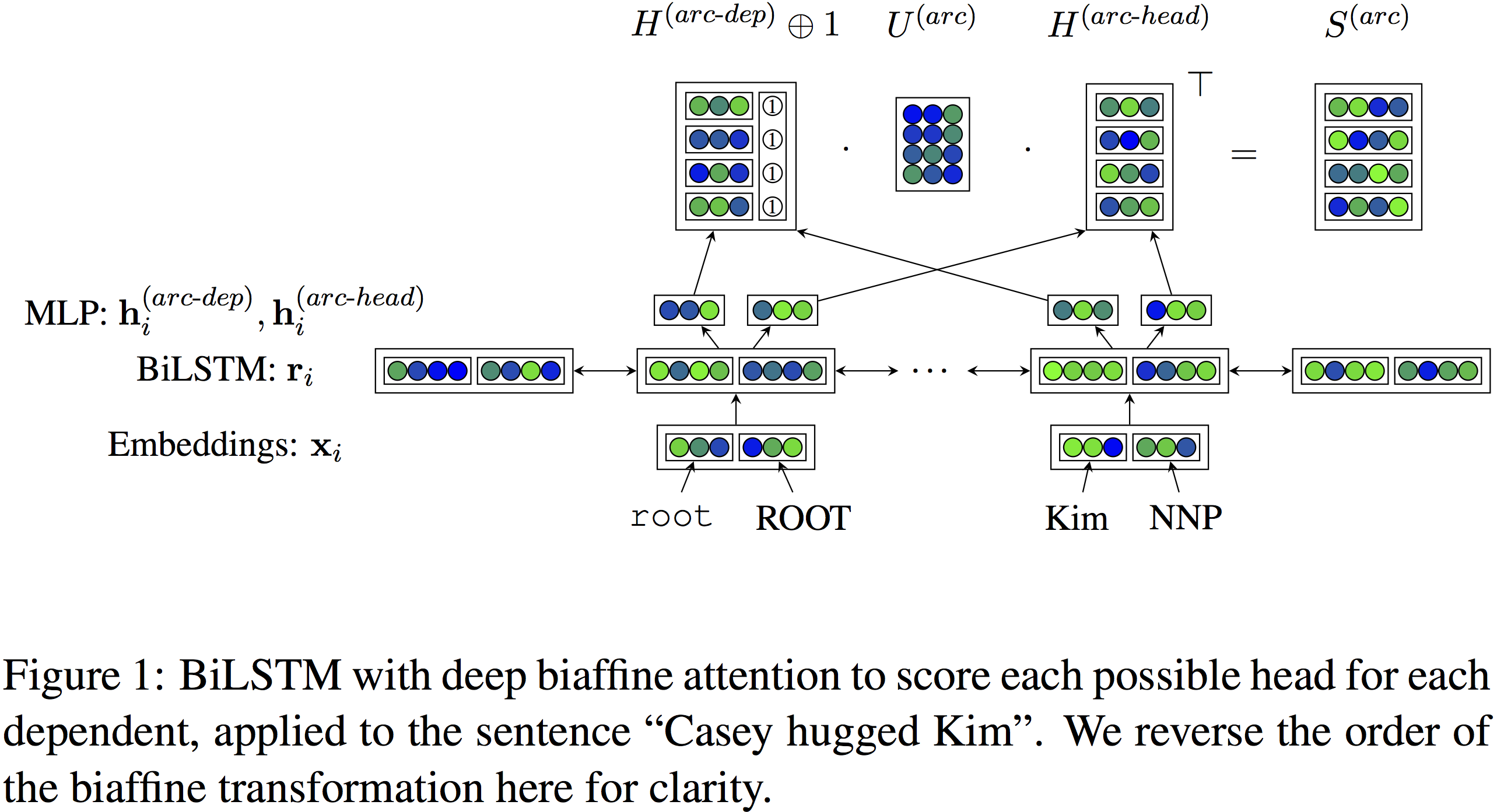

Deep Biaffine Attention for Neural Dependency Parsing

这是斯坦福专攻Dependency Parsing的博士生Dozat在ICLR 2017上的论文,拿到了graph-based方法中的最高分,改进版还拿到了CoNLL 2017 Shared Task的第一。 基于图的依存句法分析需要解决两...

这是斯坦福专攻Dependency Parsing的博士生Dozat在ICLR 2017上的论文,拿到了graph-based方法中的最高分,改进版还拿到了CoNLL 2017 Shared Task的第一。 基于图的依存句法分析需要解决两...

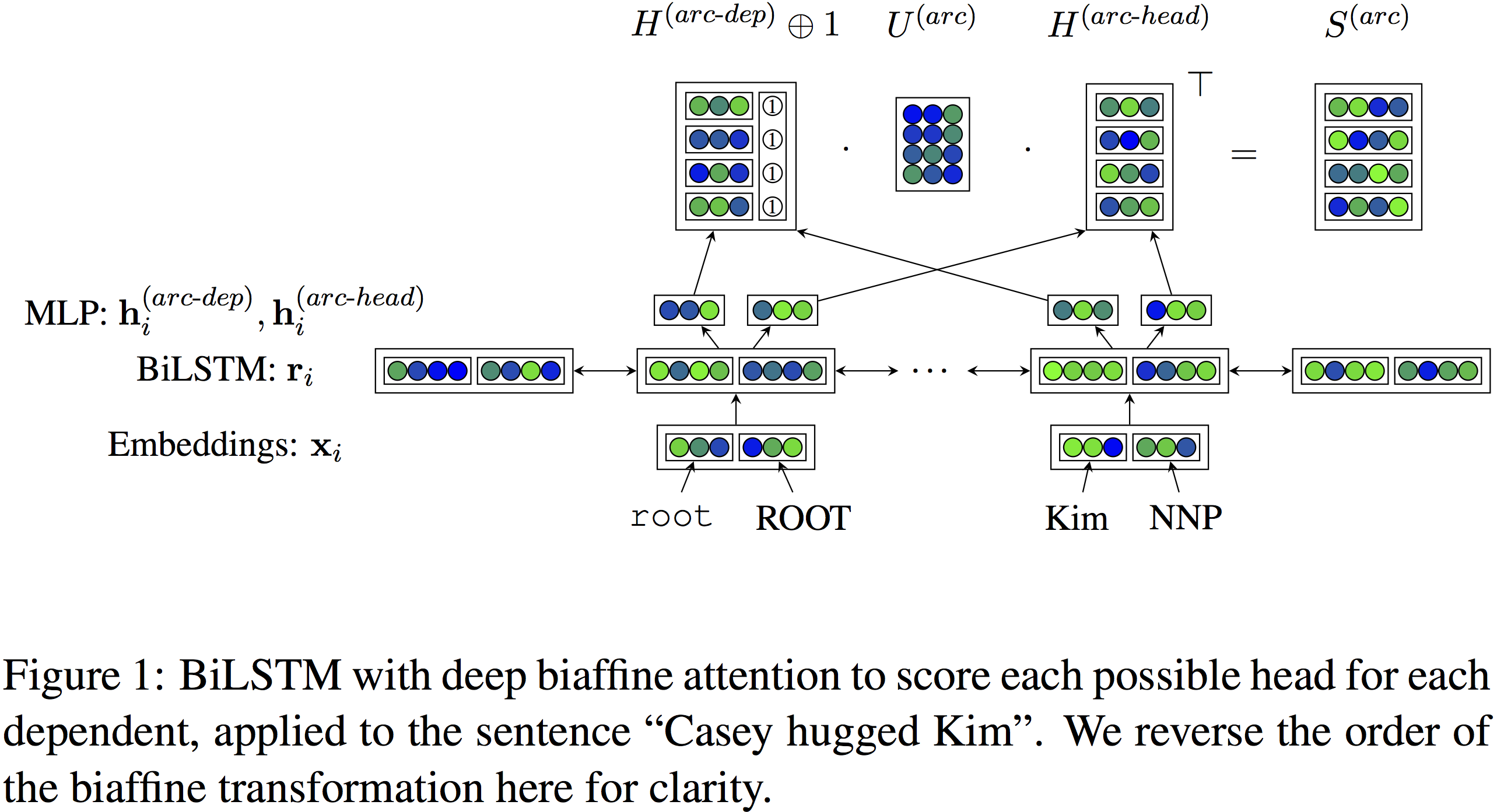

在写句法分析器之前,通常需要将PTB和CTB预处理为: 一行一个句子,单文件; 符合规范比例的训练集/开发集/测试集; 去掉CTB中的xml标签,只保留句子,编码转换。 这些步骤很麻烦,因为通常bracketed的树形结构需要先解析才能转为...

随着深度学习的普及,有越来越多的研究应用新模型到中文分词上,让人直呼“手快有,手慢无”。不过这些神经网络方法的真实水平如何?具体数值多少?以Sighan05中的PKU数据集为例,真像一些论文所言,一个LSTM-CRF就有96.5%吗?或者像...

最后一课,总结了目前这两个领域中的难题,介绍了一些前沿研究:快16倍的QRNN、自动设计神经网络的NAS等。 深度学习已经漂亮地完成了许多单项任务,但如果我们继续随机初始化模型参数,我们永远也无法得到一个可以完全理解语言的系统。模型就像蒙住...

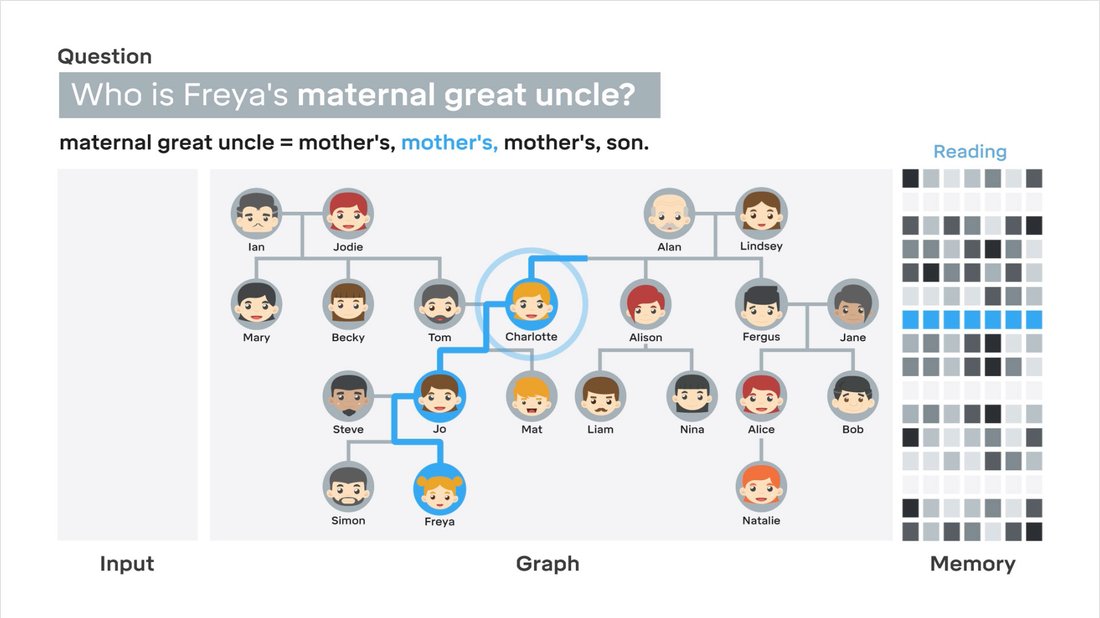

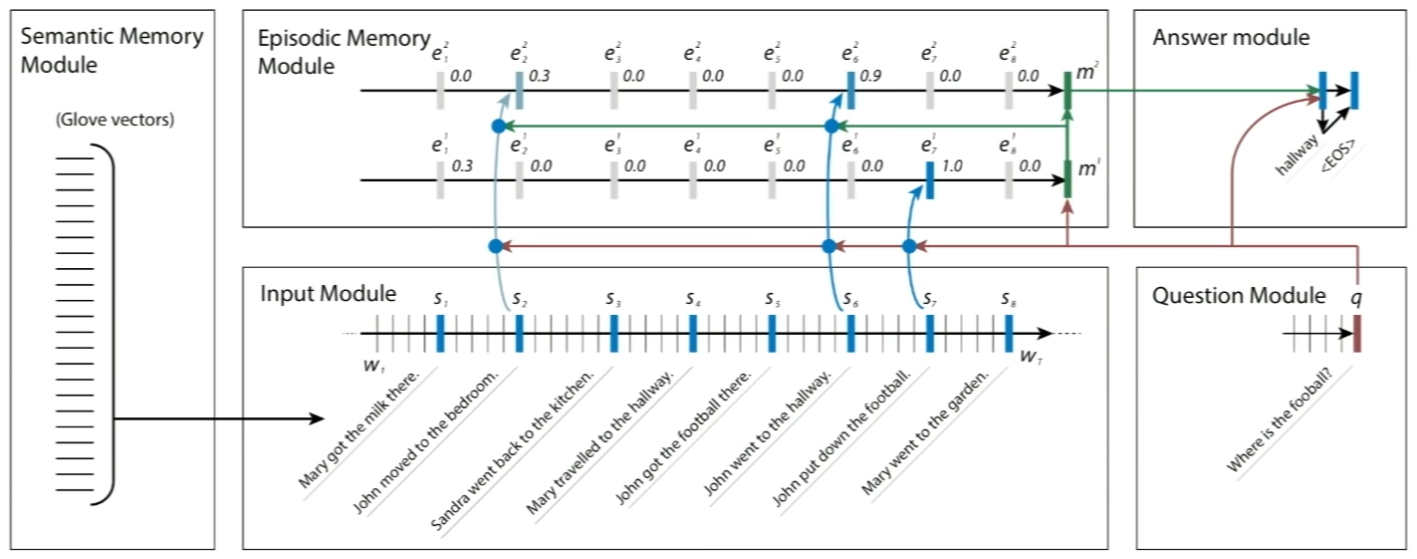

这次讲座覆盖了来自DeepMind的两篇论文: 第二篇是第一篇的轻微改进,这里只关注抽象思想。 问题 目前的神经网络擅长模式识别和动态决策,但无法使用知识进行深思或推断。比如明明可以胜任电子游戏这么复...

课程介绍了各种各样的深度学习网络与应用,是时候从更高层次思考自然语言处理存在的问题与展望未来了。虽然BiLSTM与attention几乎统治了NLP,但在篇章级别的理解与推断上还不尽人意。 新时代人们正在“解决”语言 深度学习填...

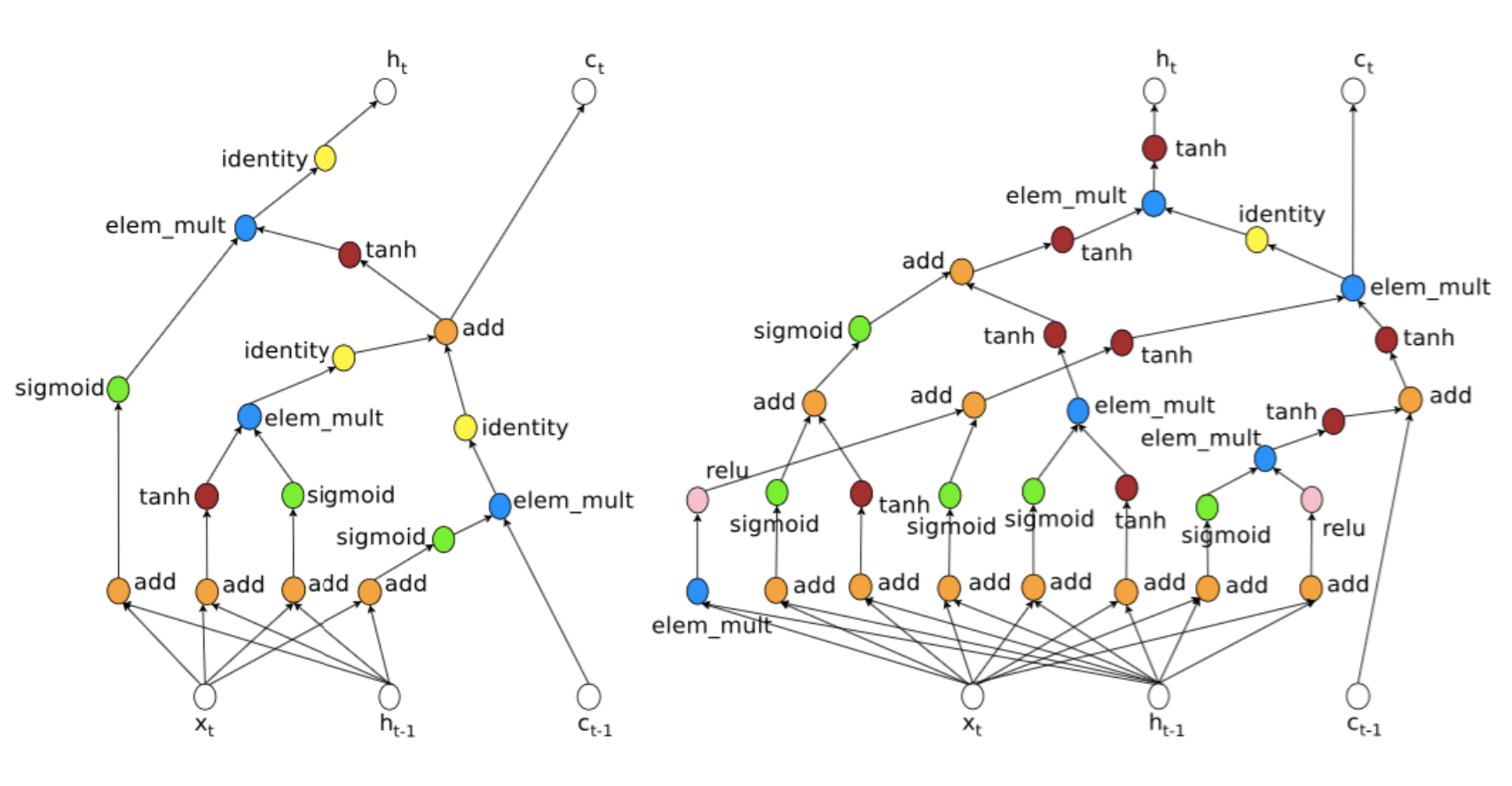

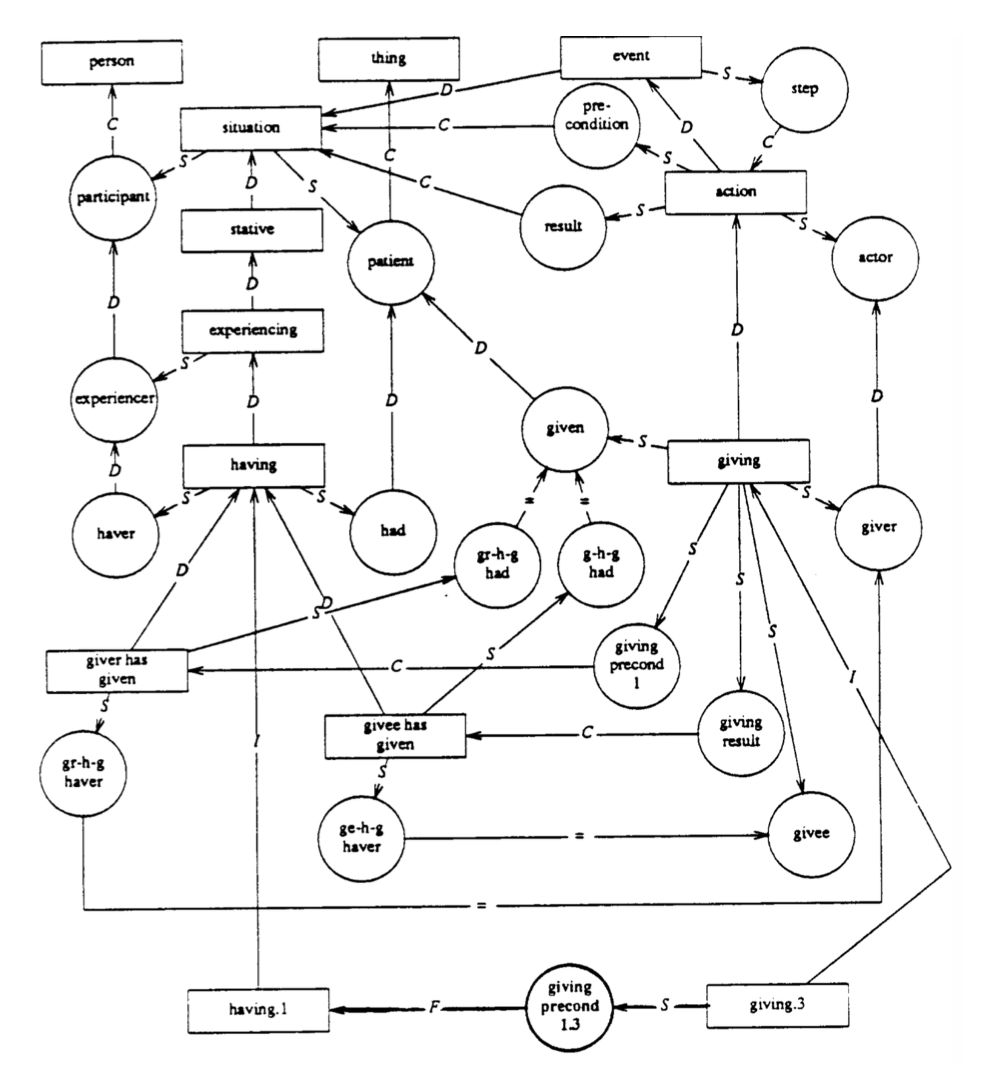

这是自我组装推断的QA,可接受多种知识,包括图片和结构化知识库。问答具有复合性,很早就有人引入句法分析判断究竟在问什么,甚至脑洞大开想做自然语言编译器。但他们总是脱离不了手写规则的思维,白白糟蹋了性能卓越的句法分析器。而该模型自动组装多个神...

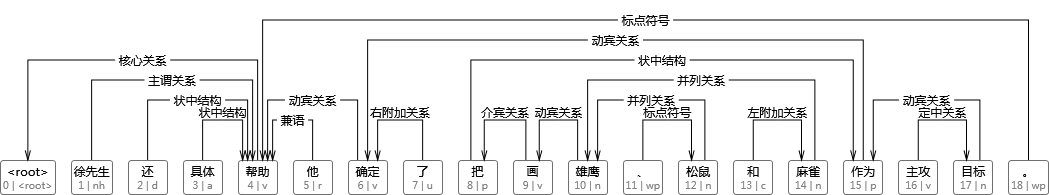

最有意思的一课,将所有NLP任务视作QA问题。模仿人类粗读文章和问题,再带着问题反复阅读文章的行为,利用DMN这个通用框架漂亮地解决了从词性标注、情感分析到机器翻译、QA等一系列任务。 是否所有NLP任务都可视作QA? 问答系统举例如下: ...

在培训码农的时候,教师需要给学生批改代码、写反馈。学生太多时成为机械劳动,这篇论文研究自动编码程序的语义表示。数据集来自斯坦福开发的模拟操控机器人的语言。 表示代码 希望得到代码的简洁表示、运行后会得到什么结果,哪怕它无法编译运...

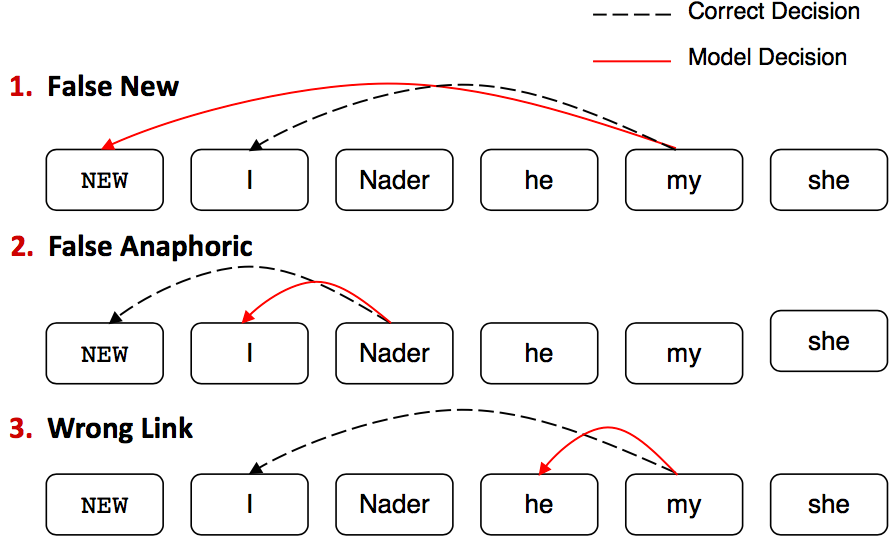

从规则启发式代词回指消解出发,介绍了传统特征工程二分类模型、启发式损失的分类模型,过渡到利用强化学习自动缩放损失的神经网络模型。 什么是指代消解 找出文本中名词短语所指代的真实世界中的事物。比如: 不只是代词能够指代其他事物,所...