CS224n研究热点13 学习代码的语义

在培训码农的时候,教师需要给学生批改代码、写反馈。学生太多时成为机械劳动,这篇论文研究自动编码程序的语义表示。数据集来自斯坦福开发的模拟操控机器人的语言。 表示代码 希望得到代码的简洁表示、运行后会得到什么结果,哪怕它无法编译运...

在培训码农的时候,教师需要给学生批改代码、写反馈。学生太多时成为机械劳动,这篇论文研究自动编码程序的语义表示。数据集来自斯坦福开发的模拟操控机器人的语言。 表示代码 希望得到代码的简洁表示、运行后会得到什么结果,哪怕它无法编译运...

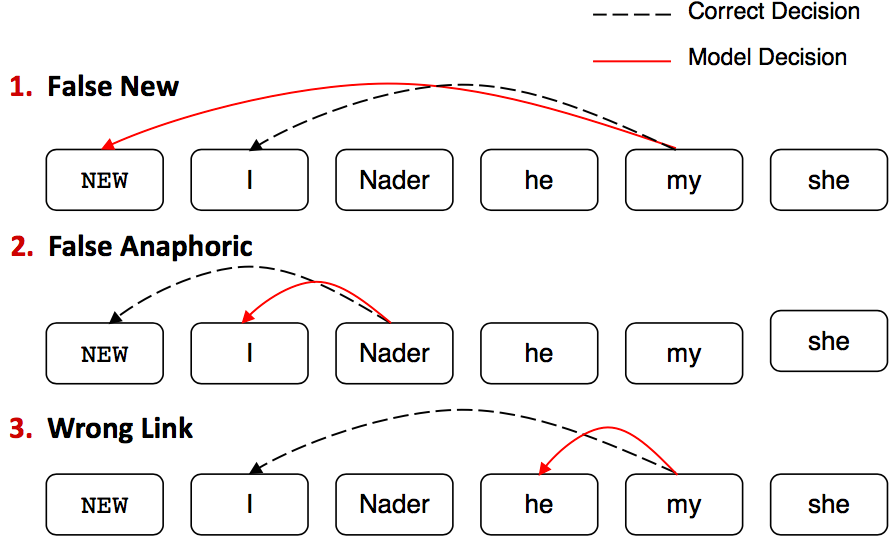

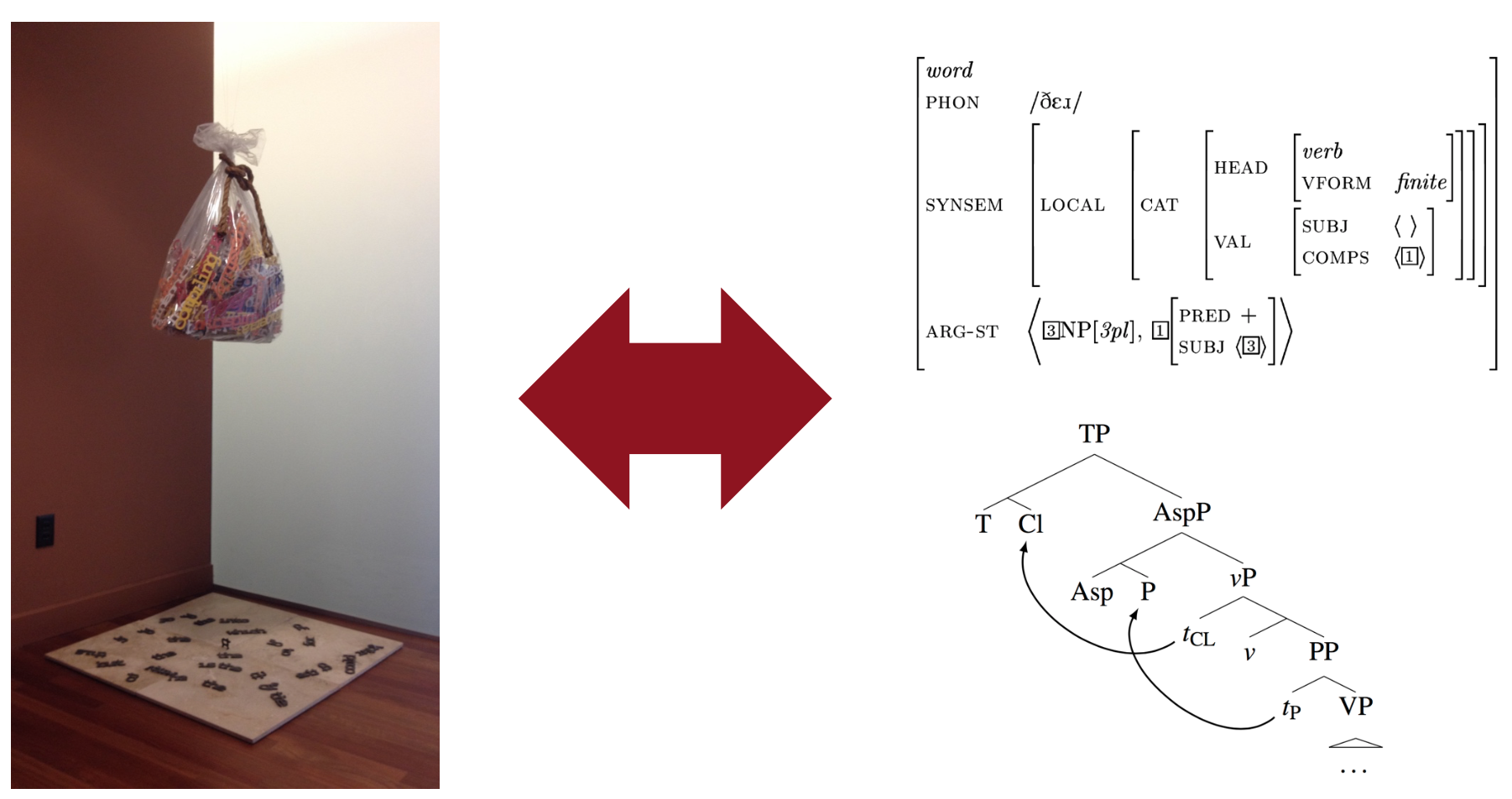

从规则启发式代词回指消解出发,介绍了传统特征工程二分类模型、启发式损失的分类模型,过渡到利用强化学习自动缩放损失的神经网络模型。 什么是指代消解 找出文本中名词短语所指代的真实世界中的事物。比如: 不只是代词能够指代其他事物,所...

任务与数据集 自动生成C#和SQL代码的文档描述,数据集整理自StackOverflow上的提问。 子任务 根据代码生成摘要,或根据问题检索代码。 网络架构 一个LSTM处理已生成的文本token,一个在...

介绍了著名的复合性原理,由此启发得到树形RNN,用于表示短语和句子级别的语义。从朴素树形RNN到SU-RNN和MV-RNN,讨论了进化历史和各自优缺点,演示了效果和在图像等领域的拓展应用。 语言模型光谱 最简陋最常用的是词袋模型...

这篇论文研究如何训练聊天机器人进行有意义的对话,常规方法是seq2seq: 与上几次课讲的机器翻译框架相同,encoder与decoder,相同的极大似然估计目标函数。 seq2seq的缺陷 通过该方法训练出来的聊天机器人容易陷...

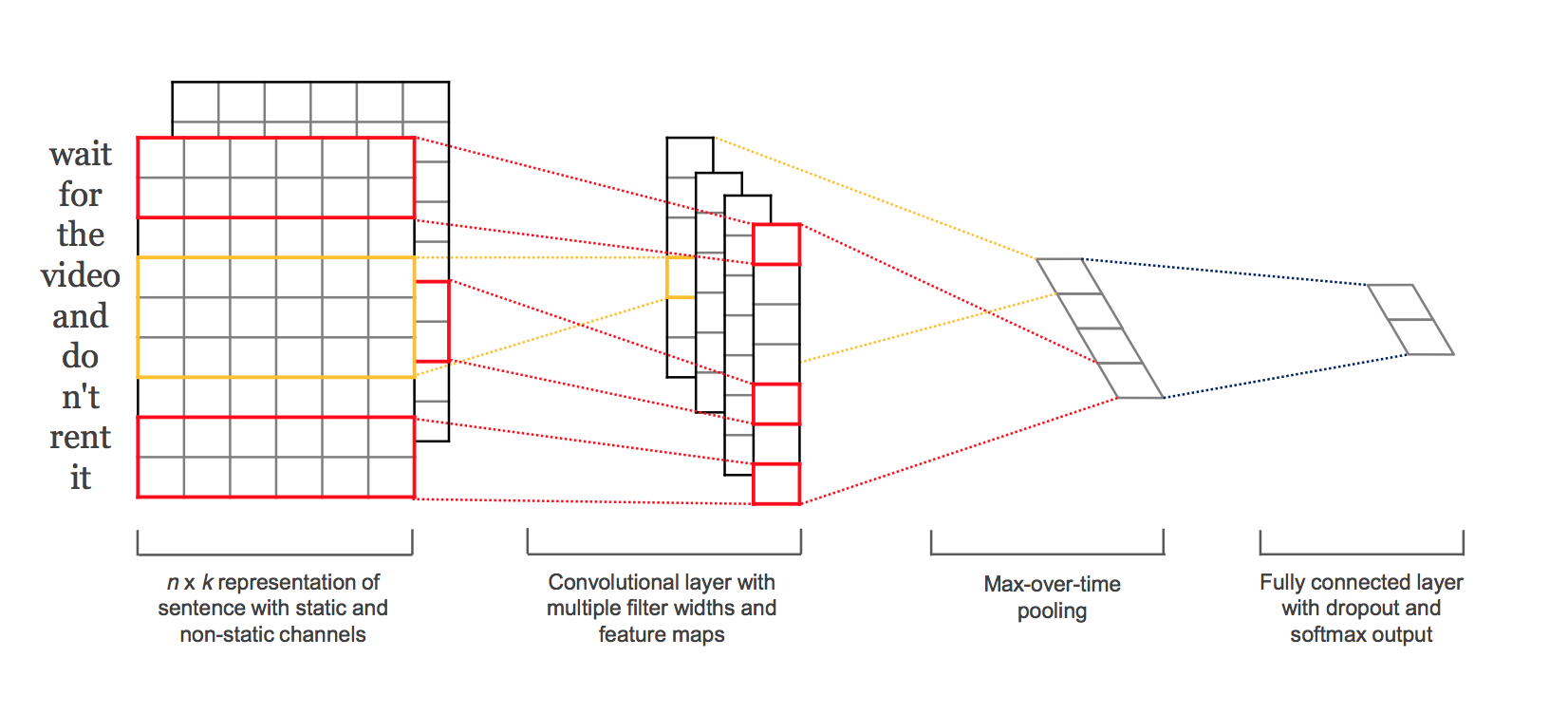

补充了NLP中相对冷门的CNN,谈了谈调参与发论文的潜规则。 从RNN到CNN RNN无法利用未来的特征预测当前单词,就算是bi-RNN,也不过是双向重蹈覆辙而已。 经常把过多注意力放到最后一个单词上。 比如,如果只想得到my birth的...

动机 大多数神经网络语言模型其实并没有注意到结构类似的词语意义也类似这种语言现象,这使它们无法赋予低频词合适的表示。所以这个新模型的目标是: 编码词素相关性:eventful, eventfully, uneventful 解决低频词问题 ...

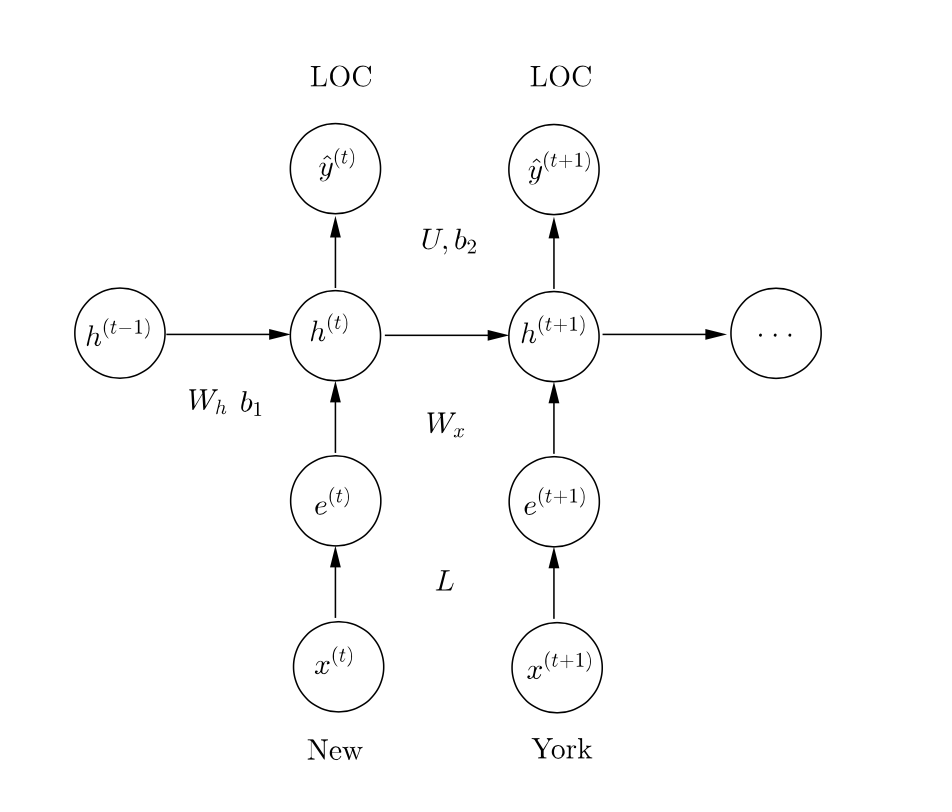

命名实体识别任务,先实现基于窗口的基线模型,然后进阶到RNN和GRU。中间利用对自动机的模拟和推导展示RNN的缺点,演示梯度剪裁的作用。这是Latex解答,代码已提交,最后还有一个彩蛋。 命名实体识别初步 定位命名实体并将其分类到: 人名P...

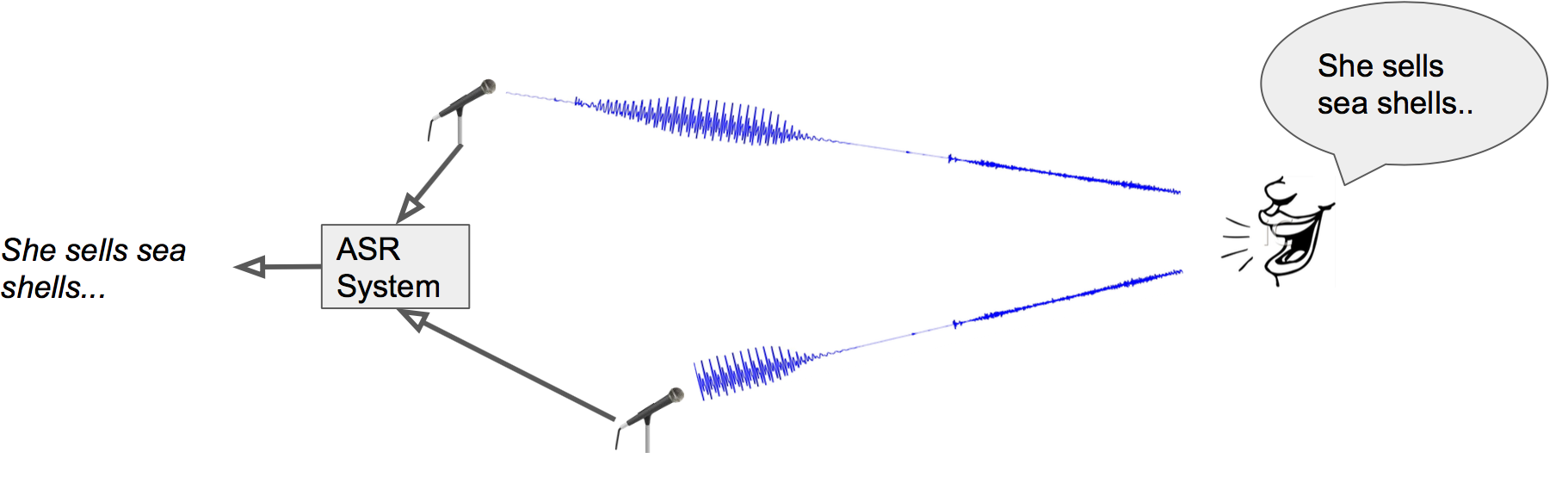

这次斯坦福请到了深度学习教父Hinton的弟子Navdeep来讲语音识别,他正在英伟达工作,怪不得N卡在深度学习中的地位如此之高。而他本人也在用Dell的搭载了N卡的XPS跑Ubuntu,一改以往“讲台必定信仰灯”的局面。 Automati...

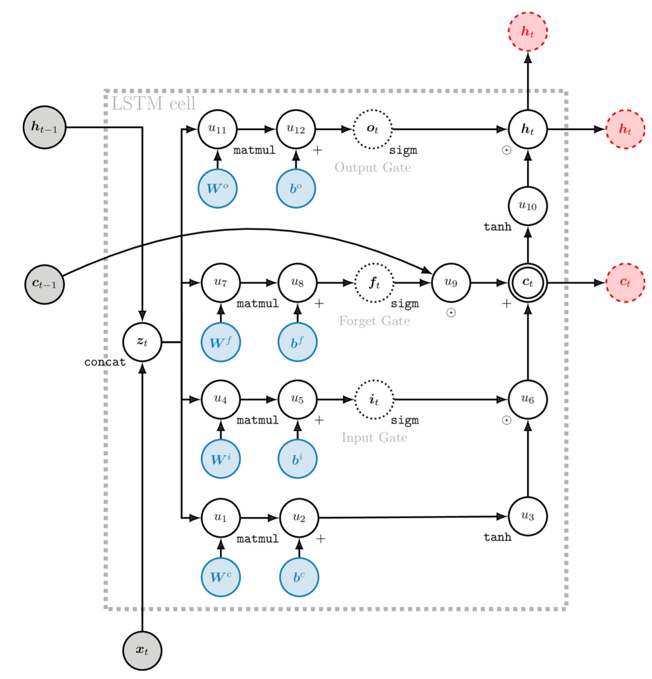

从动机层面直观地充实了GRU和LSTM的理解,介绍了MT的评测方法,讨论了NMT中棘手的大词表问题和一些常见与最新的解决办法。 深入GRU 把GRU再详细讲一讲。 RNN的梯度消失就不赘述了,红线连乘多次下溢出。 而GRU额外添...