如果你是能力不足的小白,请直接使用傻瓜安装包。

能力达标的话,![]() 一句话安装pyhanlp,全自动下载安装配置,还支持升级。

一句话安装pyhanlp,全自动下载安装配置,还支持升级。

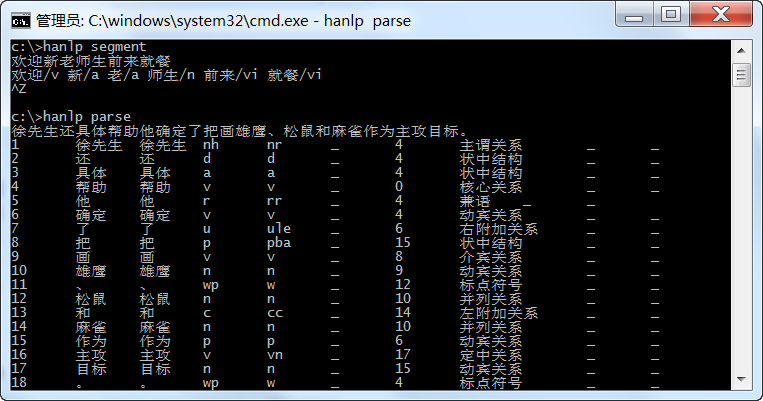

pip install pyhanlp

调用方法参考项目主页:https://github.com/hankcs/pyhanlp

Windows用户如果遇到:

building '_jpype' extension error: Microsoft Visual C++ 14.0 is required. Get it with "Microsoft Visual C++ Build Tools": http://landinghub.visualstudio.com/visual-cpp-build-tools

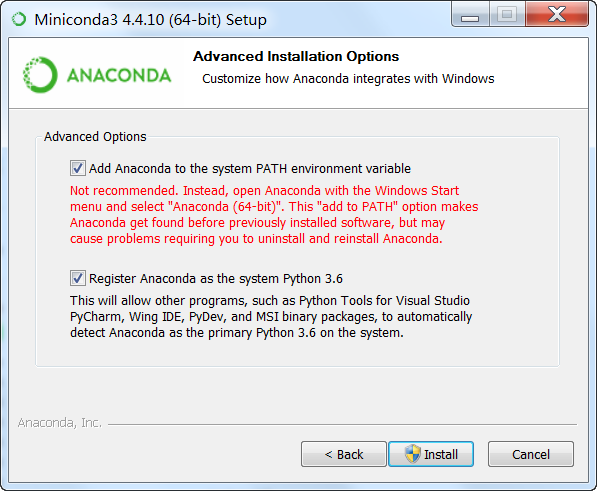

可以按提示安装Visual C++,也可以安装轻量级的Miniconda(推荐,超方便):

然后通过conda安装jpype1和pyhanlp:

conda install -c conda-forge jpype1==0.7.0 pip install pyhanlp

以前的文章已经过时,不用看了。

码农场

码农场