HanLP招聘

NLP 工程师 工作内容 研发业内领先的语言理解与生成、知识图谱与推理、语义索引与搜索的技术体系。包括但不限于如下方向—— 核心NLU技术:分词、词性标注、命名实体识别、句法分析、语义分析; 可控NLG技术:文本摘要、文章生成、代码生成、机...

NLP 工程师 工作内容 研发业内领先的语言理解与生成、知识图谱与推理、语义索引与搜索的技术体系。包括但不限于如下方向—— 核心NLU技术:分词、词性标注、命名实体识别、句法分析、语义分析; 可控NLG技术:文本摘要、文章生成、代码生成、机...

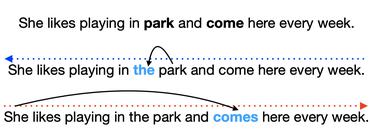

在进行一项NLP任务前,了解评测指标至关重要。以语法纠错为例,一项评测如何定义、如何对齐黄金与预测数据、是否符合人工评测、是否支持多语种等等都值得关注。本文简要评测几个常用的评测指标,特别关注对中文的支持程度。 首先,语法纠错任务经常定义为...

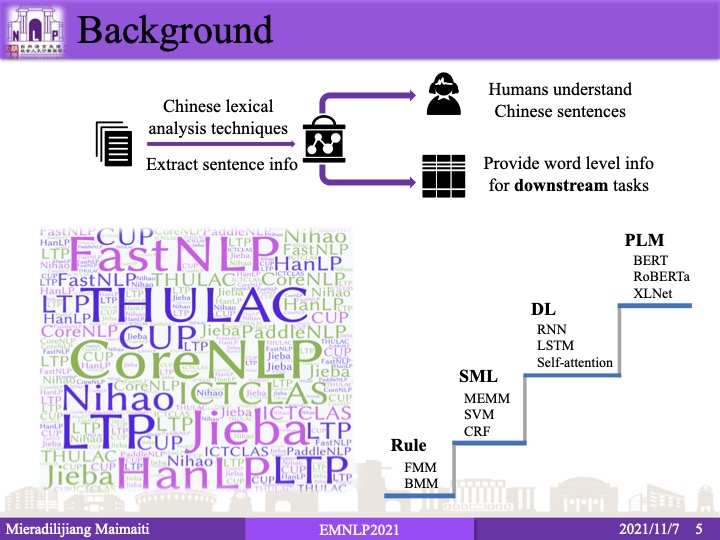

很久没有关注中文分词,今年恰好开会听了这篇清华领衔的长论文,分数相当不错。而且还引用了我的第一篇论文,于是简要介绍一下。虽然仰慕已久,但我与论文作者们并无私交。本文仅代表我的个人观点,如果有任何理解或表述错误,都是我的责任,与原作者无关。图...

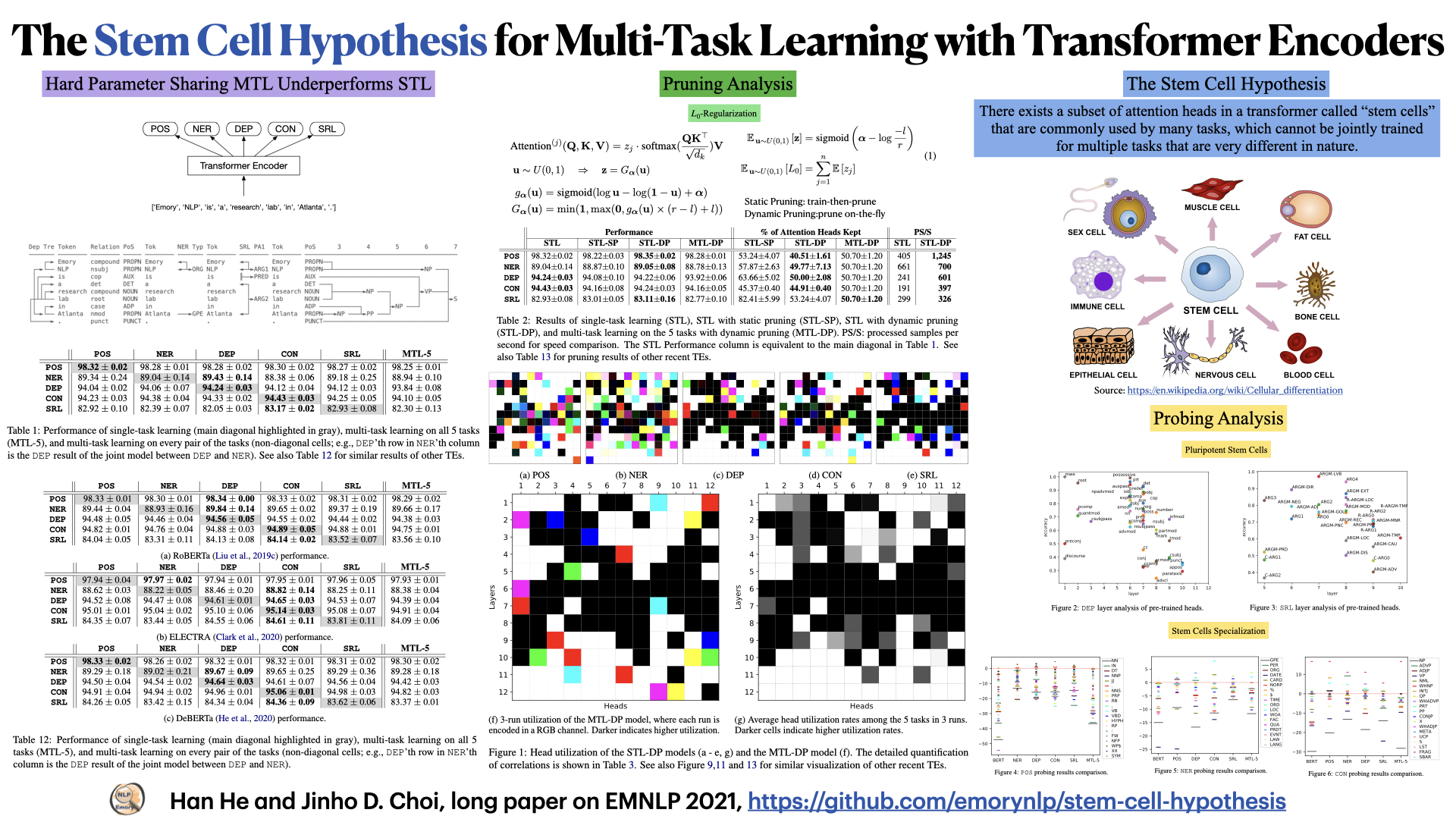

近来预训练语言模型在许多任务上成果斐然,然而在多任务联合学习上则差强人意。通过剪枝,我们发现所有任务会争夺一些通用的注意力头。据此,我们提出了干细胞假说:预训练会孕育一些天才注意力头,如同干细胞,可以分化为专精一种任务的功能细胞,却难以同时...

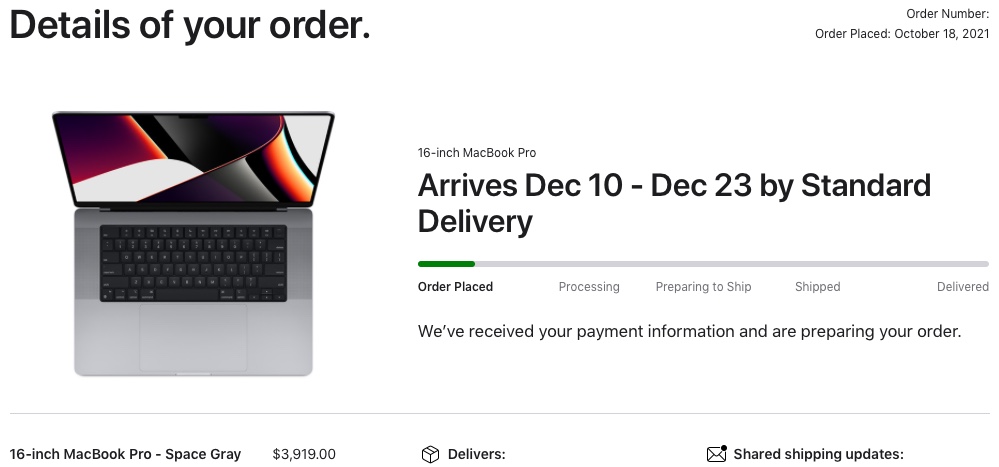

今天我的MBP M1MAX终于寄到了,于是第一时间为HanLP提供M1的原生CPU+GPU支持。MBP用户从此享受到GPU加速的推理与训练,微调个BERT同样丝滑。本文简要介绍原生环境搭建与安装,适用于包括M1系列在内的Apple Sili...

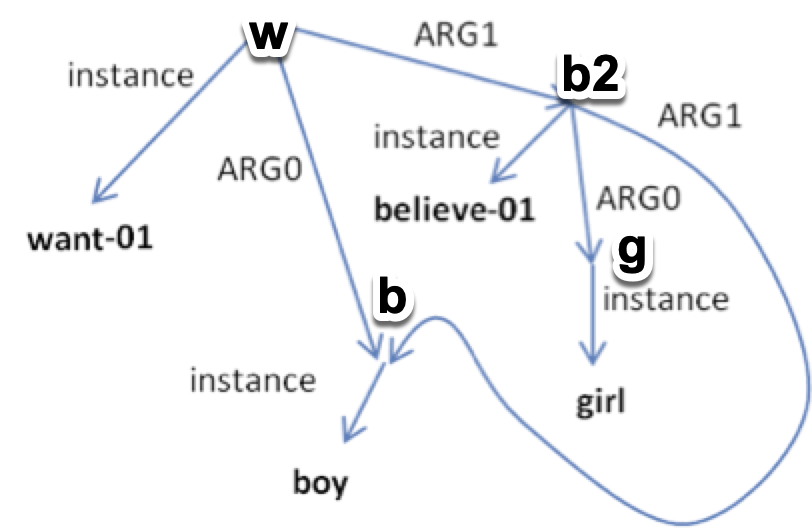

上周收到LDC的订阅邮件,由布兰迪斯大学和南京师范大学联合标注的中文抽象意义表示语料库2.0(CAMR 2.0)发布了。于是第一时间下单购买,做一期开箱评测。 抽象意义表示(Abstract Meaning Representation,A...

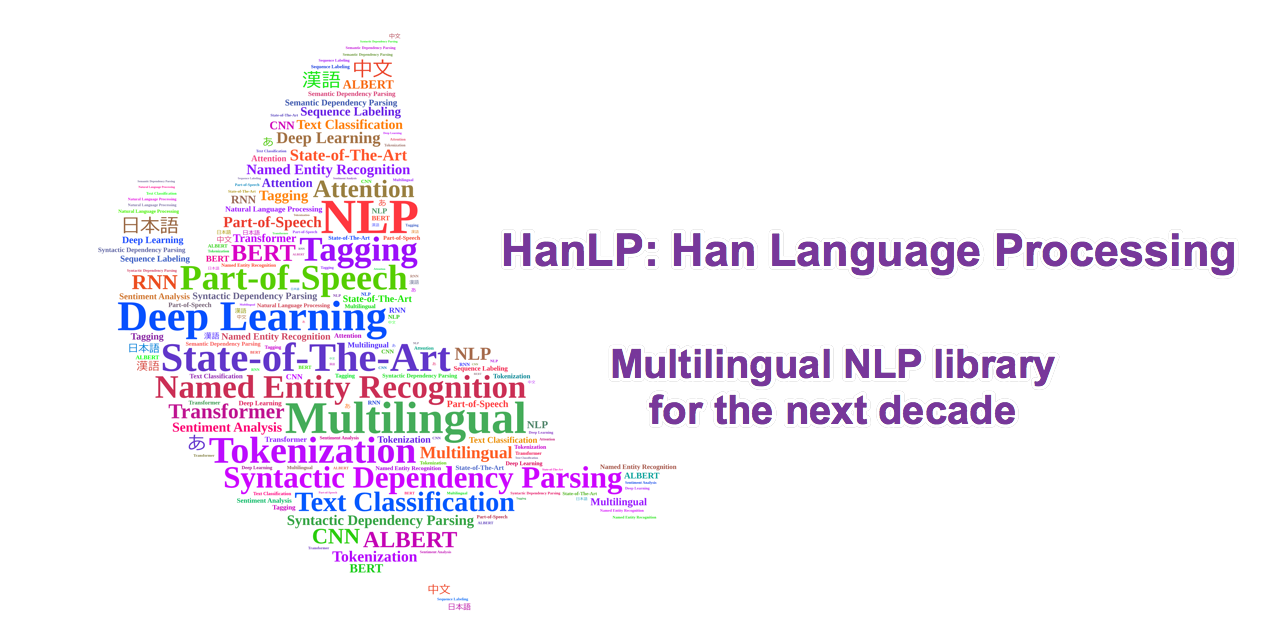

面向生产环境的多语种自然语言处理工具包,基于 TensorFlow 2.0,目标是普及落地最前沿的NLP技术。HanLP具备功能完善、性能高效、架构清晰、语料时新、可自定义的特点。目前,基于深度学习的HanLP 2.0正处于alpha测试阶...

AAAI19的论文(Sap et al. (2019))开源了一个包含87万条推理常识的知识图谱ATOMIC。相较于常见的基于本体论分类条目的知识图谱,该知识库专注于“如果…那么…”关系的知识。作者提出了9种类型的因果联系来区分原因-效果、...

2019最新的微博语料,可用于预训练语言模型Weibo-BERT词向量等。由于比较时新,对网络流行语的建模可能很有帮助。每个压缩包都有两千多万条,一共5个。大家下载之后也算是有一个亿身家的人了,激动吧。感兴趣的同学要不要训练个Weibo-B...

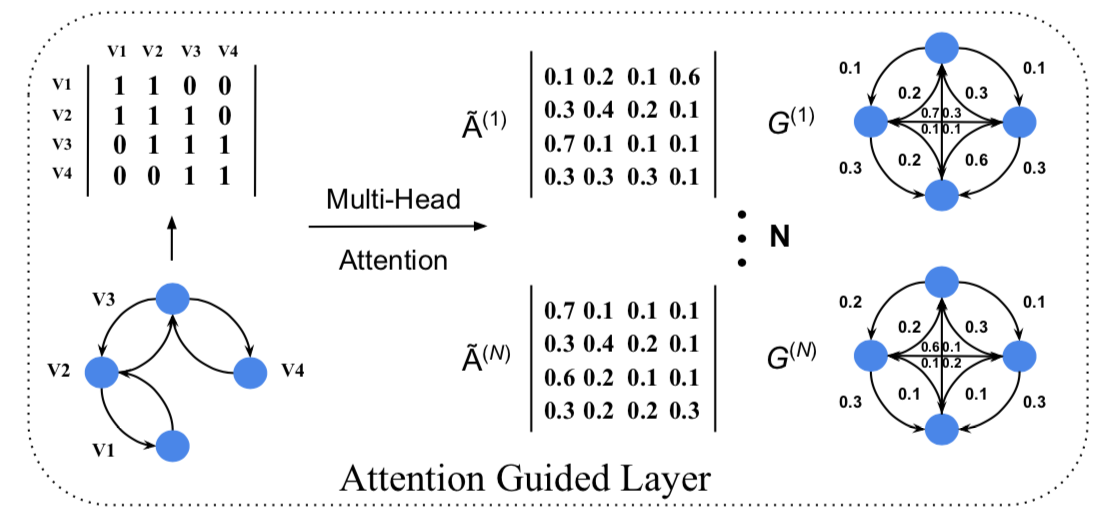

句法分析是一项核心的NLP任务,目标是获取句子的主谓宾等句法结构。下级应用时,给定依存句法树,传统时代利用规则提取句法树的特征;在深度学习时代,如何提取树的向量表示?本文调研了7种常用模型,涵盖Tree RNN、DCNN和GCN等。 Tre...