CS224n笔记18 挑战深度学习与自然语言处理的极限

最后一课,总结了目前这两个领域中的难题,介绍了一些前沿研究:快16倍的QRNN、自动设计神经网络的NAS等。 深度学习已经漂亮地完成了许多单项任务,但如果我们继续随机初始化模型参数,我们永远也无法得到一个可以完全理解语言的系统。模型就像蒙住...

最后一课,总结了目前这两个领域中的难题,介绍了一些前沿研究:快16倍的QRNN、自动设计神经网络的NAS等。 深度学习已经漂亮地完成了许多单项任务,但如果我们继续随机初始化模型参数,我们永远也无法得到一个可以完全理解语言的系统。模型就像蒙住...

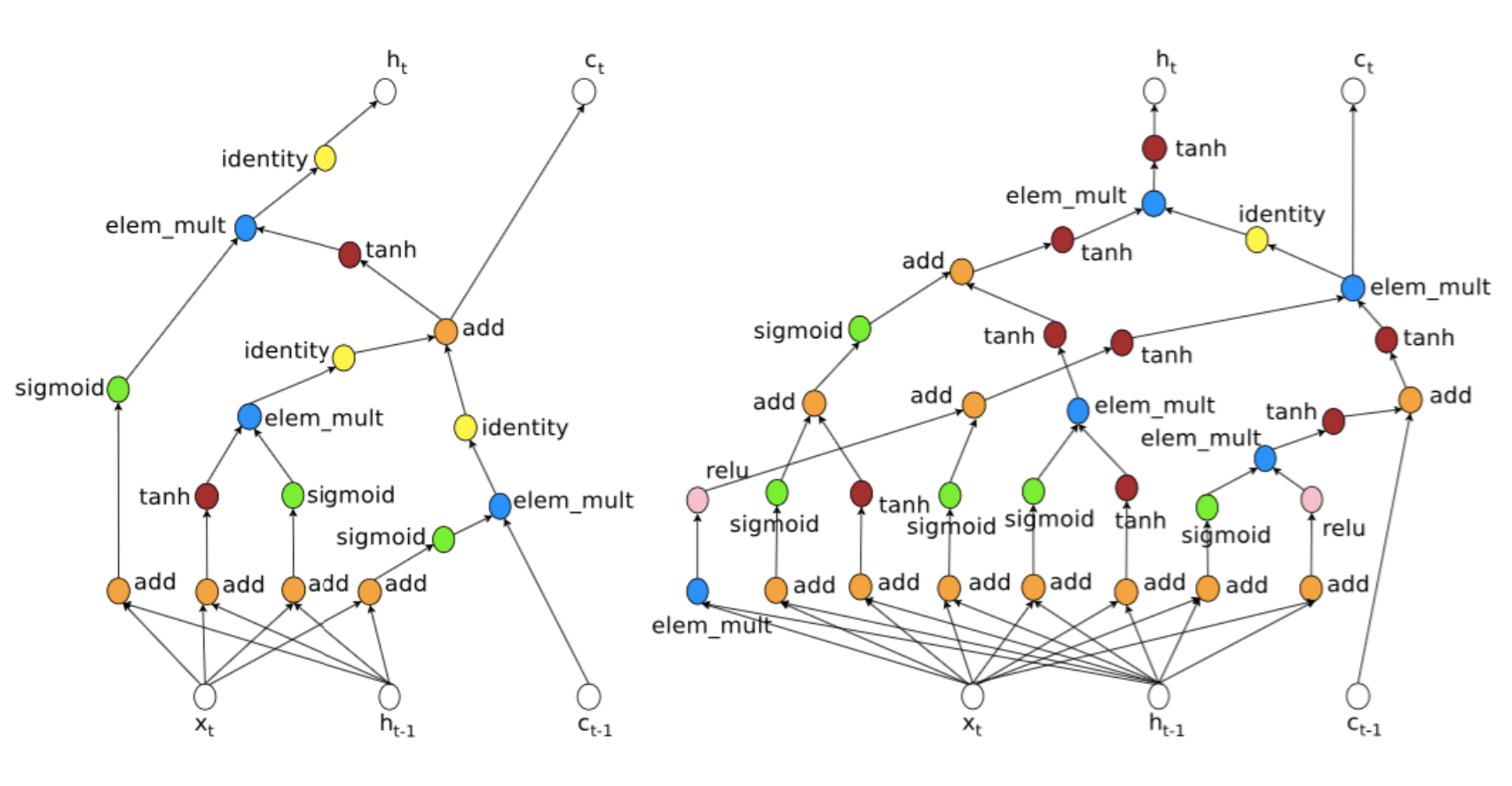

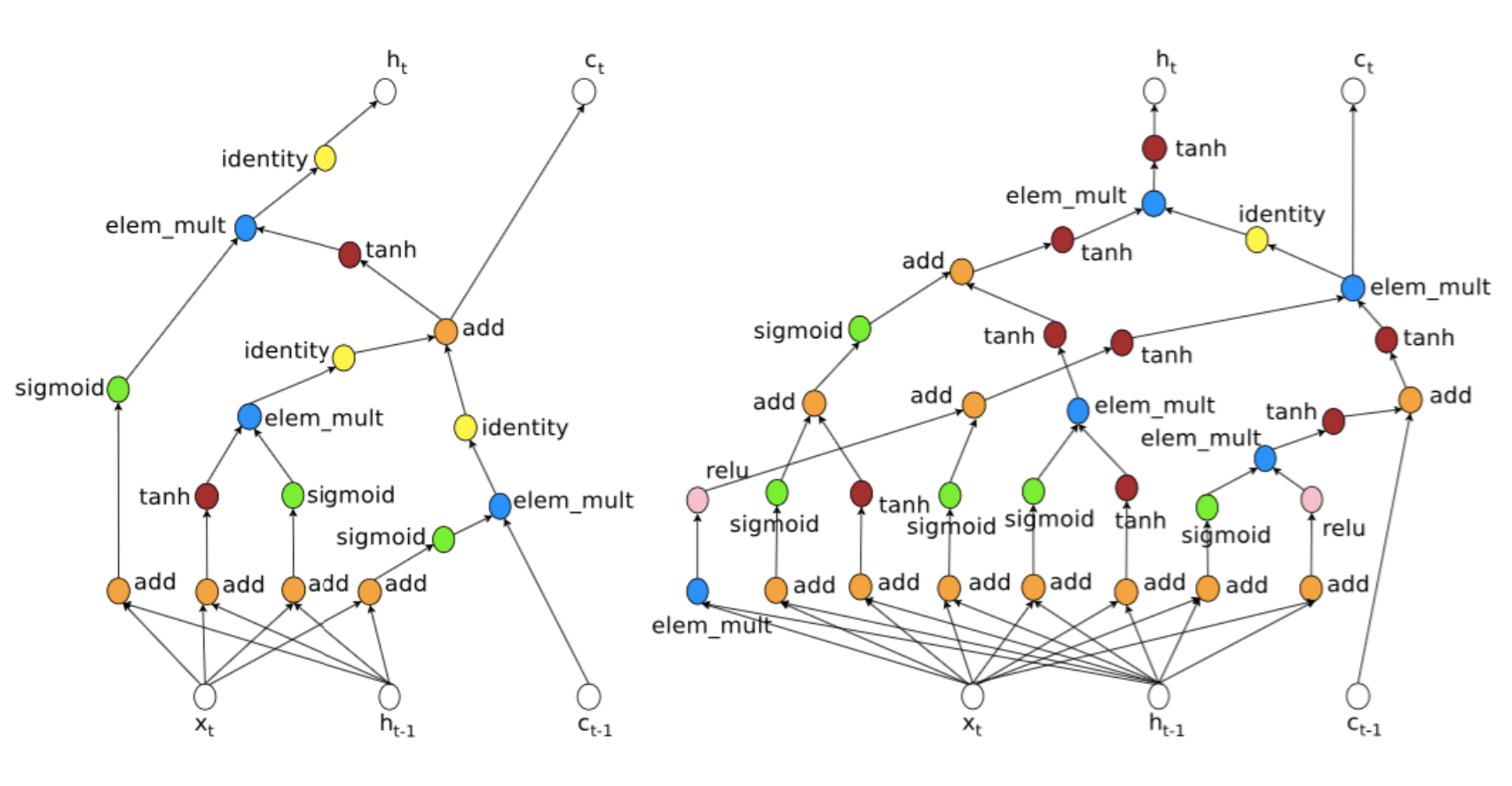

课程介绍了各种各样的深度学习网络与应用,是时候从更高层次思考自然语言处理存在的问题与展望未来了。虽然BiLSTM与attention几乎统治了NLP,但在篇章级别的理解与推断上还不尽人意。 新时代人们正在“解决”语言 深度学习填...

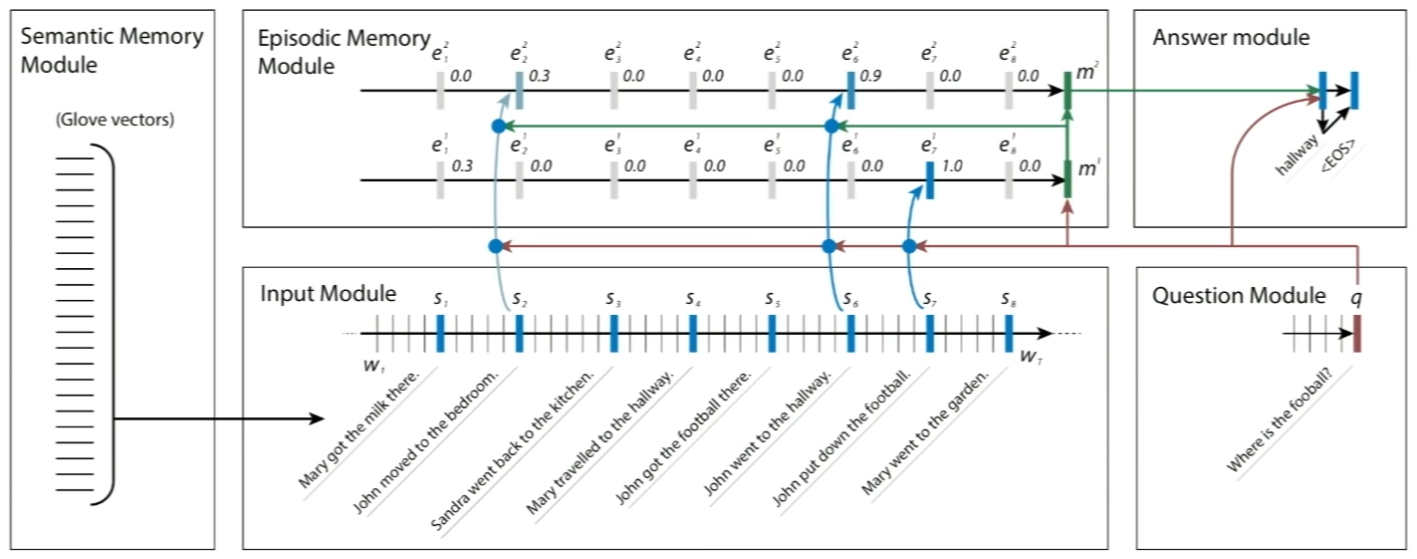

最有意思的一课,将所有NLP任务视作QA问题。模仿人类粗读文章和问题,再带着问题反复阅读文章的行为,利用DMN这个通用框架漂亮地解决了从词性标注、情感分析到机器翻译、QA等一系列任务。 是否所有NLP任务都可视作QA? 问答系统举例如下: ...

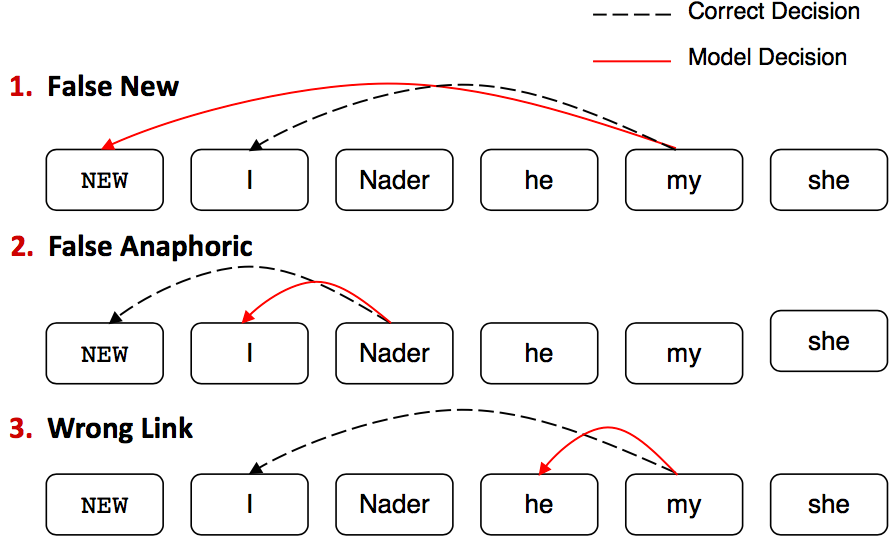

从规则启发式代词回指消解出发,介绍了传统特征工程二分类模型、启发式损失的分类模型,过渡到利用强化学习自动缩放损失的神经网络模型。 什么是指代消解 找出文本中名词短语所指代的真实世界中的事物。比如: 不只是代词能够指代其他事物,所...

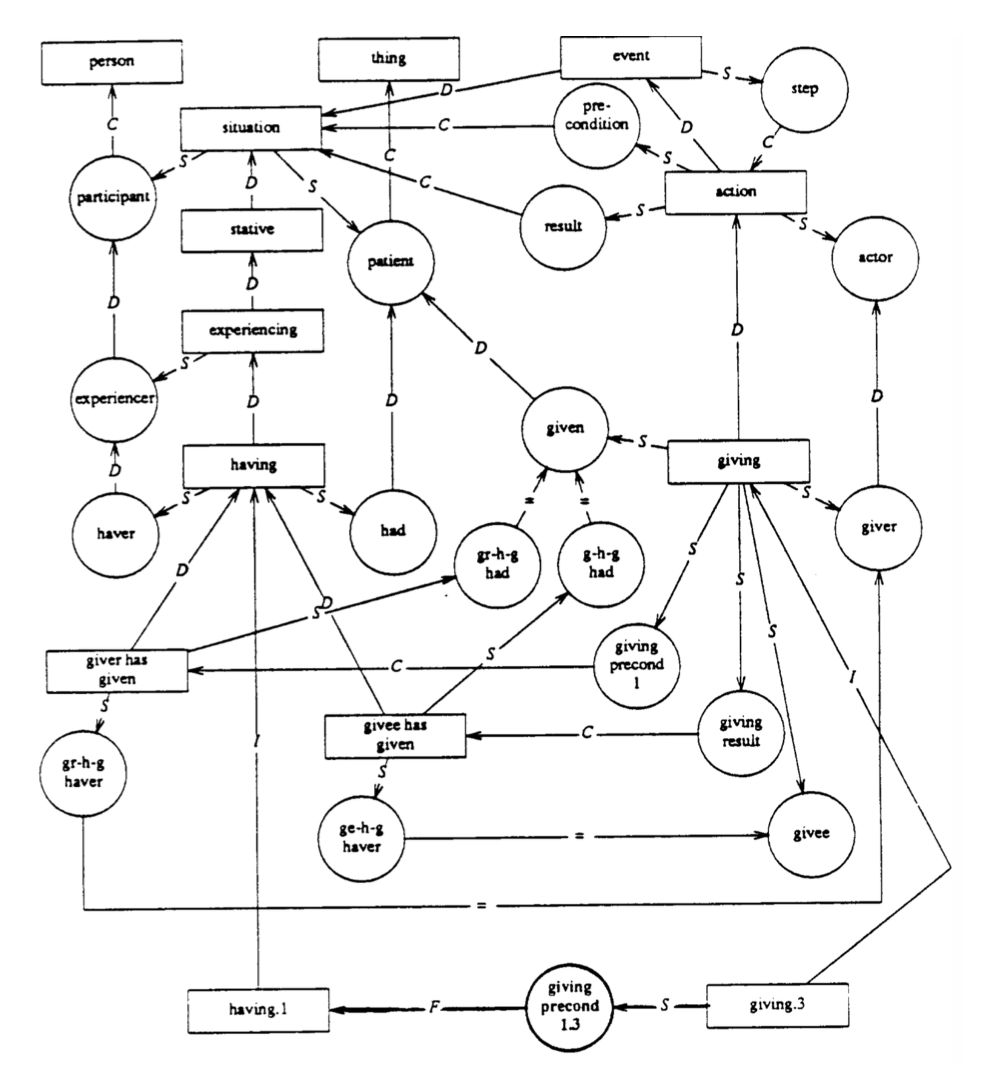

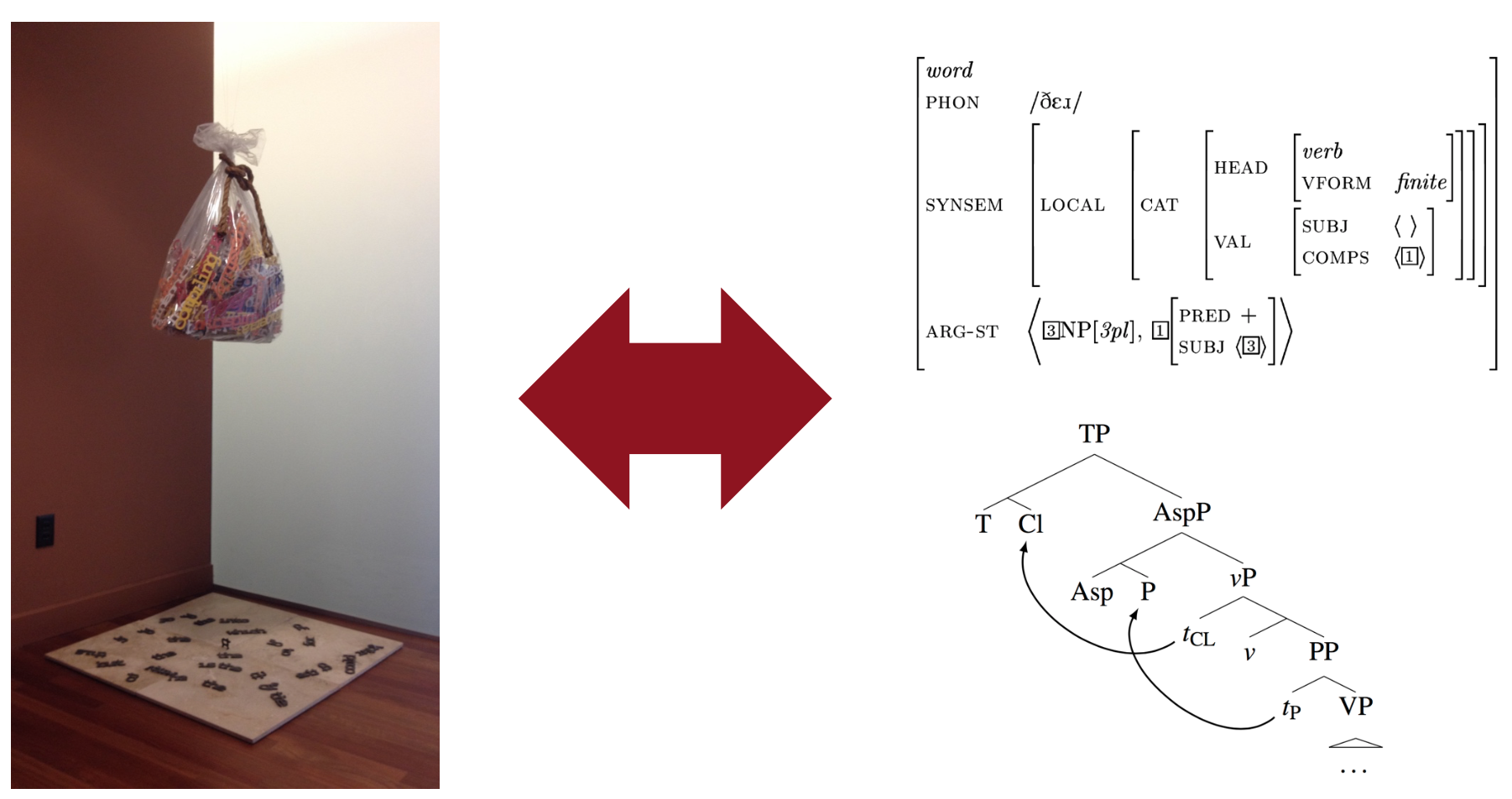

介绍了著名的复合性原理,由此启发得到树形RNN,用于表示短语和句子级别的语义。从朴素树形RNN到SU-RNN和MV-RNN,讨论了进化历史和各自优缺点,演示了效果和在图像等领域的拓展应用。 语言模型光谱 最简陋最常用的是词袋模型...

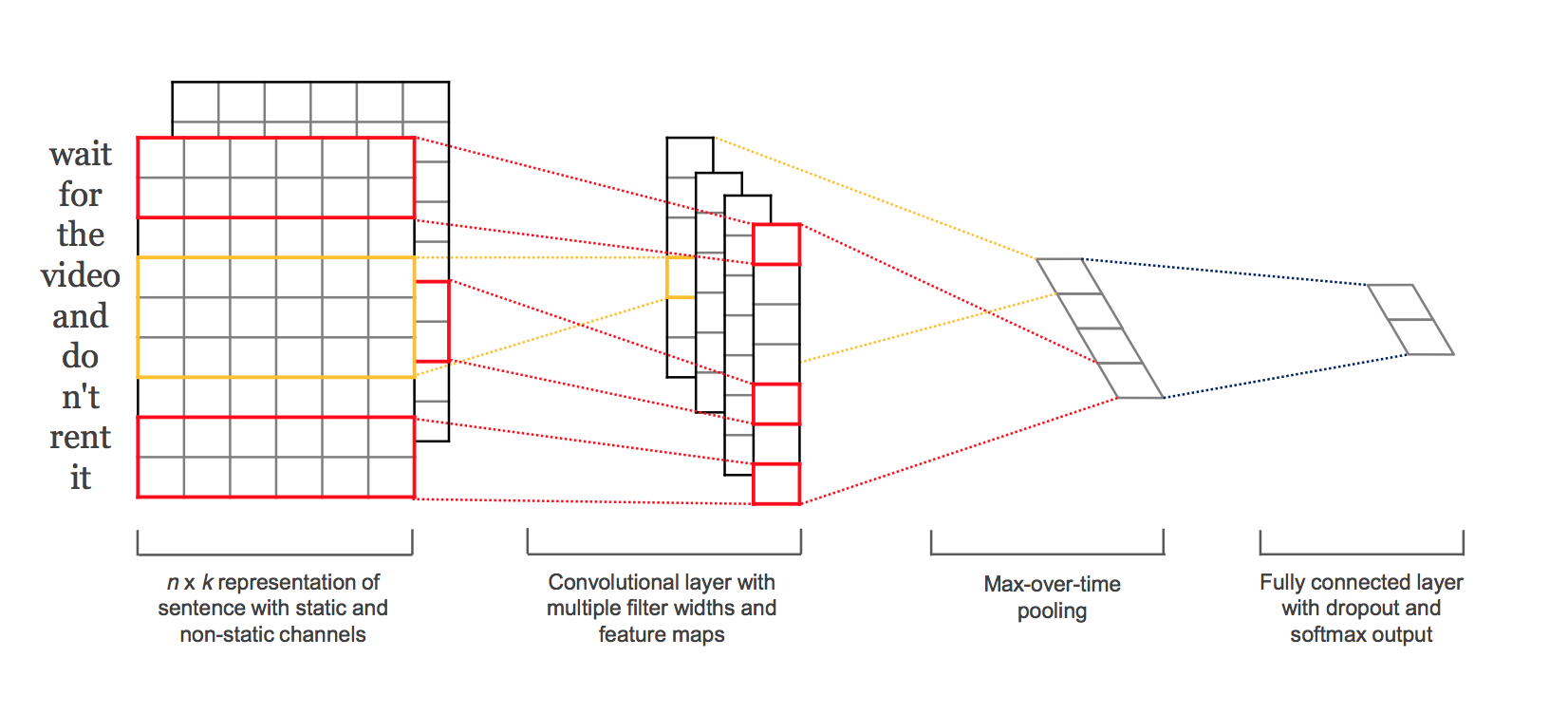

补充了NLP中相对冷门的CNN,谈了谈调参与发论文的潜规则。 从RNN到CNN RNN无法利用未来的特征预测当前单词,就算是bi-RNN,也不过是双向重蹈覆辙而已。 经常把过多注意力放到最后一个单词上。 比如,如果只想得到my birth的...

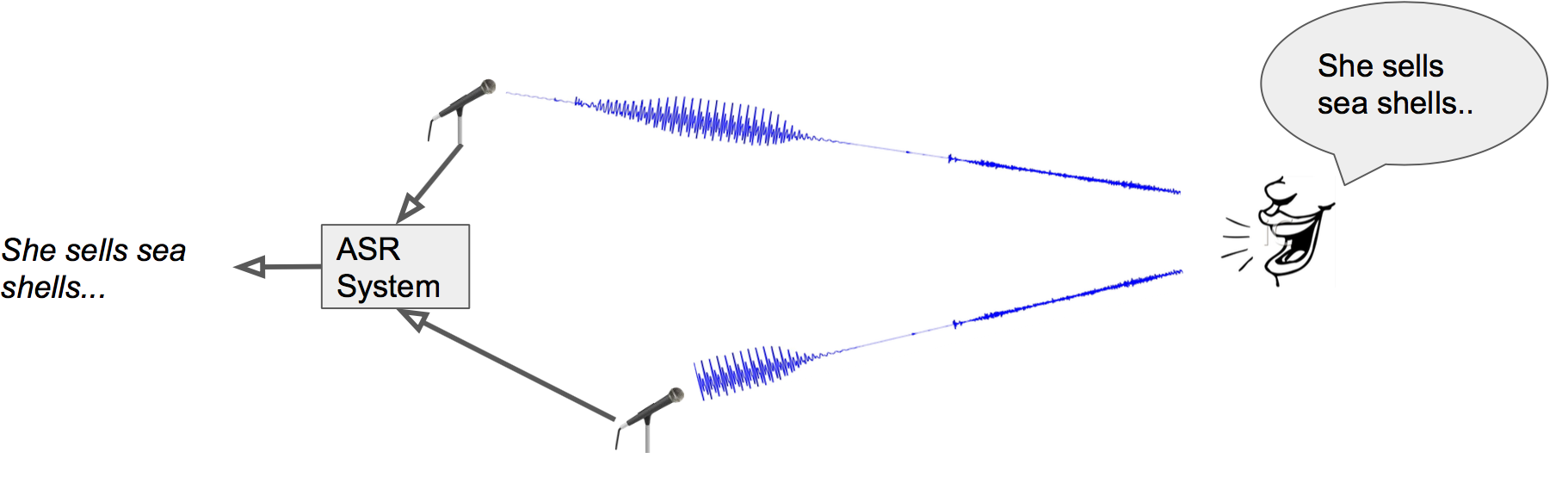

这次斯坦福请到了深度学习教父Hinton的弟子Navdeep来讲语音识别,他正在英伟达工作,怪不得N卡在深度学习中的地位如此之高。而他本人也在用Dell的搭载了N卡的XPS跑Ubuntu,一改以往“讲台必定信仰灯”的局面。 Automati...

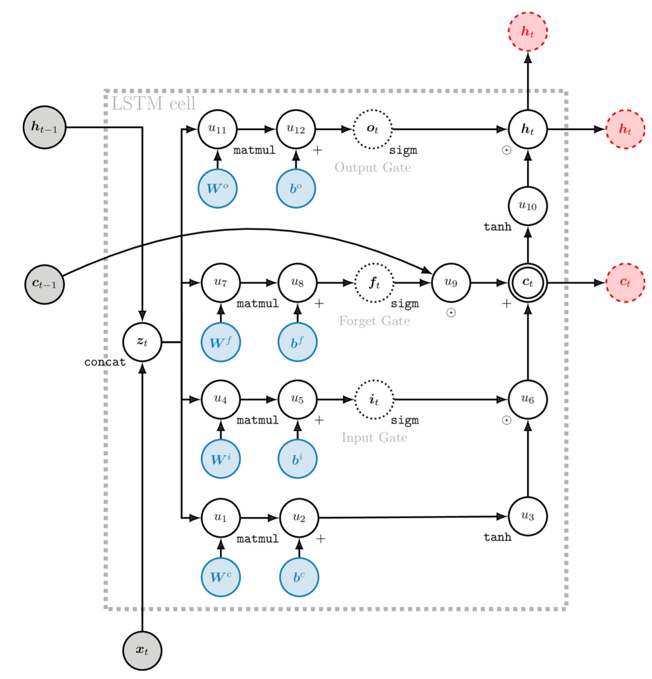

从动机层面直观地充实了GRU和LSTM的理解,介绍了MT的评测方法,讨论了NMT中棘手的大词表问题和一些常见与最新的解决办法。 深入GRU 把GRU再详细讲一讲。 RNN的梯度消失就不赘述了,红线连乘多次下溢出。 而GRU额外添...

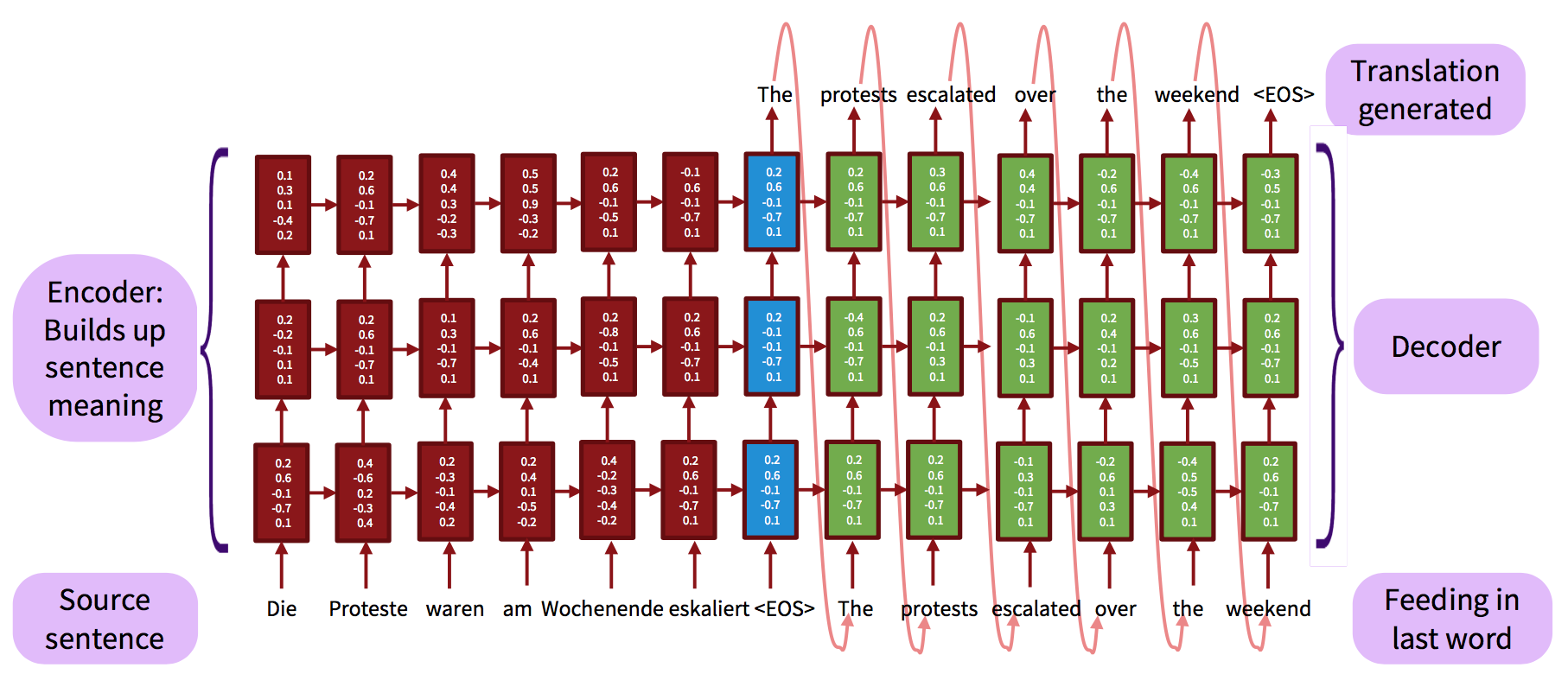

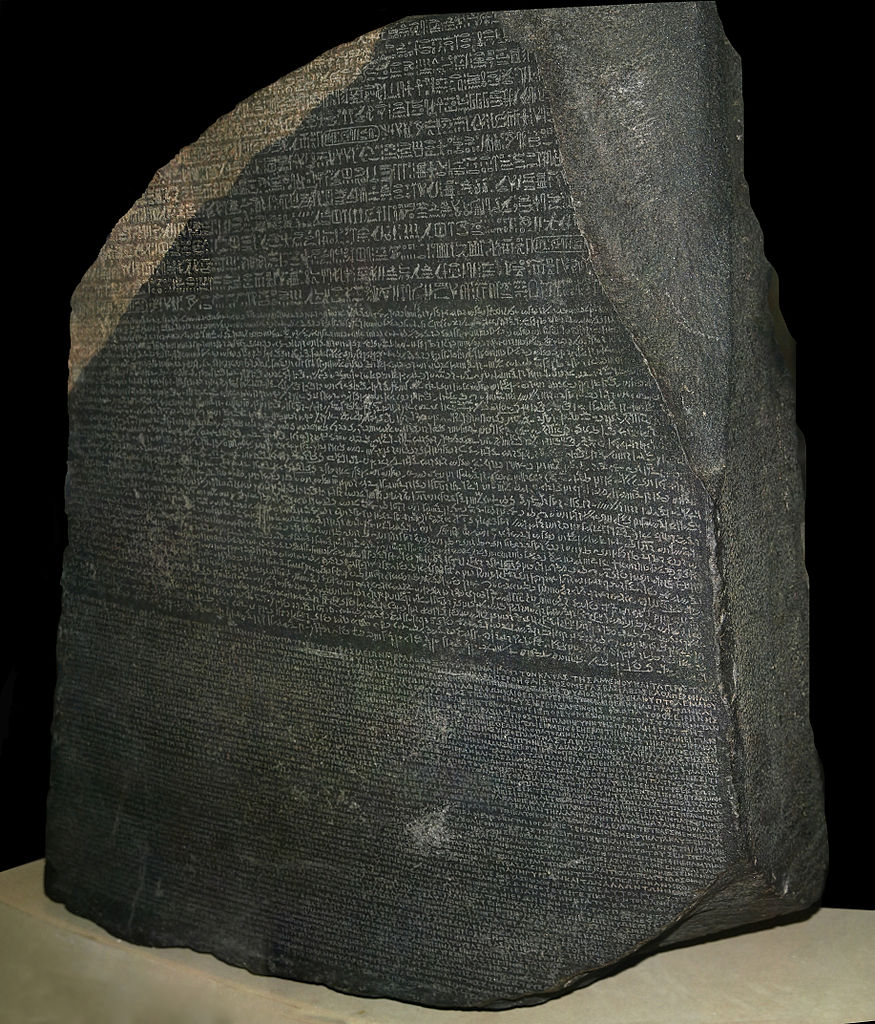

从NMT的历史谈到现代,讲解了attention机制的动机、原理及最新的拓展。通过实例展示谷歌翻译的变化,直言不讳指出其过度炒作。Manning今天还换上了新MBP,挺潮的。 机器翻译 传统衡量机器对语言理解的测试之一 同时涉及到语言分析与...

简单回顾了传统统计机器翻译中的难题,过渡到利用GRU和LSTM来救场,最后介绍了一些较新的改进工作。 机器翻译 对于情感分析这类还算简单的任务,你可以整理一个情感极性词典、编写一堆规则做出一个勉强能用的系统。但到了机器翻译这个高级应用,就无...