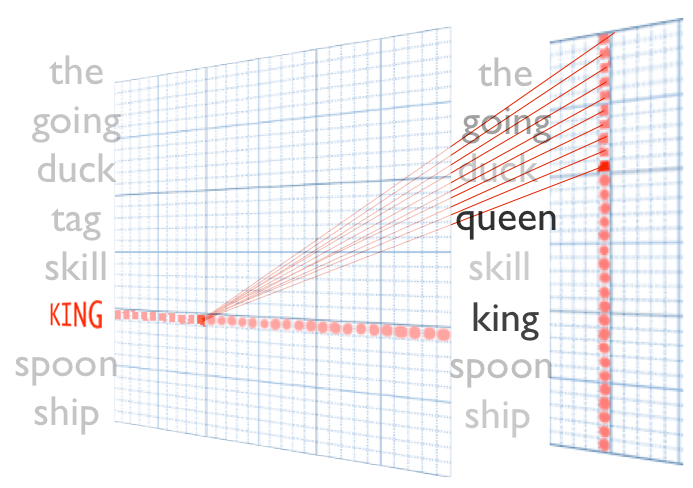

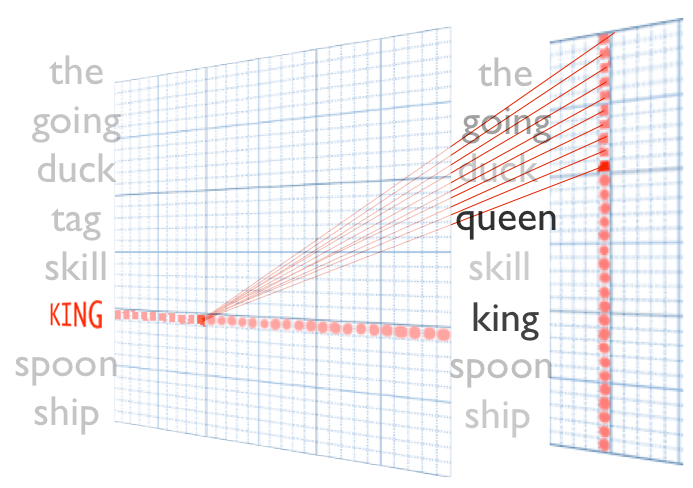

word2vec原理推导与代码分析

本文摘录整编了一些理论介绍,推导了word2vec中的数学原理;并考察了一些常见的word2vec实现,评测其准确率等性能,最后分析了word2vec原版C代码;针对没有好用的Java实现的现状,移植了原版C程序到Java。时间和水平有限,...

本文摘录整编了一些理论介绍,推导了word2vec中的数学原理;并考察了一些常见的word2vec实现,评测其准确率等性能,最后分析了word2vec原版C代码;针对没有好用的Java实现的现状,移植了原版C程序到Java。时间和水平有限,...

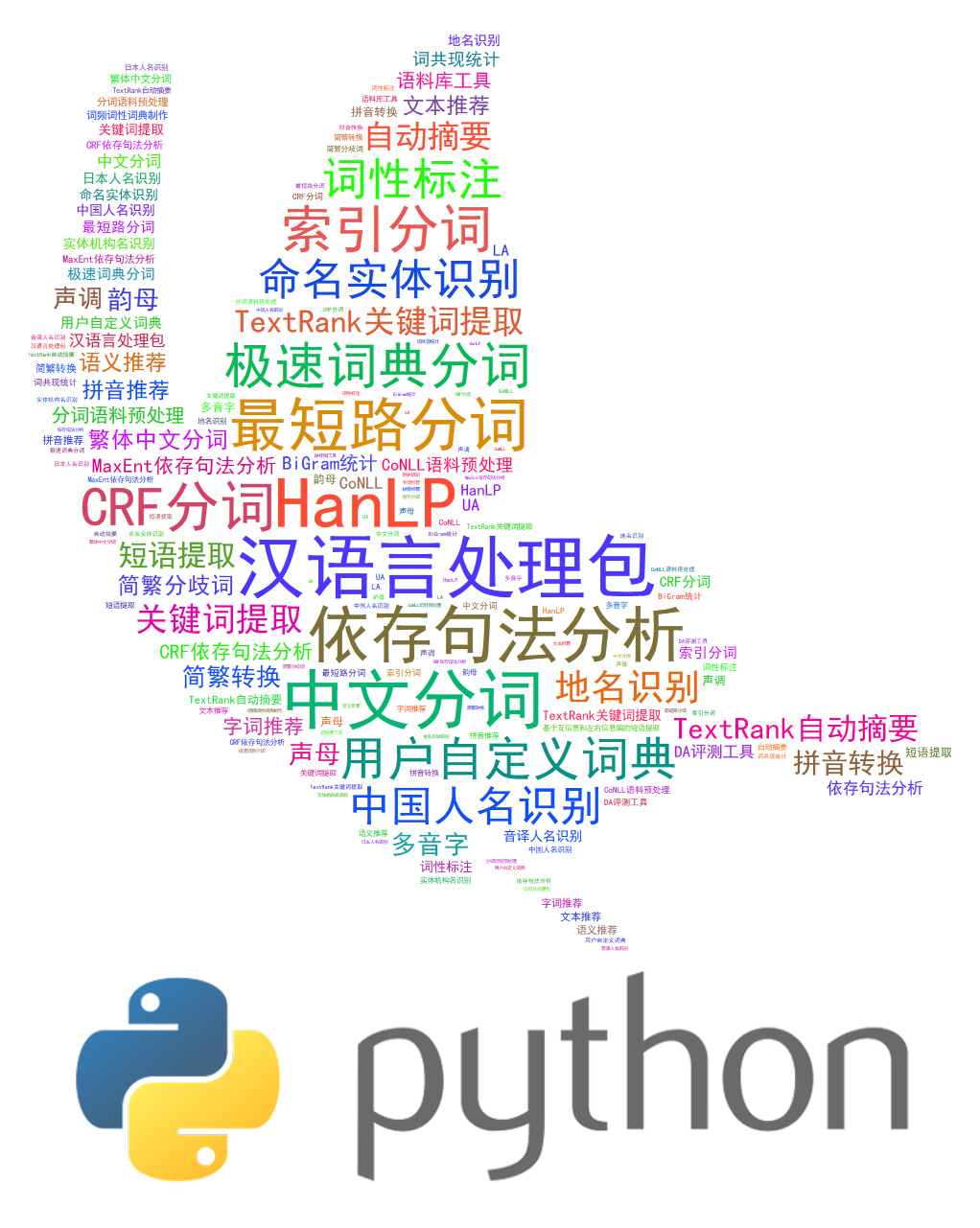

本新词发现模块已经集成到HanLP中开源。 本文是《基于互信息和左右信息熵的短语提取识别》的姊妹篇,文如其名,没什么新意。 谈起“新词识别”“新词发现”,有许多论文慷慨陈词:要设计丰富的特征模板、建立训练语料库、引入CRF、ME、SVM、神...

如果你是能力不足的小白,请直接使用傻瓜安装包。 能力达标的话,一句话安装pyhanlp,全自动下载安装配置,还支持升级。 pip install pyhanlp 调用方法参考项目主页:https://github.com...

今天有用户想在CSharp里调用HanLP的API,遇到了些小问题。所以我干脆自己写了个指南,一步步演示IKVM与HanLP的集成方法,供广大C#程序员参考。本方法也可推广到用C#调用任何Java jar类库,并解决classpath的问题...

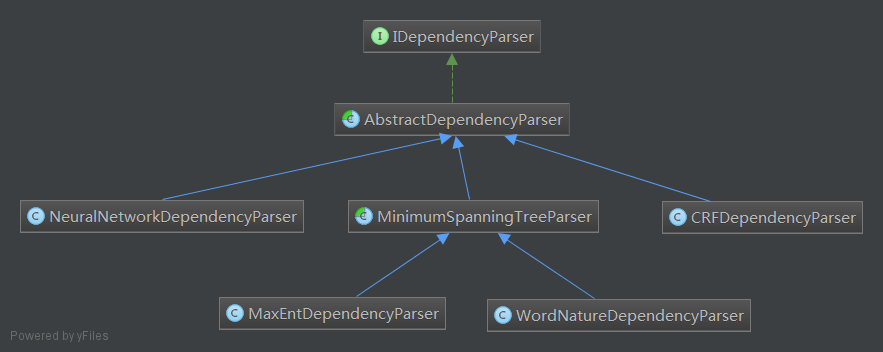

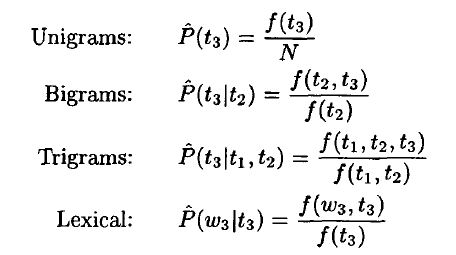

本文剖析了一个基于神经网络分类模型和arc-standard转移动作的判决式汉语依存句法分析器,其Java实现由我移植自LTP的C++代码,并添加了详细的注释,将内部数据结构由哈希表替换为高速的DoubleArrayTrie,分词和词性标注...

以前发布过HanLP的Lucene插件,后来很多人跟我说其实Solr更流行(反正我是觉得既然Solr是Lucene的子项目,那么稍微改改配置就能支持Solr),于是就抽空做了个Solr插件出来,开源在Github上,欢迎改进。 HanLP中...

谈起基于Character-Based Generative Model的中文分词方法,普遍的印象是在Bakeoff上的成绩好,对OOV的识别率高。HanLP中实现的CRF分词器其实就是这种原理的分词器,然而CRF分词缺点也是很明显的: 一...

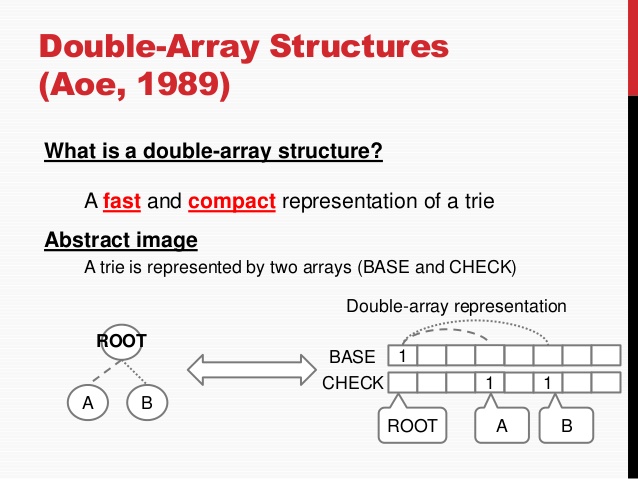

前段时间开源了基于双数组Trie树的Aho Corasick自动机,当时认为在中文分词中,ACDAT应该能秒杀DAT。今天优化了DAT的多模式匹配后,竟然得出了意外的结果。 当初的DAT实现中,为了支持多模式匹配,我写了一个Searcher...

中文分词≠自然语言处理! 中文分词只是第一步;HanLP从中文分词开始,覆盖词性标注、命名实体识别、句法分析、文本分类等常用任务,提供了丰富的API。 不同于一些简陋的分词类库,HanLP精心优化了内部数据结构和IO接口,做到了毫秒级的冷启...

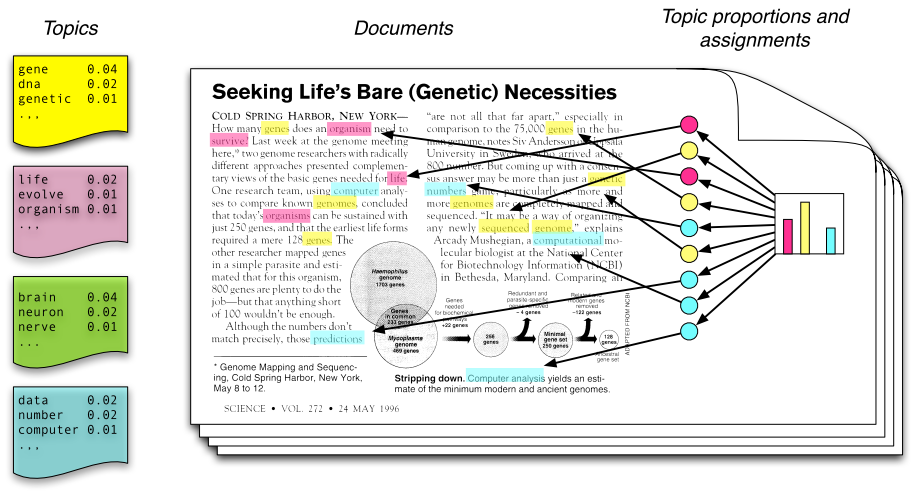

这是一篇面向工程师的LDA入门笔记,并且提供一份开箱即用Java实现。本文只记录基本概念与原理,并不涉及公式推导。文中的LDA实现核心部分采用了arbylon的LdaGibbsSampler并力所能及地注解了,在搜狗分类语料库上测试良好,开...