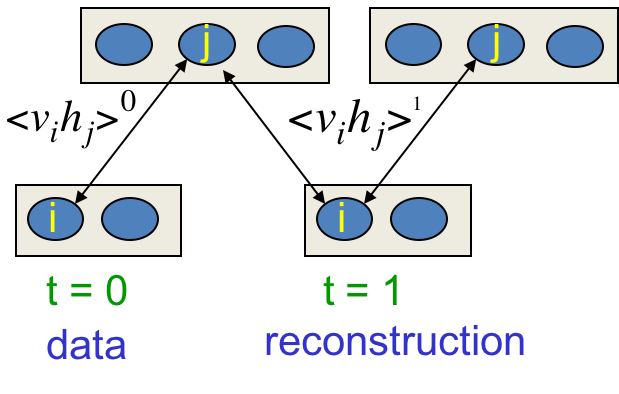

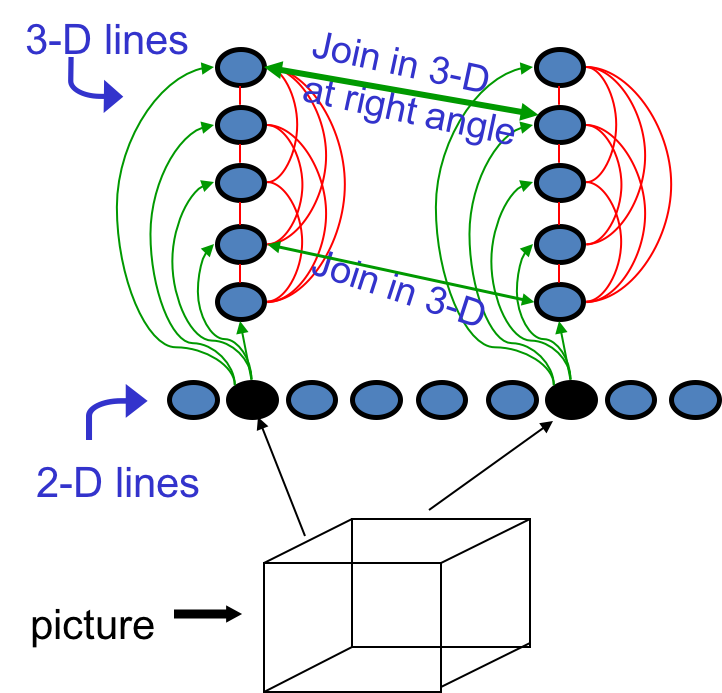

Hinton神经网络公开课13 Stacking RBMs to make Deep Belief Nets

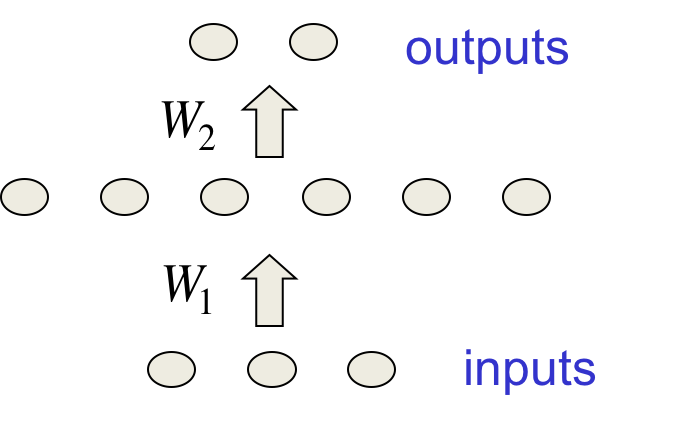

这次课比较轻松,先回顾反向传播的历史,探讨其在90年代遭到冷落的原因。然后过渡到概率图模型,讲了Deep Belief Net及其与RBM的异同、训练算法等。 反向传播简史 这个著名的算法在70和80年代被重复发明多次: Bryson &a...

这次课比较轻松,先回顾反向传播的历史,探讨其在90年代遭到冷落的原因。然后过渡到概率图模型,讲了Deep Belief Net及其与RBM的异同、训练算法等。 反向传播简史 这个著名的算法在70和80年代被重复发明多次: Bryson &a...

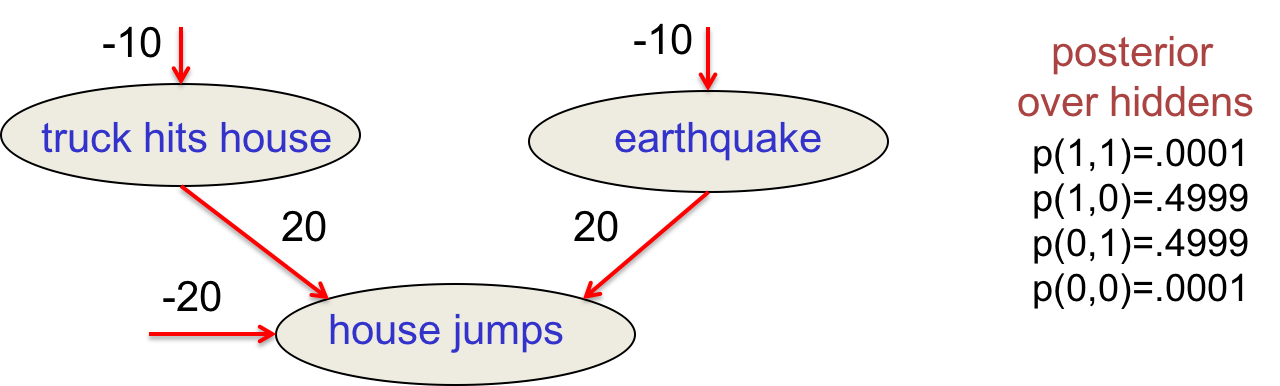

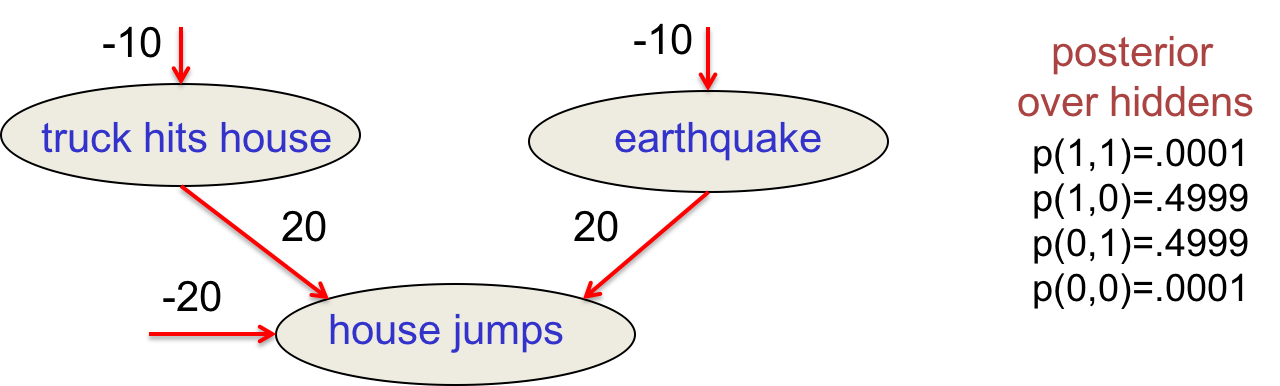

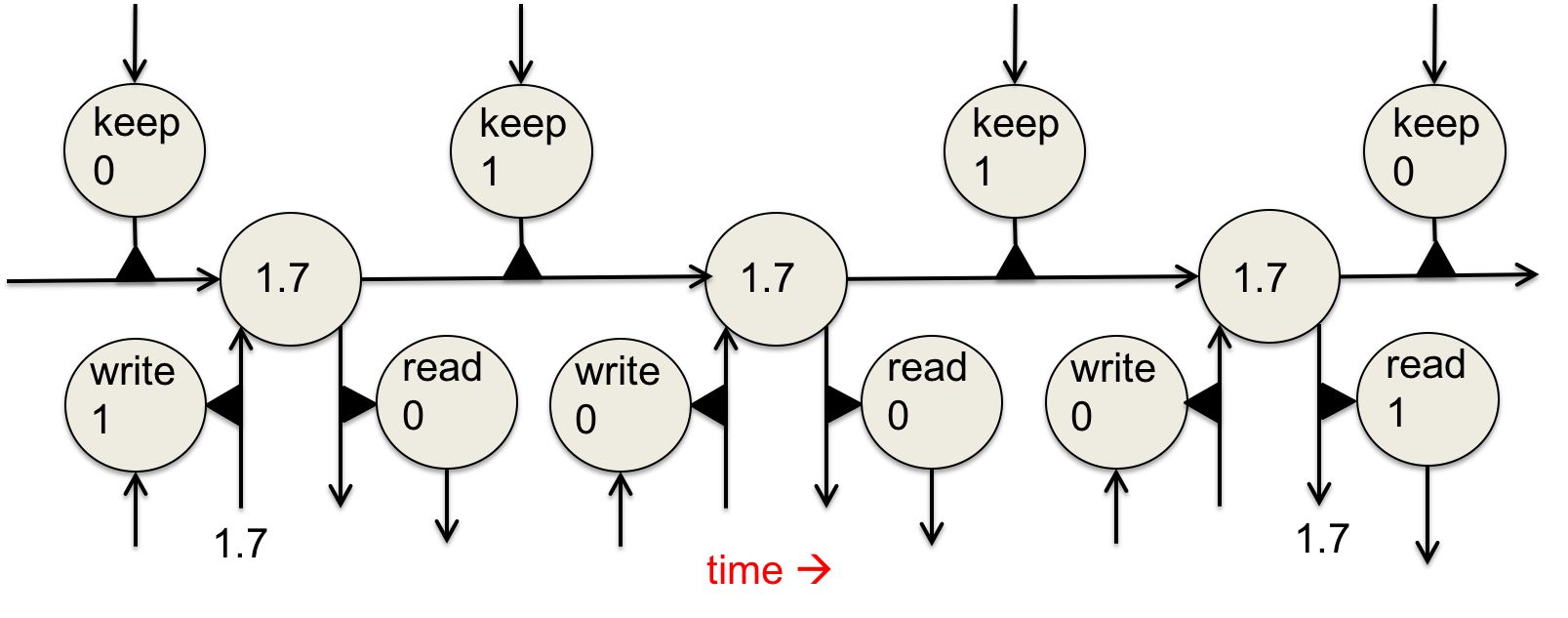

终于到了玻尔兹曼机的训练了,这种简单的模型拥有优雅的理论基础,训练起来却又慢又差,曾一度被认为不实用。这节课讲解几种高效的学习算法,以及RBM应用到协同过滤的例子。 学习目标 这是种无监督学习,只有输入向量的参与。我们想要最大化训练集中的二...

这节课介绍Hopfield Nets,这是80年代神经网络复兴的主要原因之一。这种简单优美的模型将记忆储存为激活值中的模式。然后介绍带有随机隐藏单元的Stochastic Hopfield nets(即玻尔兹曼机),及其搜索算法,为下节课的...

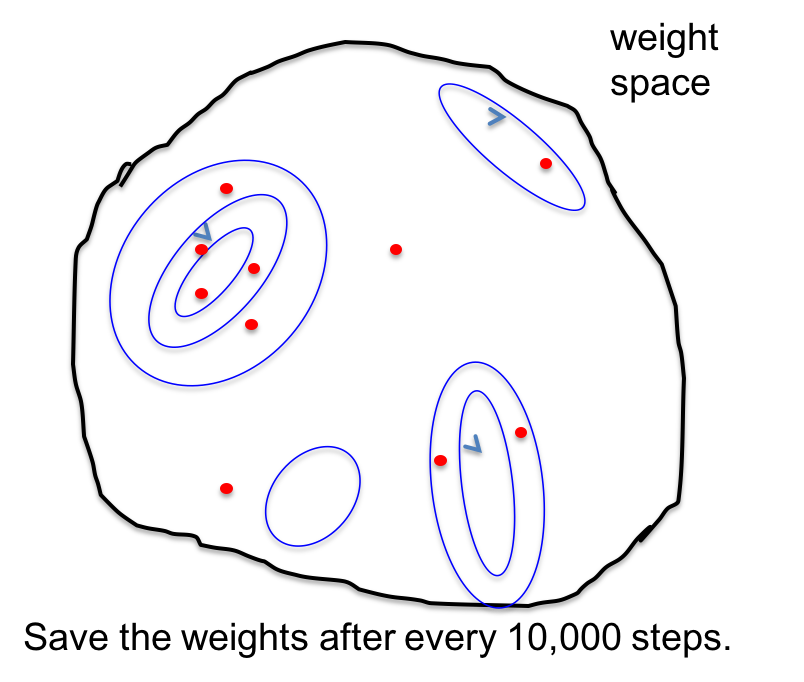

这节课讲了为什么要综合多个模型,好处与原理、具体做法等。讲解了贝叶斯学习中的神经网络模型混合、马尔科夫蒙特卡洛方法,以及从新角度阐释更高效的Dropout。 综合网络:偏置方差均衡 训练数据少,容易过拟合。综合多个模型可以防止过拟合,特别是...

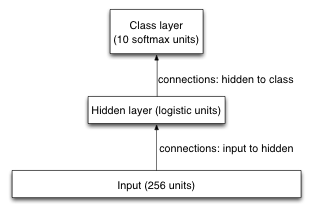

这次练习在USPS手写邮政编码数据集上训练识别模型,重点是训练神经网络时的各种调参技巧。 数据集 数据全集有11000张图片,其中1000作为训练集,1000作为验证集,9000作为测试集(训练集与测试集的比例不同寻常,很容易过拟合,富有挑...

这节课介绍防止模型过拟合的各种方法,给出了正则化项、惩罚因子的贝叶斯解读;并展示了基于贝叶斯解读的一种实践有效的惩罚因子调参方法。 复习:过拟合 训练数据中不光有正确的规律,而且还有偶然的规律(采样误差,只取决于训练实例的选择)。拟合模型的...

首先简要介绍Hessian-Free优化理论。这是块硬骨头,并不要求一定掌握。 在给定方向上的移动能够将误差降低多少 在训练神经网络的时候,我们想要在error surface上尽量多地下降。梯度有了之后,具体能够迈多大一步呢?以二次曲线为...

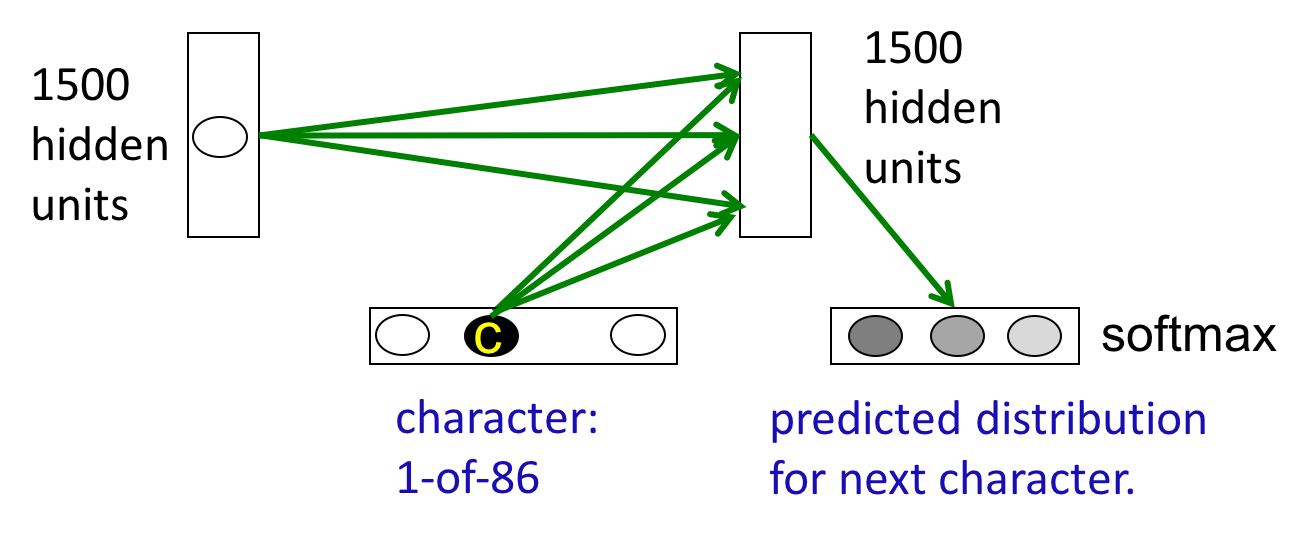

首先复习一下常见序列模型,包括BiGram、linear dynamic system和HMM。通过对简单模型的比较学习,加深对RNN的理解。 为序列建模 目的是将一个输入序列转化为一个输出序列,如机器翻译、语音识别。 当不区分输入和输出序...