CS224n笔记2 词的向量表示:word2vec

如何表示一个词语的意思 先来看看如何定义“意思”的意思,英文中meaning代表人或文字想要表达的idea。这是个递归的定义,估计查询idea词典会用meaning去解释它。 中文中“意思”的意思更加有意思: 他说:“她这个人真有意思(fu...

如何表示一个词语的意思 先来看看如何定义“意思”的意思,英文中meaning代表人或文字想要表达的idea。这是个递归的定义,估计查询idea词典会用meaning去解释它。 中文中“意思”的意思更加有意思: 他说:“她这个人真有意思(fu...

这门课会不定期地让TA介绍一些课程相关的最前沿研究,与课程进度并非流畅衔接,所以单独做笔记。这次是第二节课中场休息时,由Danqi Chen带来的五分钟小讲座: 句子Embedding动机 虽然这节课一直在讲词向量可以编码词的意思,但自然语...

这是斯坦福CS224n的第一篇笔记,也是第一次系统地学习用深度学习来做自然语言处理。本文还整理了CS224n的全部视频课件笔记,汇总下载。 虽然深度学习已经席卷各大应用领域,大量开源工具让谁都能跳过理论基础速成demo专家。我却一直按部就班...

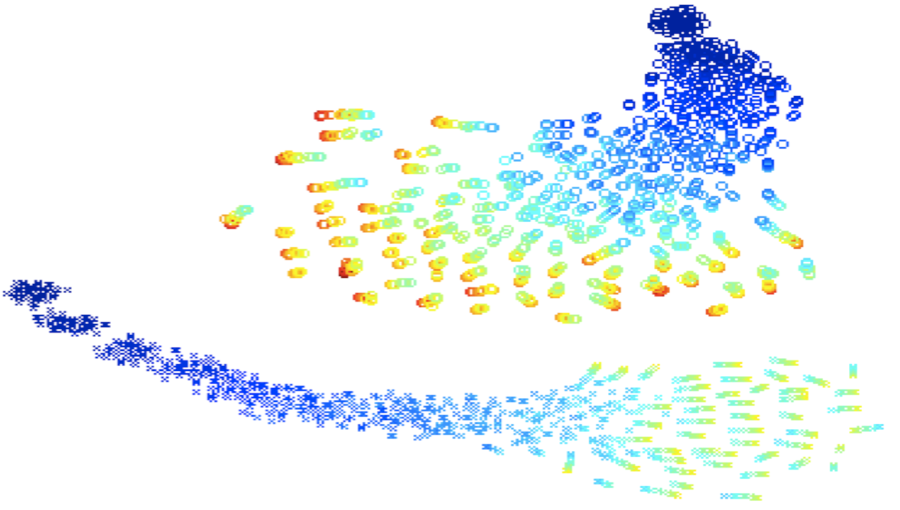

Neural Networks for Machine Learning最后一课。 学习图像和标题的联合模型 这节课介绍最近一种利用图片标题和图片像素的特征向量训练联合模型的技术。这两种输入之间应当有联系,并将辅助图片检索。末尾展示一段输入...

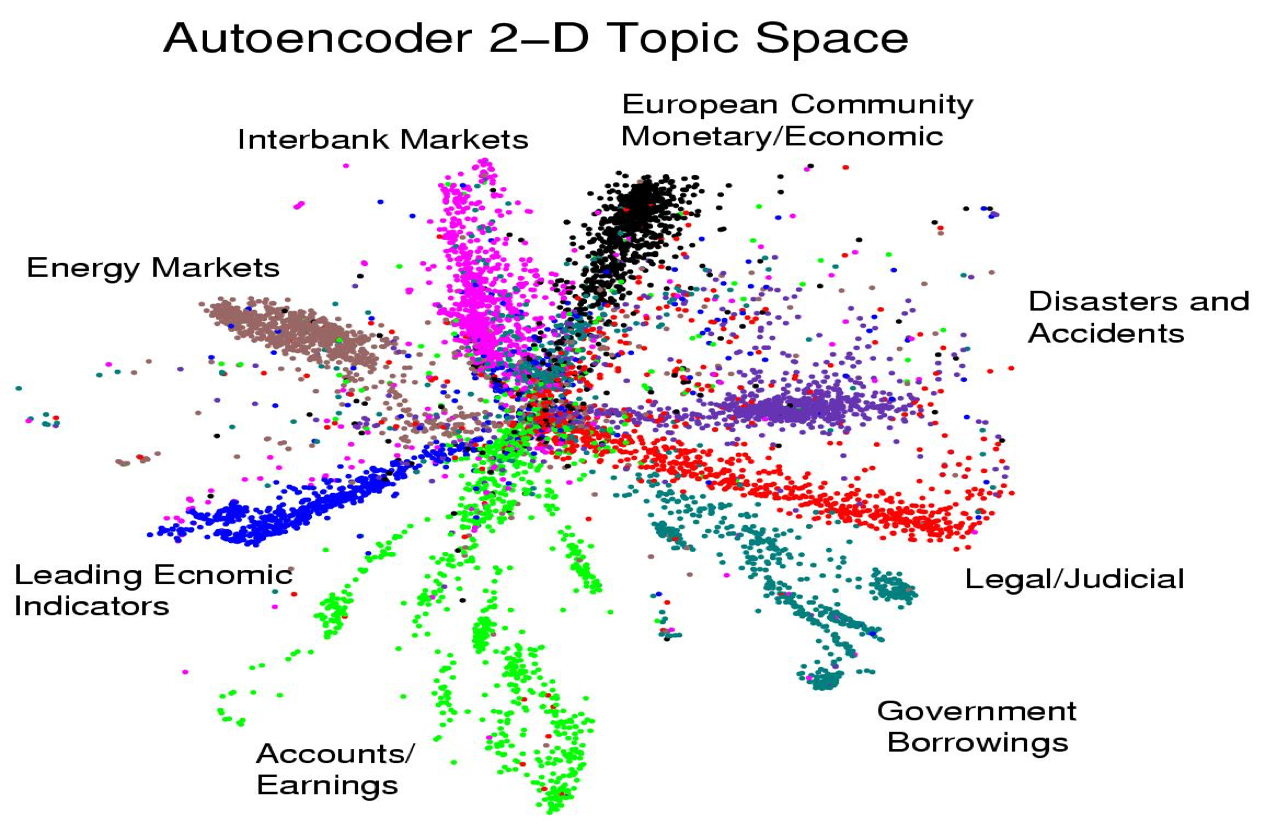

虽然是倒数第二课,但只要前面的认真听了,这节课就会觉得相当简单。 从主成分分析到自动编码器 先复习一下PCA,这是一种找出高维数据附近的linear manifold,用这上面的映射来表示数据本身的方法。linear manifold定义如...

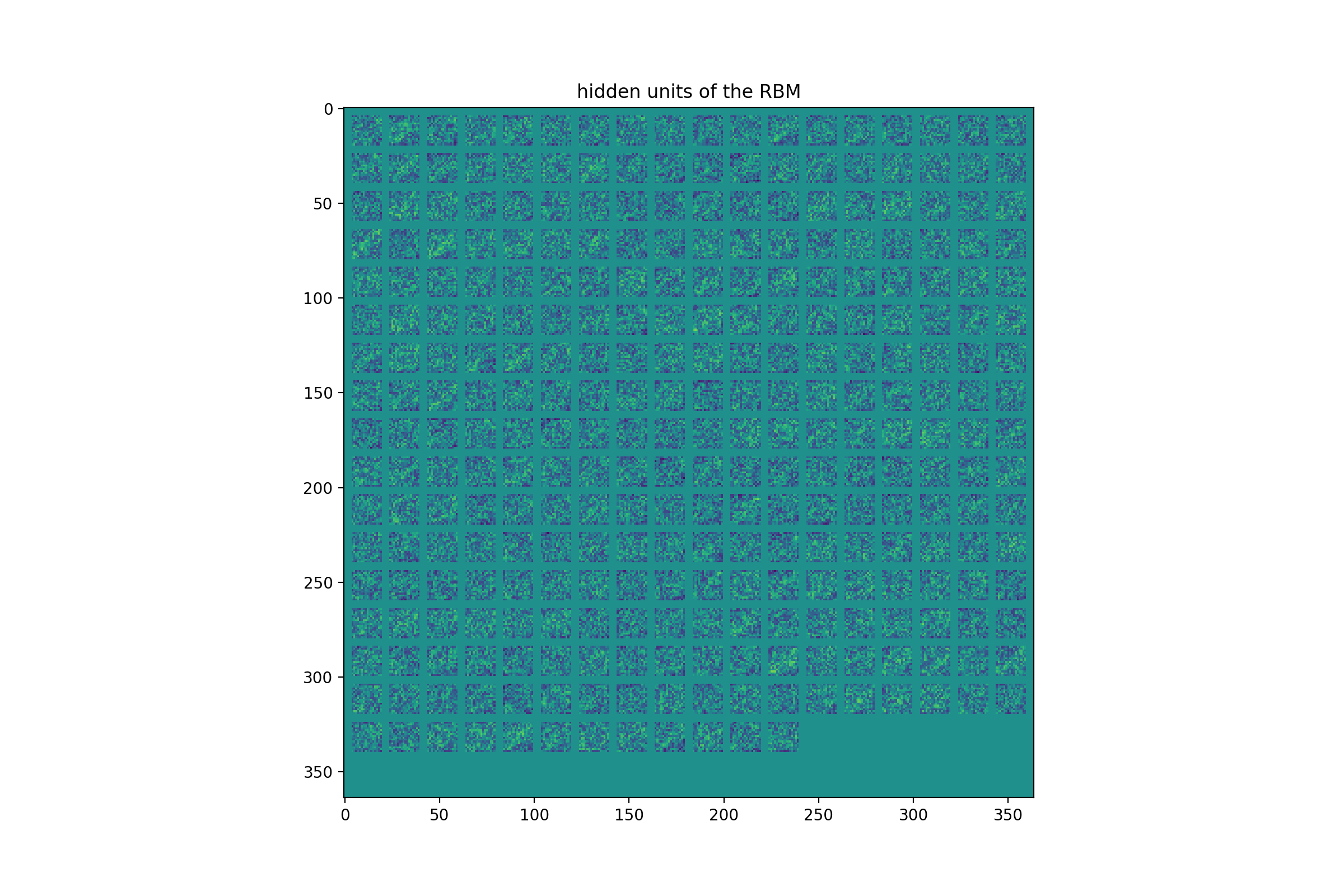

最后一次练习先实现RBM的CD1训练,然后将其作为前馈网络预训练的最底层用于识别USPS手写数字。所有代码开源在:https://github.com/hankcs/coursera-neural-net 。 编程之前 有些约定需...

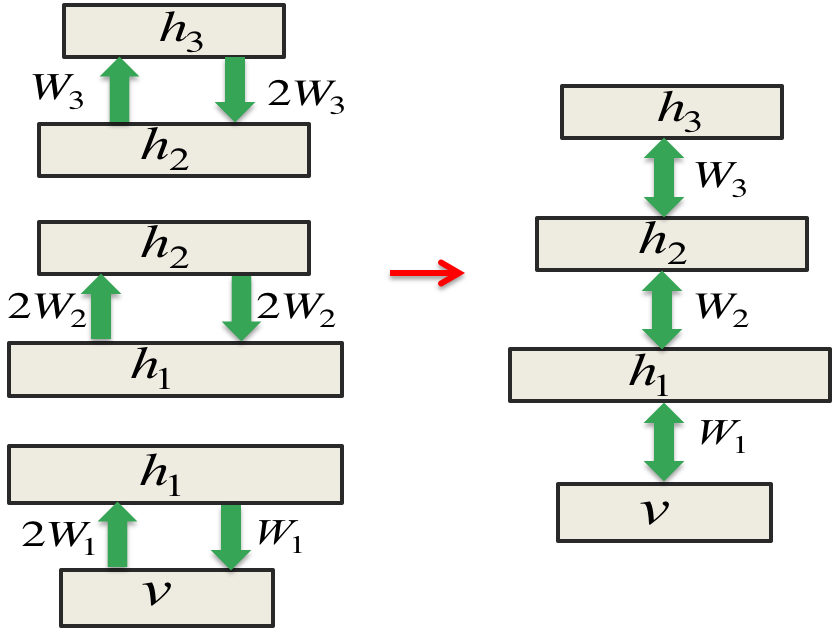

这节课介绍另一种训练sigmoid belief net的方法,这种方法的发明可谓无心插柳。Hinton放弃了sigmoid belief net之后又回到了玻尔兹曼机的研究,发现RBM的训练很高效。RBM可以学习一层非线性的特征,如果层叠...

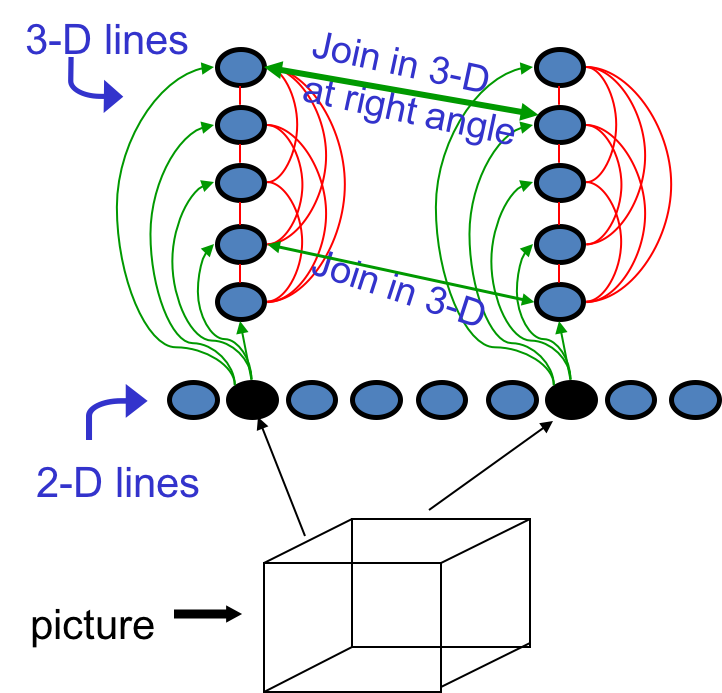

这次课比较轻松,先回顾反向传播的历史,探讨其在90年代遭到冷落的原因。然后过渡到概率图模型,讲了Deep Belief Net及其与RBM的异同、训练算法等。 反向传播简史 这个著名的算法在70和80年代被重复发明多次: Bryson &a...

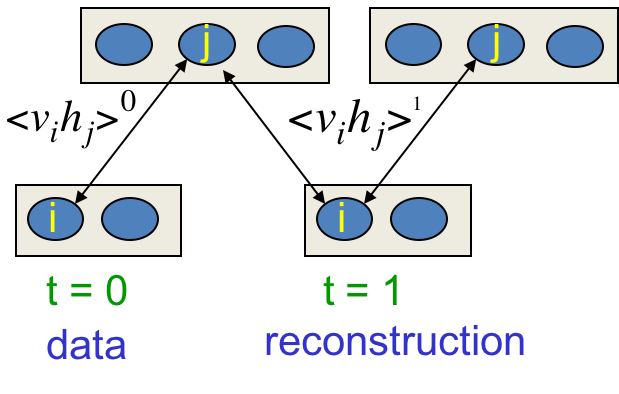

终于到了玻尔兹曼机的训练了,这种简单的模型拥有优雅的理论基础,训练起来却又慢又差,曾一度被认为不实用。这节课讲解几种高效的学习算法,以及RBM应用到协同过滤的例子。 学习目标 这是种无监督学习,只有输入向量的参与。我们想要最大化训练集中的二...

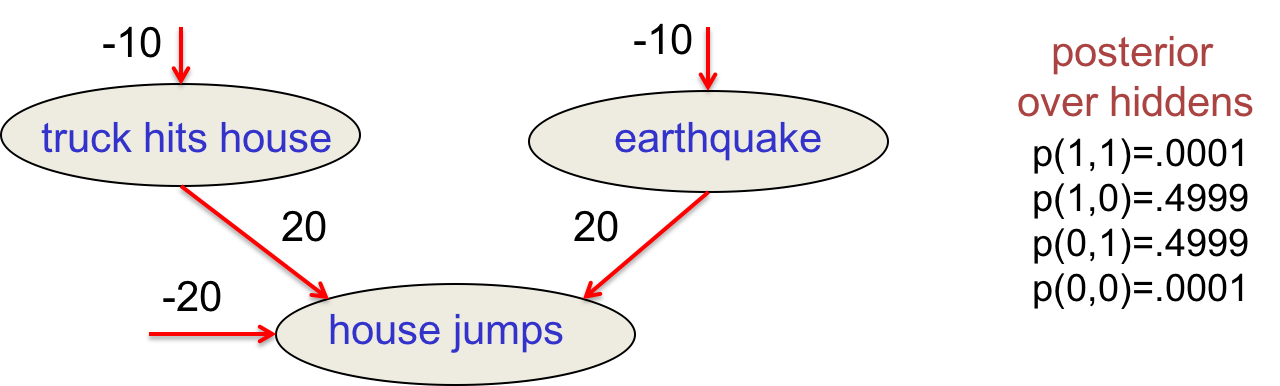

这节课介绍Hopfield Nets,这是80年代神经网络复兴的主要原因之一。这种简单优美的模型将记忆储存为激活值中的模式。然后介绍带有随机隐藏单元的Stochastic Hopfield nets(即玻尔兹曼机),及其搜索算法,为下节课的...