谷歌深度学习公开课任务 2: SGD

三言两语讲完了反向传播,一个公式也没有,果然是面向“懒惰工程师”的快餐教程。比较喜欢“不提神经元,我们不是巫婆”的观点。这次不需要自己写算法,直接上TensorFlow了。 任务 2: 随机梯度下降 使用梯度下降和随机梯度下降训练一个全连接...

三言两语讲完了反向传播,一个公式也没有,果然是面向“懒惰工程师”的快餐教程。比较喜欢“不提神经元,我们不是巫婆”的观点。这次不需要自己写算法,直接上TensorFlow了。 任务 2: 随机梯度下降 使用梯度下降和随机梯度下降训练一个全连接...

这是谷歌在优达学城上开的公开课,感觉就是TensorFlow的宣传片。肉眼观测难度较低,作为入门第一课快速过掉也许还行。课程概述中说: 我们将教授你如何训练和优化基本神经网络、卷积神经网络和长短期记忆网络。你将通过项目和任务接触完整的机器学...

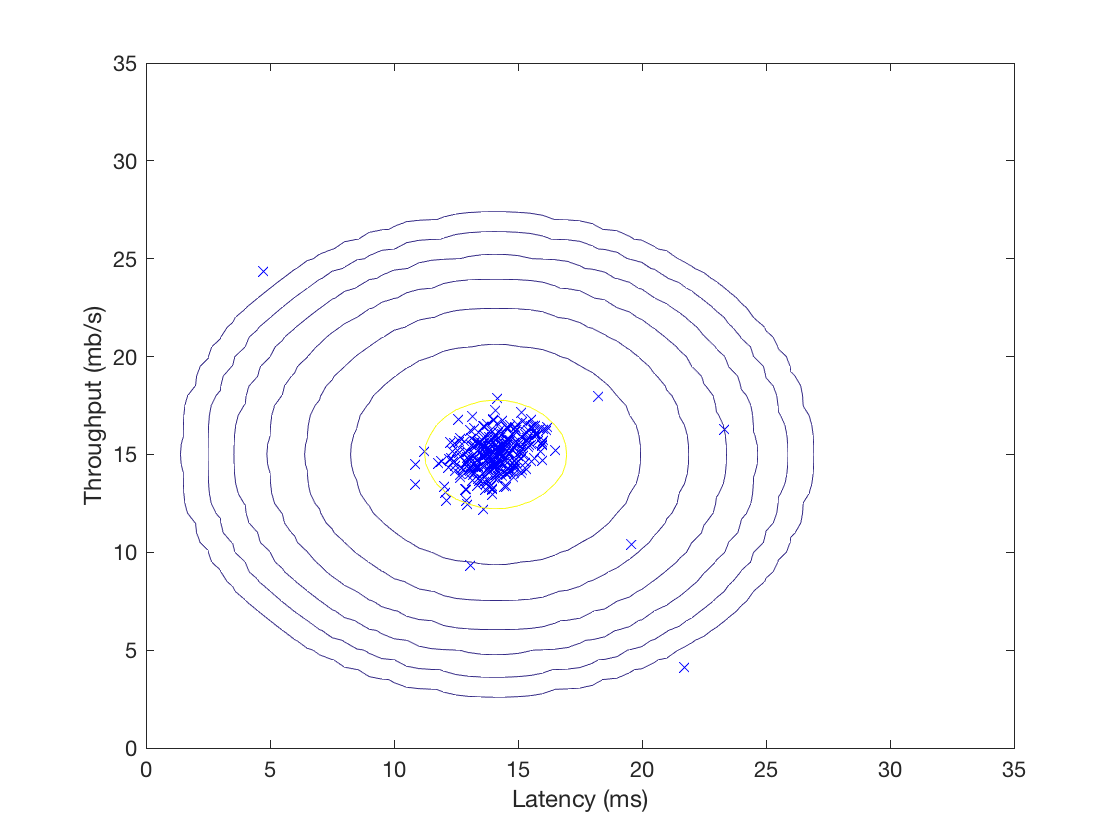

斯坦福ML(Matlab)公开课最后一次编程练习,实现了异常检测算法并应用于服务器异常检测,然后利用协同过滤实现一个电影推荐系统。至此又填完一个坑,matlab感觉也入门了。 异常检测 你收集了一些服务器的流量与延迟数据,假设大部分服务器都...

斯坦福ML(Matlab)公开课,这次练习先实现K-means聚类算法并应用于图像压缩,然后实现PCA并用于人脸图像,最后展示高维数据的可视化技巧。我发现matlab做动画特别方便,顺手把算法执行过程动画化了。 K-means聚类 循序渐进...

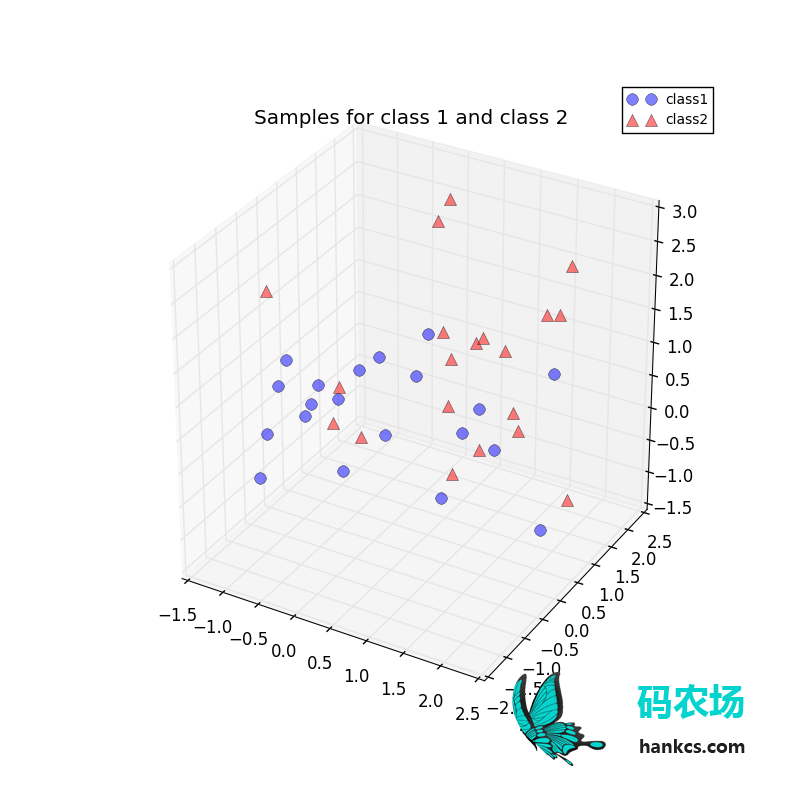

译自《Implementing a Principal Component Analysis (PCA)– in Python, step by step》,一步步地实现了PCA,验证了散布矩阵和协方差矩阵可以得到同样的子空间,并友好地可视...

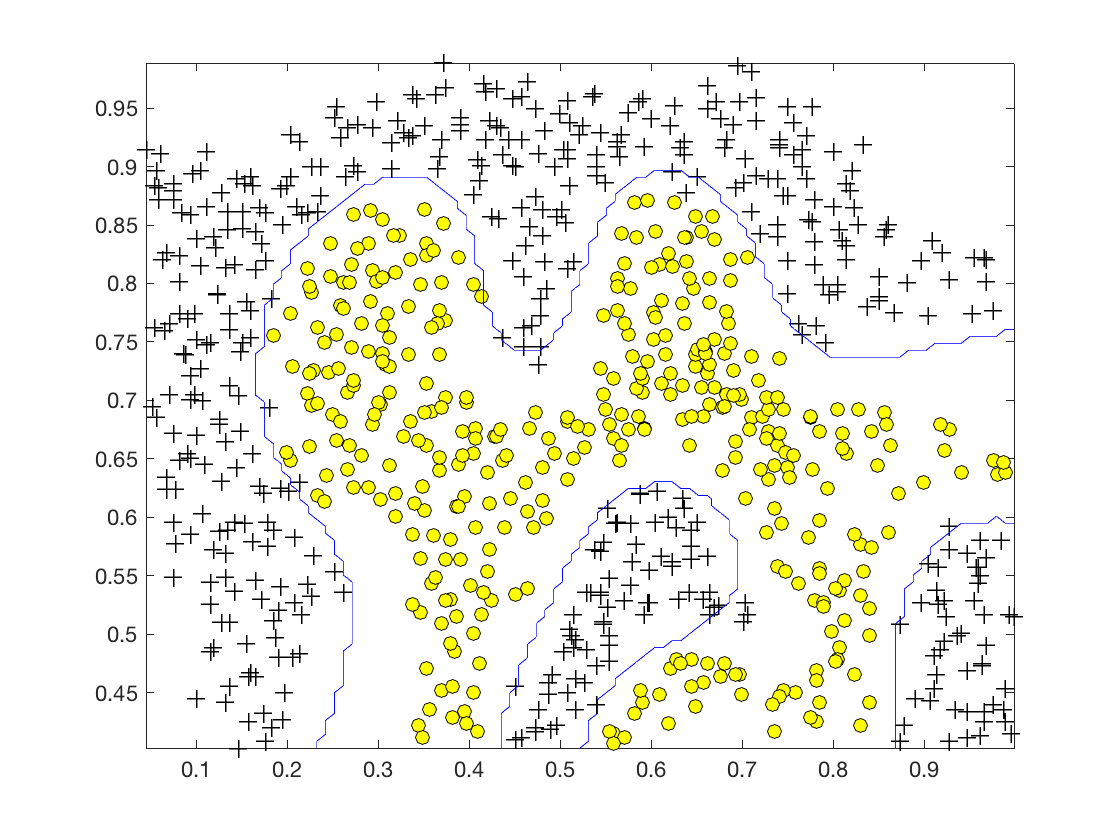

斯坦福ML(Matlab)公开课,本次练习试验支持向量机,并应用于垃圾邮件分类。代码本身非常简单,理论知识参考《统计学习方法》或公开课视频。 支持向量机 这部分先在多个2D数据集上熟悉熟悉SVM和惩罚参数。 线性可分数据 简单的线性可分数据...

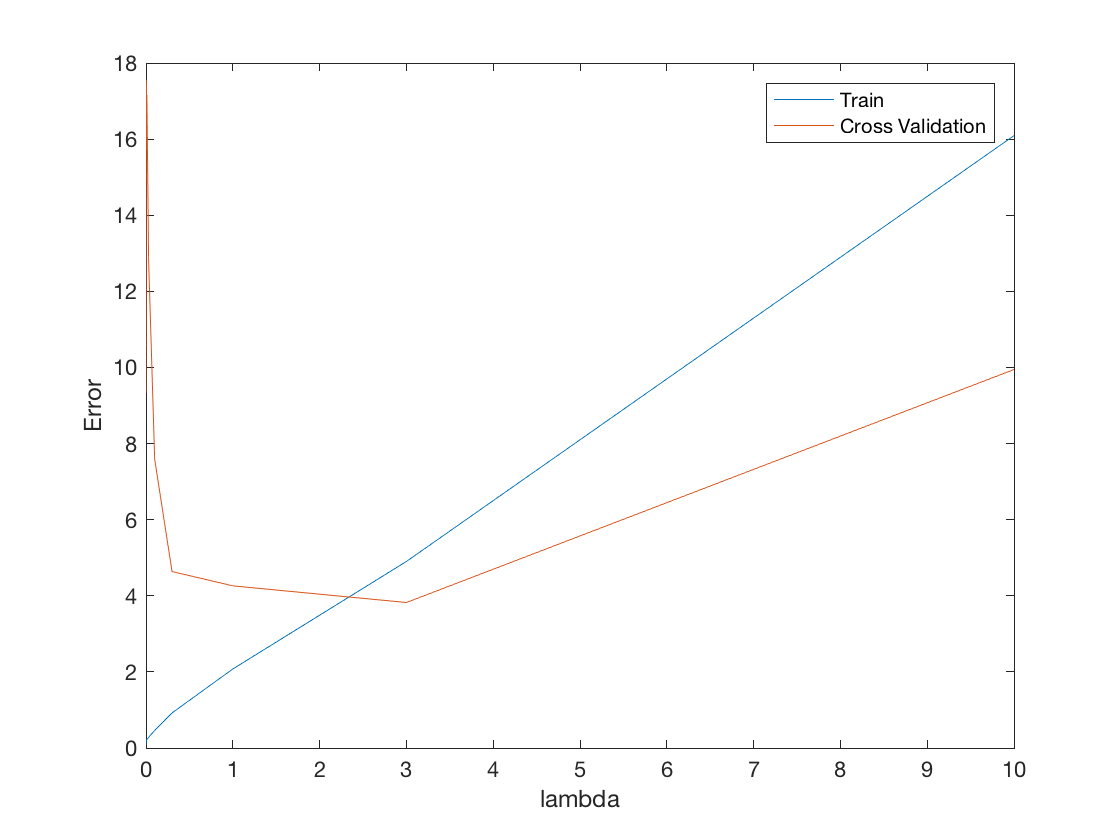

斯坦福ML(Matlab)公开课,本次练习将实现正则化线性回归、多项式回归,并且在不同的参数下拟合数据、绘制学习曲线。 正则化线性回归 利用水库水位预测流量。 可视化数据集 数据集被拆分为3部分: 训练集 交叉验证集,用来决定正则化参数 测...

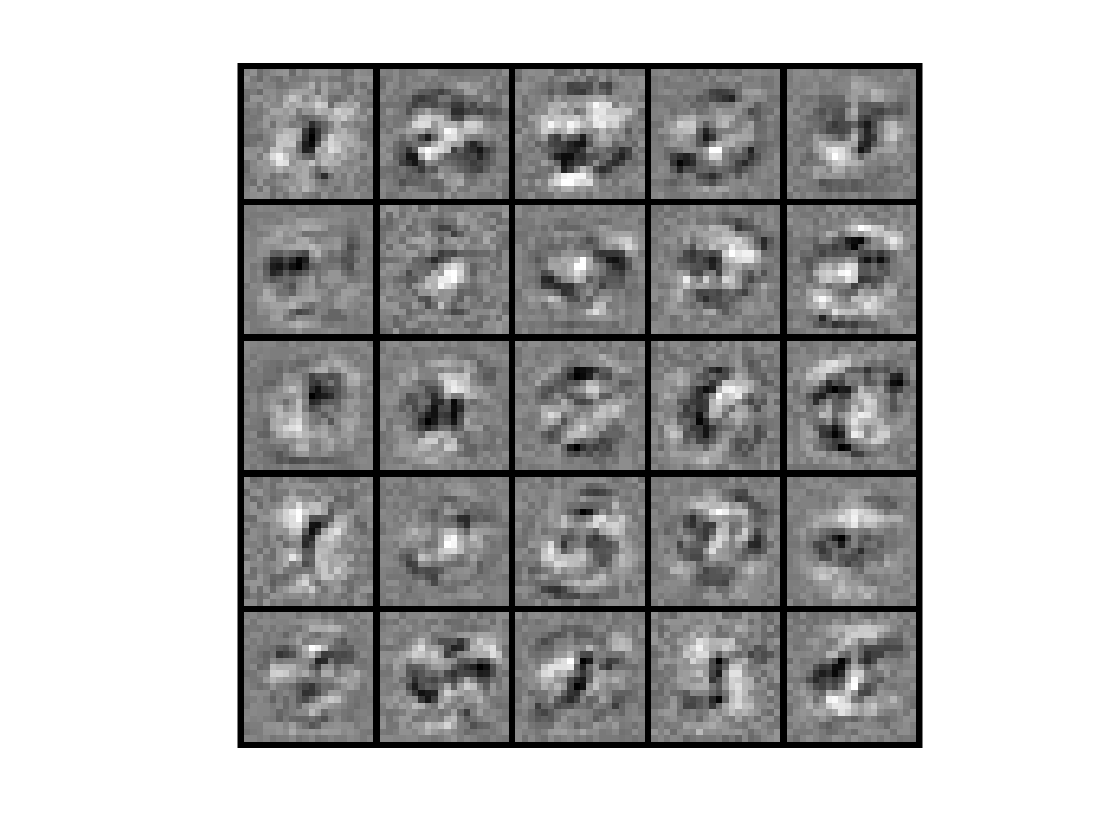

斯坦福ML(Matlab)公开课,实现上次遗留的反向传播算法,并应用于手写数字识别,这次的看点是隐藏层的可视化,以及随机初始化参数的一些讲究。 简介 神经网络 上次实现了前向传播,但模型参数是别人给的。这次实现学习参数反向传播算法。 前向传...

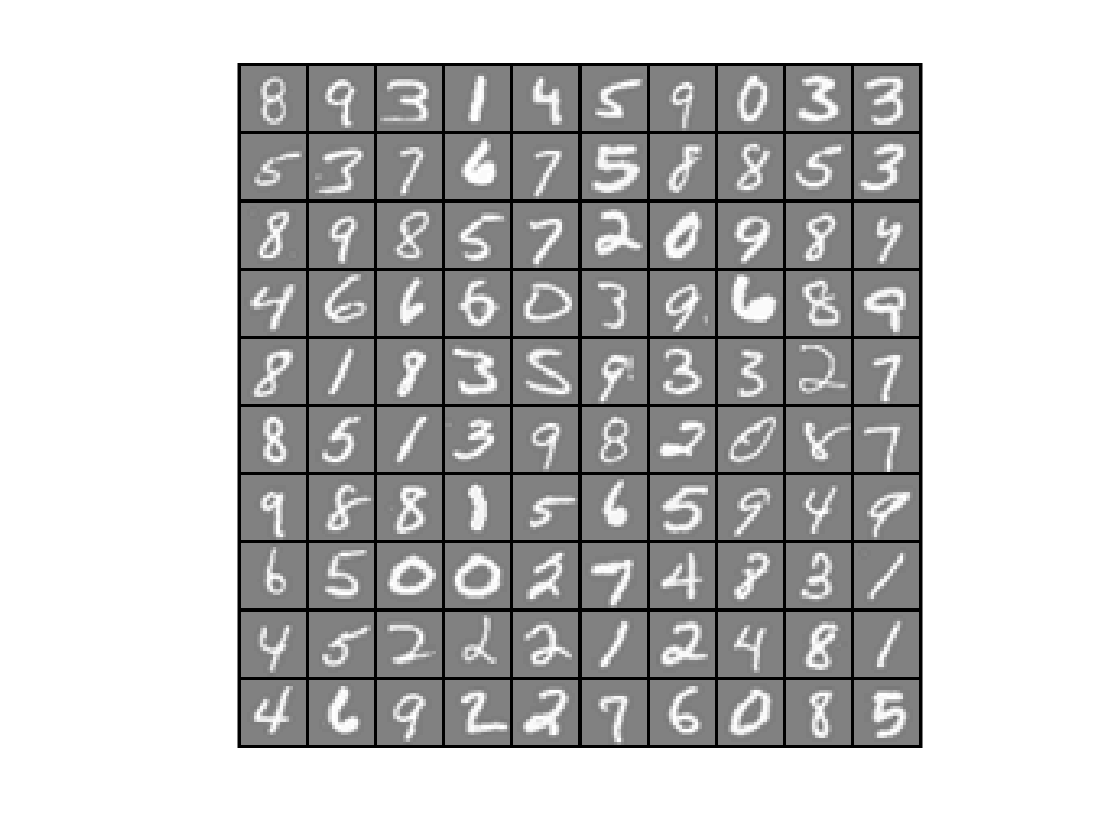

斯坦福ML(Matlab)公开课,这次主题是一些图像处理的基础知识。 简介 分别实现one-vs-all逻辑斯谛回归和神经网络,用来识别手写数字。其中逻辑斯谛回归是在上次练习的基础上拓展到多分类,神经网络不要求实现训练,仅要求实现前向传播然...

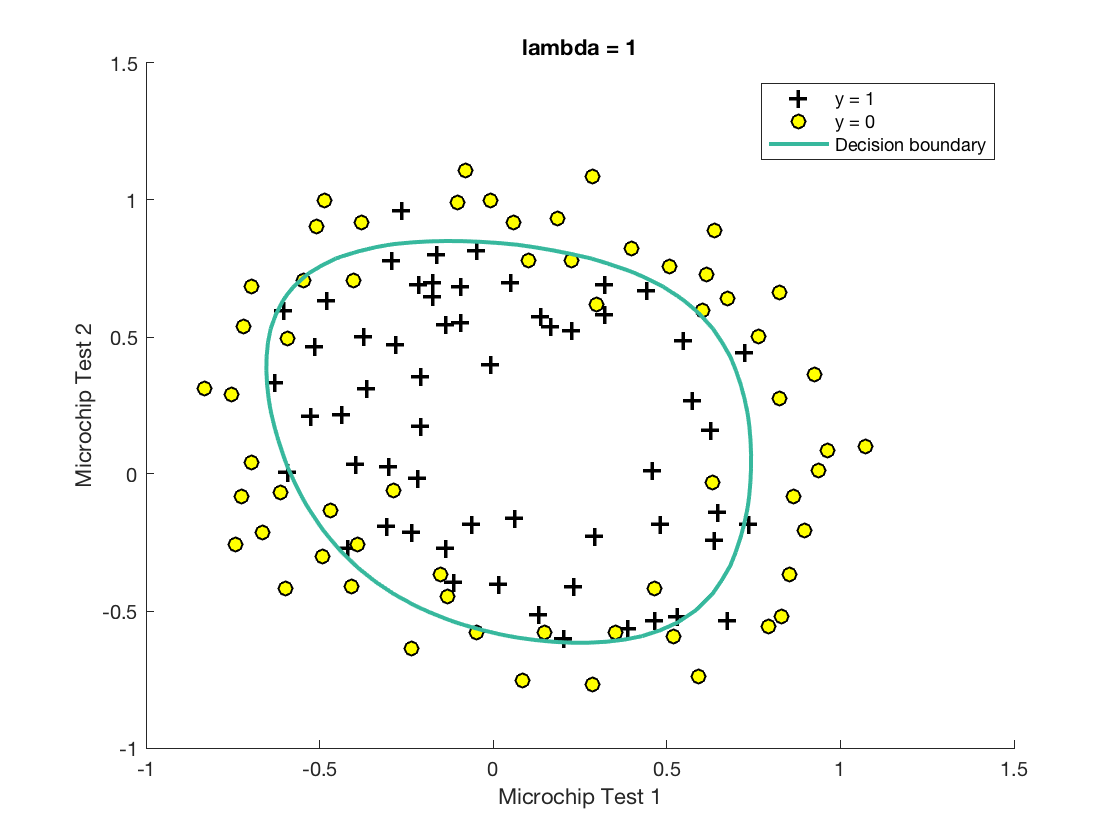

斯坦福cs229 MATLAB公开课,简称ML公开课。这是第二次编程练习,本次重点是无约束非线性规划函数fminunc的用法,以及一些作图的技巧。 简介 实现逻辑斯谛回归,并应用到给定的两个数据集上。 逻辑斯谛回归 ...