Hinton神经网络公开课5 Object recognition with neural nets

这节课蜻蜓点水地讲了图像识别和卷积神经网络,老爷子讲得实在很简略。所以这节课不能当作CNN的入门资料,如果感觉任何地方不清楚,不要沮丧,因为根本没讲。 图像识别的难处 为什么最新的技术只能做到十几二十几的error rate呢,因为图像识别...

这节课蜻蜓点水地讲了图像识别和卷积神经网络,老爷子讲得实在很简略。所以这节课不能当作CNN的入门资料,如果感觉任何地方不清楚,不要沮丧,因为根本没讲。 图像识别的难处 为什么最新的技术只能做到十几二十几的error rate呢,因为图像识别...

这次练习的任务是设计一个神经网络语言模型,给定前三个词语,预测第四个词语。通过训练该语言模型学习词的稠密表示,大部分代码已经写好,少量难点以选择题的方式给出。 数据集 词表大小250,训练集由30万个4-gram构成,开发集和测试集大小为5...

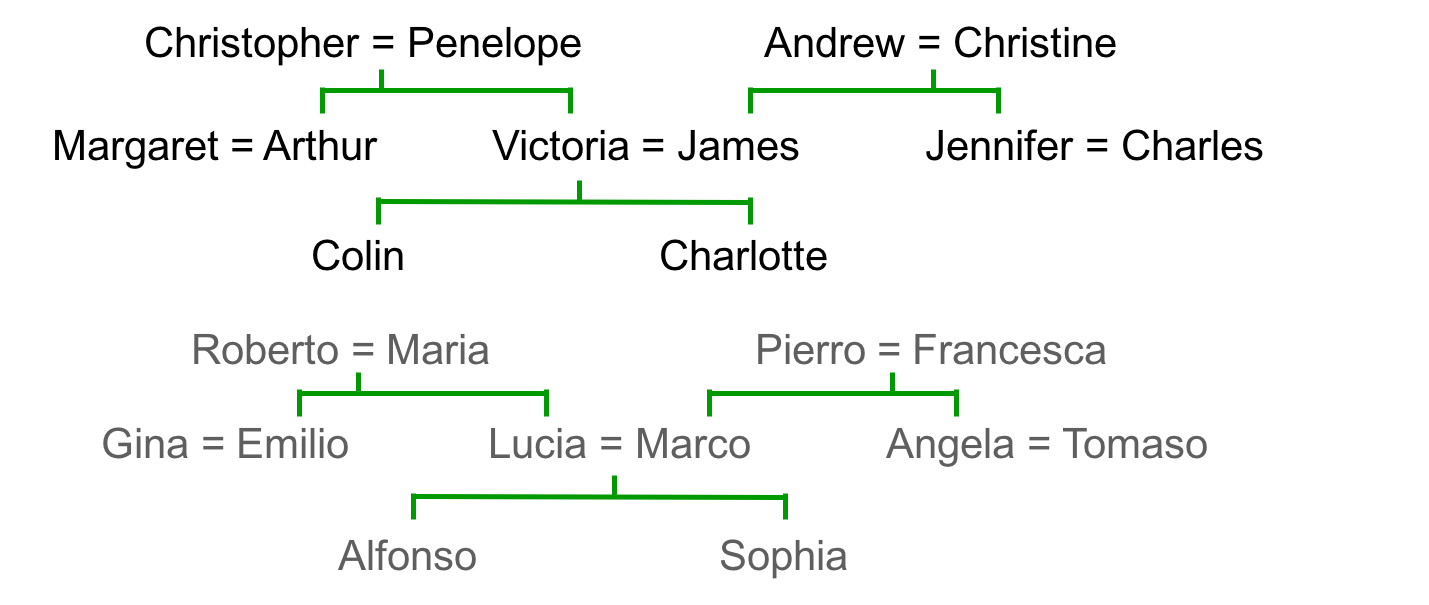

词的向量表示 关系信息的特征表示 引子很新奇,是一张英国人的家谱和一张结构相似的意大利人的家谱: 这是一种关系信息,比如甲的父亲是乙,=表示夫妻。神经网络可以通过反向传播学习这些关系对,将关系信息转为特征向量。最终的效果是,提问“乙的儿子是...

这门课的编程练习很简单,大部分代码都给出了,只需要修改或添加一小部分。官方语言为matlab,但我更喜欢Python(讨厌jupyter)。但matlab保存动画更方便,所以决定双语字幕,左右开弓。 算法主框架 这次的主题是感知机算法及可视...

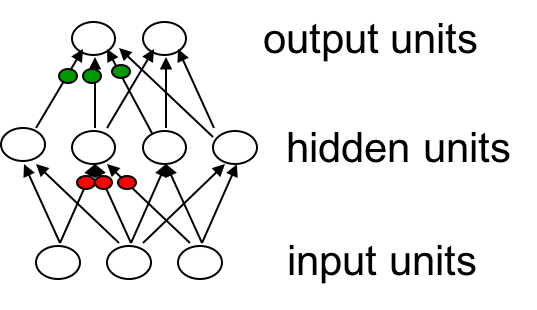

虽然反向传播很简单,但老爷子讲的更本质。另外线性回归→逻辑斯谛回归→反向传播神经网络是很多课程的必经之路。 为什么感知机算法不能用于训练隐藏层 其实前面一次课简单地提了下,说是线性隐藏层构成的模型依然是线性的。这节课展开了讲,感...

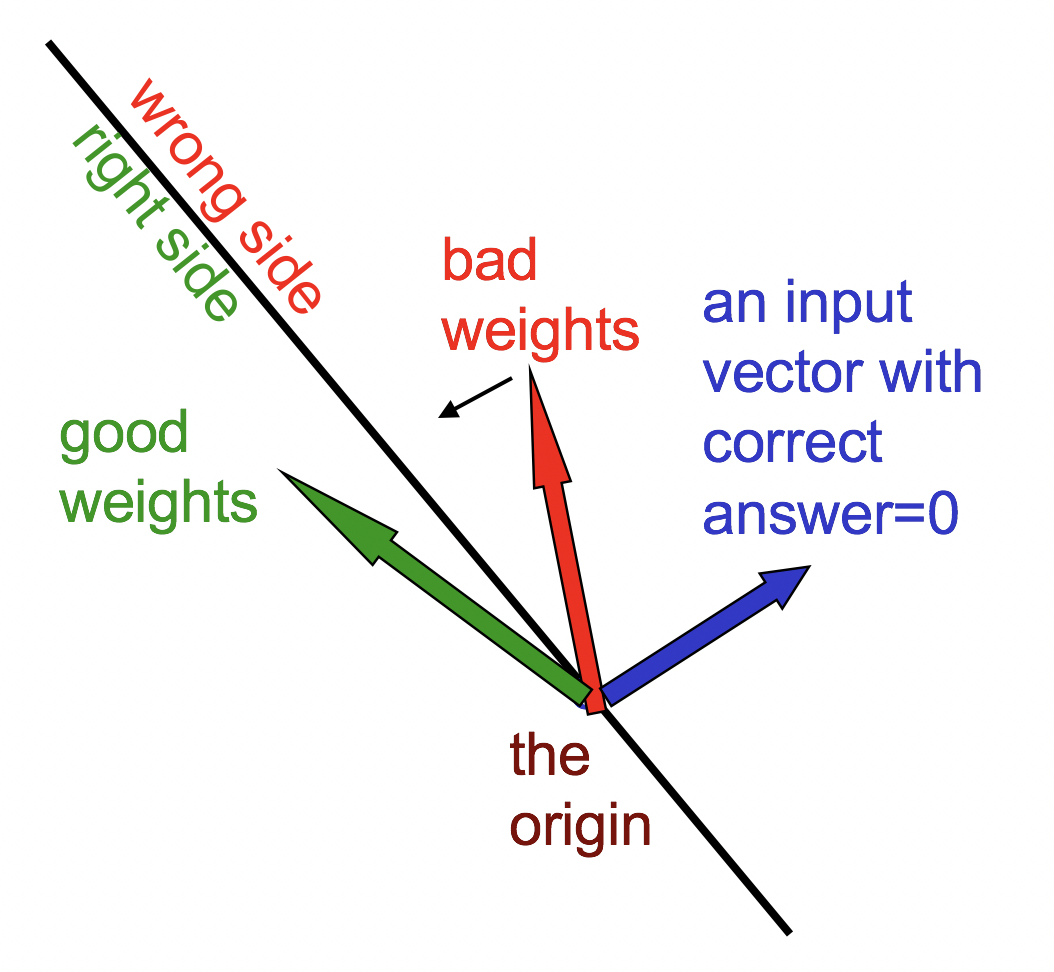

这是多伦多大学Professor Geoffrey Hinton的Neural Networks for Machine Learning公开课笔记,只记录难点,我已经掌握的知识点则不做记录。 Weight space 通常讲解感...

最后一次任务,至此速战速决解决了这门快餐课程。心得是作为一个“懒惰的工程师”,对常见的深度学习模型、技巧、应用有了浅显的了解。但对“好奇的求知者”来讲,则只能说看了一张模糊不清的缩略图,许多理论和细节得通过正式一些的课程去补充。 任务 6:...

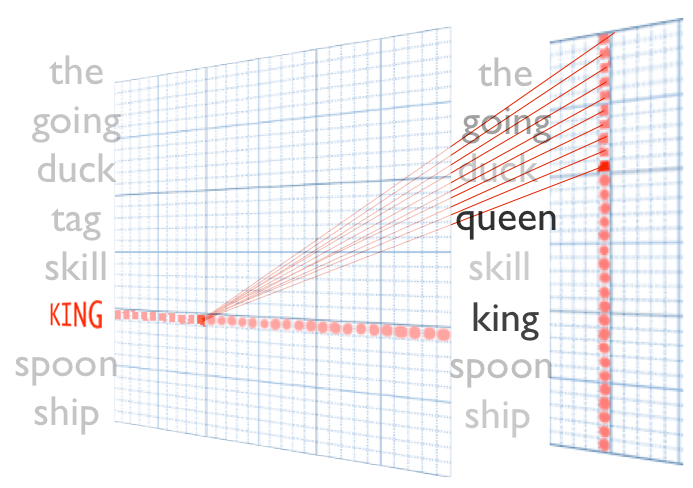

课上讲的太简略了,原理参考《word2vec原理推导与代码分析》。谷歌给的代码也很简陋,只有负采样,没有哈夫曼树。另外单机word2vec已经那么高效了,我质疑上TF的意义。 任务 5: Word2Vec&CBOW 这次的任务是在t...

课上浅显地介绍了卷积网络,以及配套的常用技巧。速成嘛,没深入探讨原理。编程任务直接给出了实现,要求也只是在其基础上做些小改进,过过干瘾。 任务 4: 卷积模型 设计并训练一个卷积神经网络。 前两次任务中,我们实现了较深的全连接多层神经网络,...

这次的看点是怎么在TensorFlow里实现正则化、dropout和学习率递减的技巧;顺便演示了下自动调参。 任务 3: 正则化 使用正则化去优化深度学习模型 题目1 给上次练习实现的逻辑斯谛回归和神经网络加上L2正则,检查性能提升。 逻辑...